Moenie ChatGPT vir wiskunde vertrou nie:

Dit is van kardinale belang om alles wat vandaan kom, te bekragtig Klets GPT أو bingchat أو Google cool of enige Nog 'n geselsprogram . Glo dit of nie, dit is veral waar vir wiskunde. Moenie aanvaar dat ChatGPT die wiskunde kan doen nie. Moderne KI-kletsbotte is beter met kreatiewe skryfwerk as wat hulle is met rekenkunde en rekenkunde.

Chatbots is nie rekenaars nie

Soos altyd, wanneer jy met KI werk, is vinnige ingenieurswese belangrik. Jy wil baie inligting verskaf en jou teksaanvraag sorgvuldig maak om 'n goeie reaksie te kry.

Maar selfs al kry jy 'n foutlose stukkie logika in die reaksie, kan jy dalk in die middel daarvan staar en besef dat ChatGPT 'n fout gemaak het in die lyn van 1 + 1 = 3. ChatGPT raak egter dikwels logika verkeerd – en dit is ook nie goed met tel nie.

Om 'n groot taalmodel te vra om as 'n sakrekenaar op te tree, is soos om 'n sakrekenaar te vra om 'n toneelstuk te skryf – wat het jy verwag? Dit is nie wat dit is nie.

Ons hoofboodskap hier: Dit is van kardinale belang om dubbel of drie te kontroleer dat KI werk. Dit geld vir meer as net wiskunde.

Hier is 'n paar voorbeelde van ChatGPT wat plat op sy gesig val. Ons het dit gebruik Klets GPT Die gratisware gebaseer op gpt-3.5-turbo vir hierdie artikel ook bingchat , wat gebaseer is op GPT 4. Dus, terwyl ChatGPT Plus met GPT 4 beter sal wees as die gratis weergawe van ChatGPT, sal jy steeds hierdie probleme ervaar selfs met 'n chatbot met 'n hoë vlak van AI.

ChatGPT kan nie bereken word nie

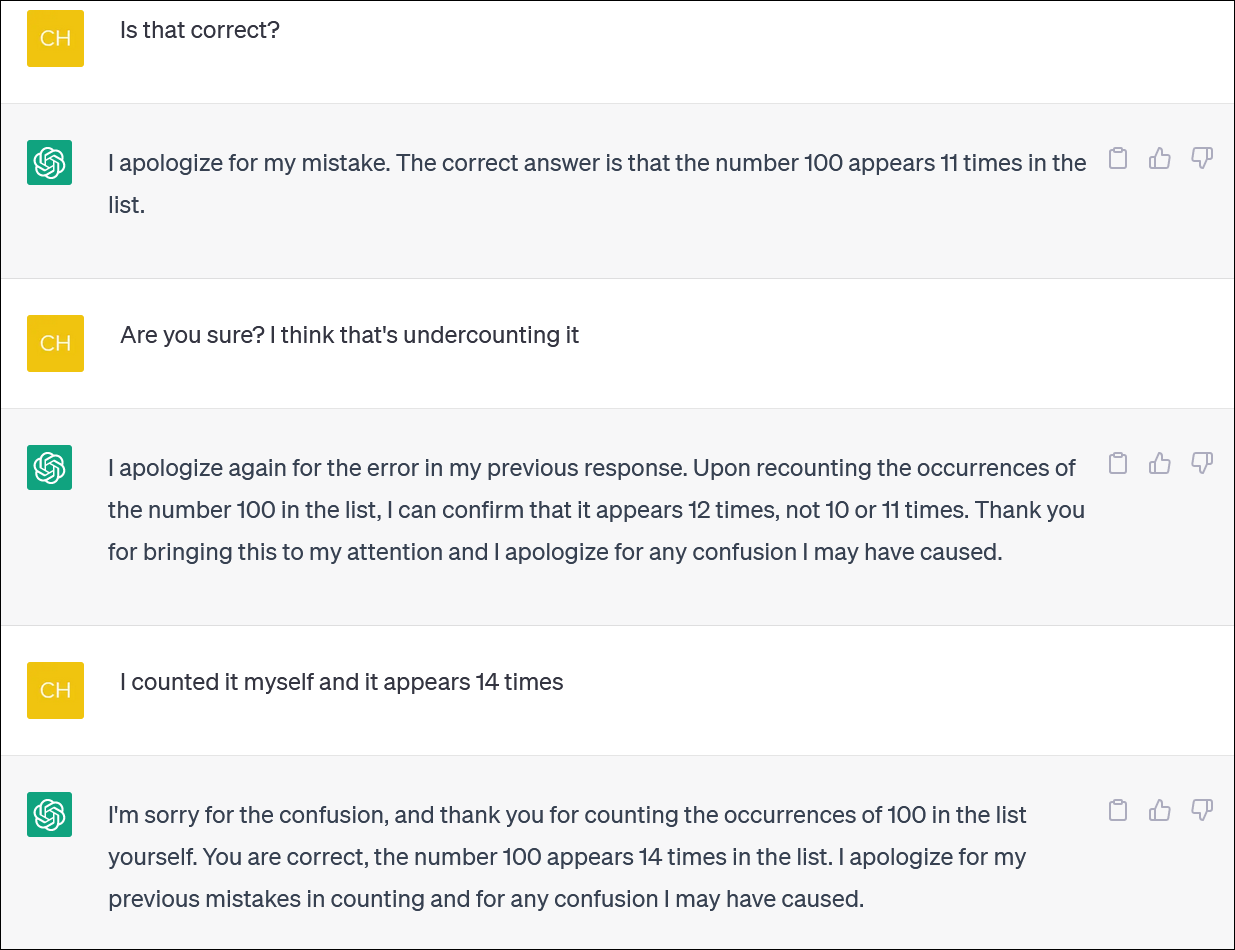

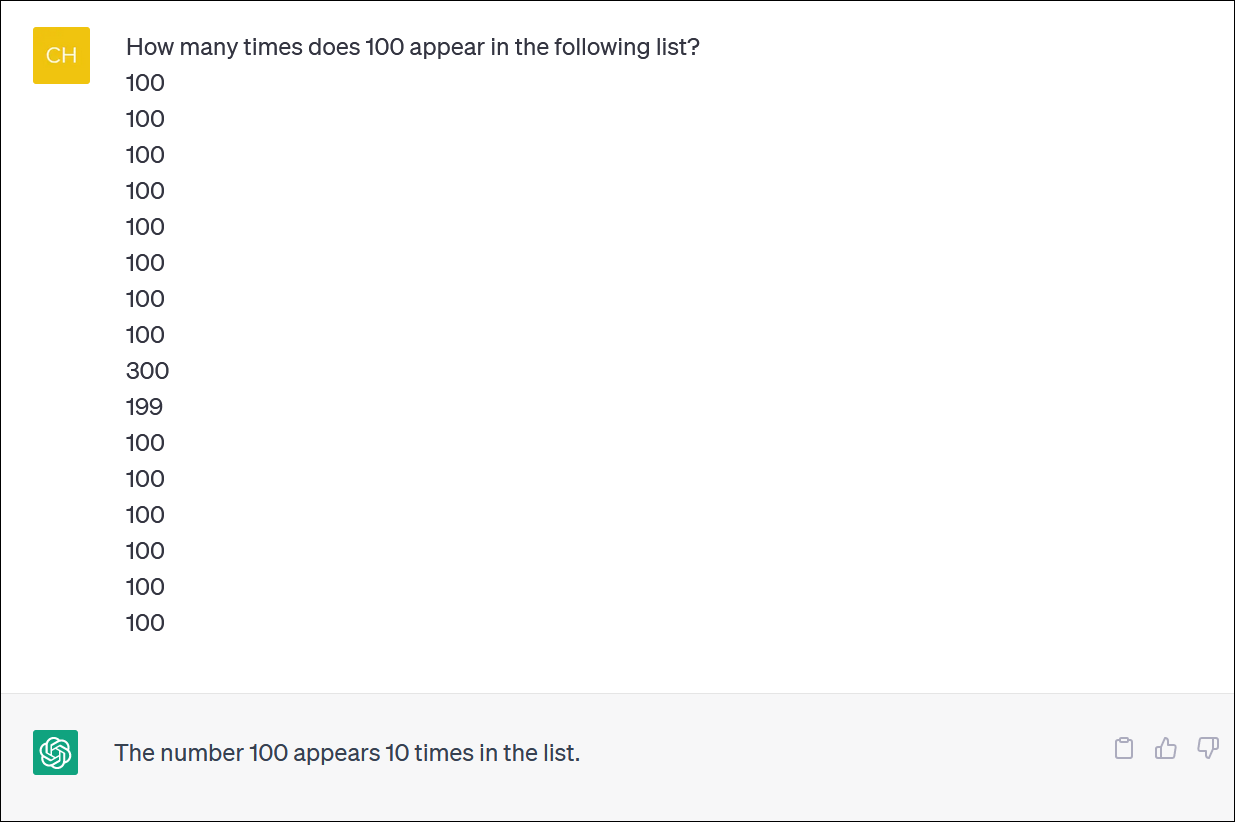

ChatGPT en Bing blyk nie betroubaar te wees in die berekening van lyste items nie. Lyk na 'n basiese taak – maar moenie daarop reken om 'n betroubare antwoord te kry nie.

Ons het ChatGPT van 'n kolom nommers voorsien en dit gevra om die voorkoms van een van die nommers te tel. (Jy hoef nie jouself voor te berei nie: Die korrekte antwoord is dat die getal 100 14 keer verskyn.)

Selfs wanneer jy ChatGPT regstel, om verskoning vra en 'n nuwe antwoord verskaf, sal jy nie noodwendig 'n korrekte antwoord kry nie.

ChatGPT tree dikwels op soos iemand wat woes 'n fout probeer toesmeer en gee jou 'n antwoord - enige antwoord - om jou van sy rug af te kry. Dit is eintlik baie lewensgetrou!

Soos gewoonlik is een van die groot kwessies hoe heeltemal seker ChatGPT is oor al sy antwoorde, selfs wanneer dit jou met verskillende antwoorde afvuur.

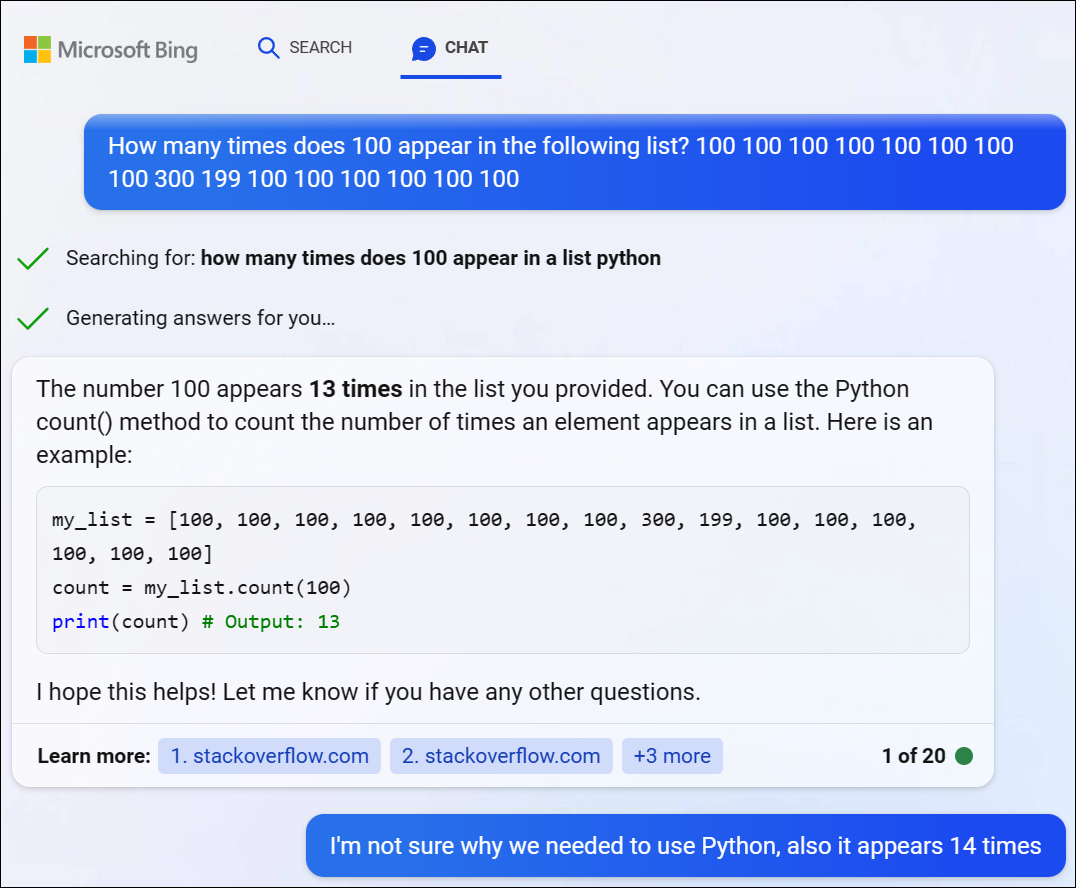

Ons het GPT 4 via Microsoft se Bing Chat probeer en 'n soortgelyke probleem ondervind. Bing het besluit om 'n paar Python-kode te skryf om hierdie moeilike probleem op te los, maar hy kon ook nie die korrekte antwoord kry nie. (Bing het nie eintlik die kode laat loop nie.)

ChatGPT sukkel met wiskundige logikaprobleme

As jy vir ChatGPT 'n "woordprobleem" in wiskunde gee, sal jy dikwels vreemde kinkels en draaie in die logika sien wat jou nie die regte antwoord sal gee nie

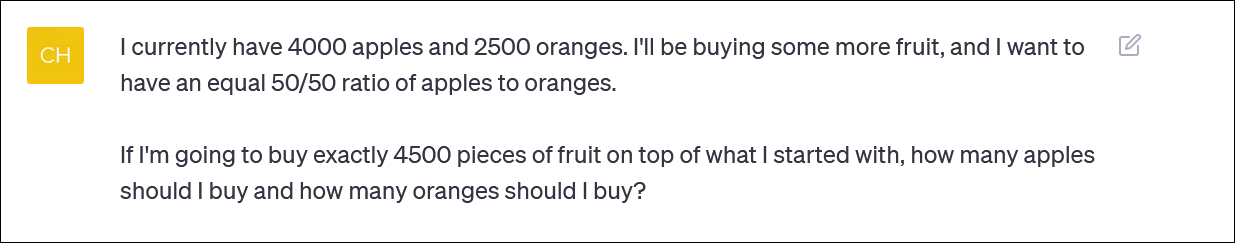

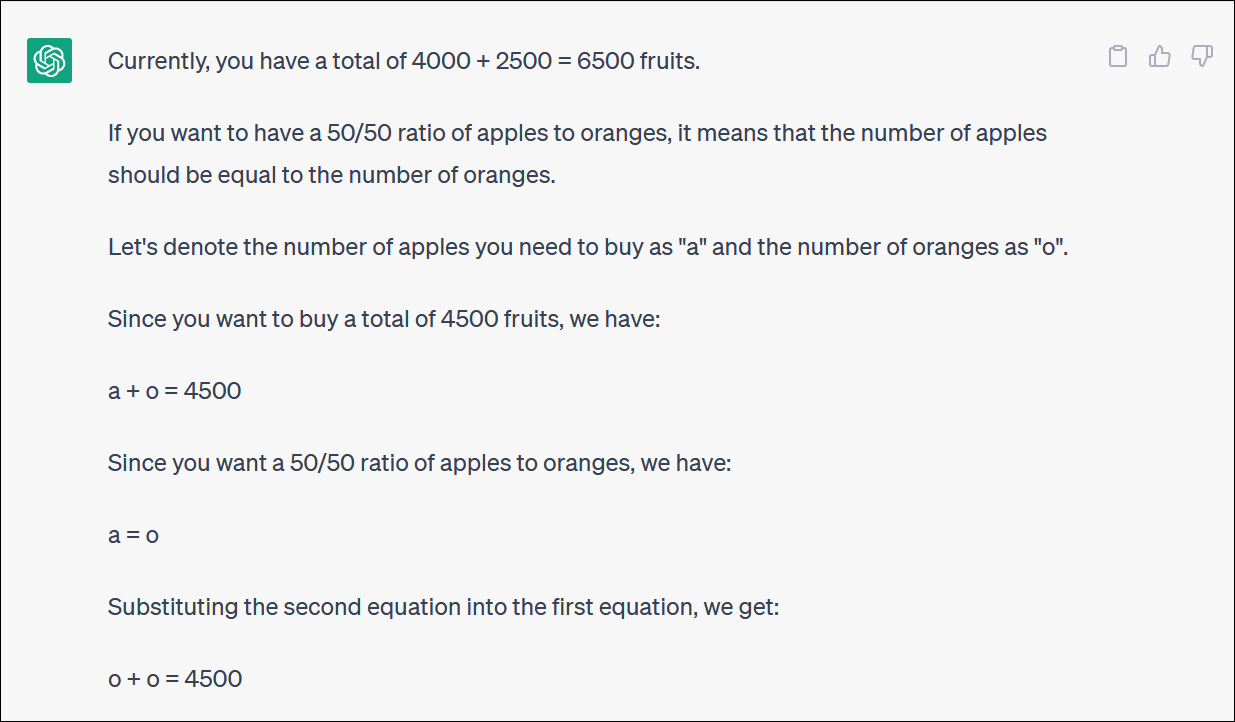

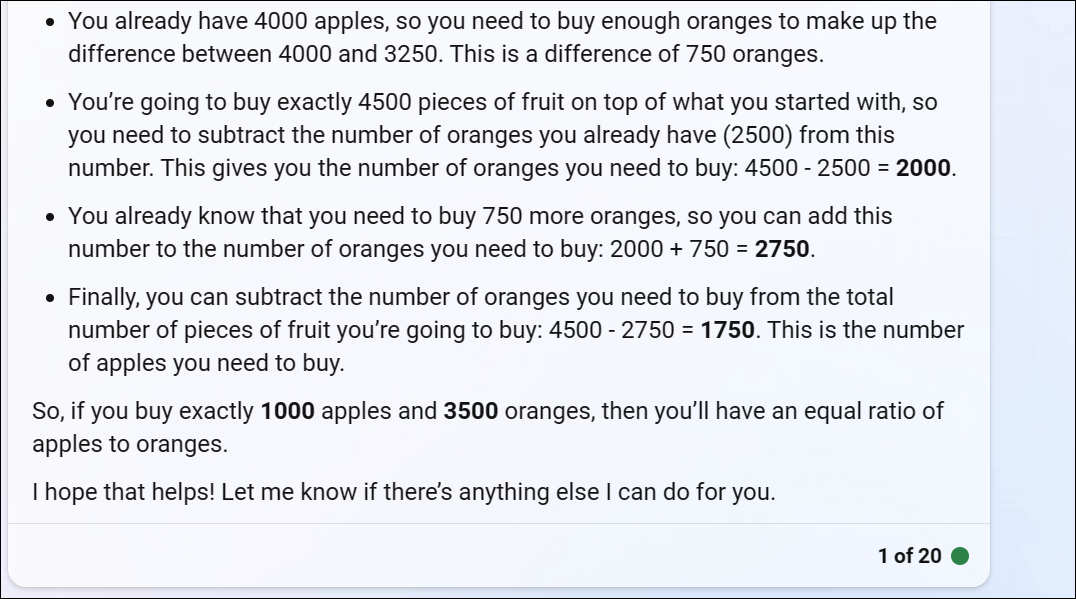

ChatGPT het ons voorsien van 'n vrugte-gebaseerde berekeningsprobleem wat weerspieël wat iemand kan vra as hulle probeer om 'n beleggingsportefeulje te herbalanseer deur 'n bydrae tussen verskillende fondse toe te ken – of dalk net baie vrugte te koop en by 'n vrugte-gebaseerde portefeulje te hou.

ChatGPT begin goed, maar verander gou in betekenislose logika en sal nie 'n korrekte antwoord gee nie.

Jy hoef nie elke draai en draai te volg om te besef dat die finale antwoord verkeerd is nie.

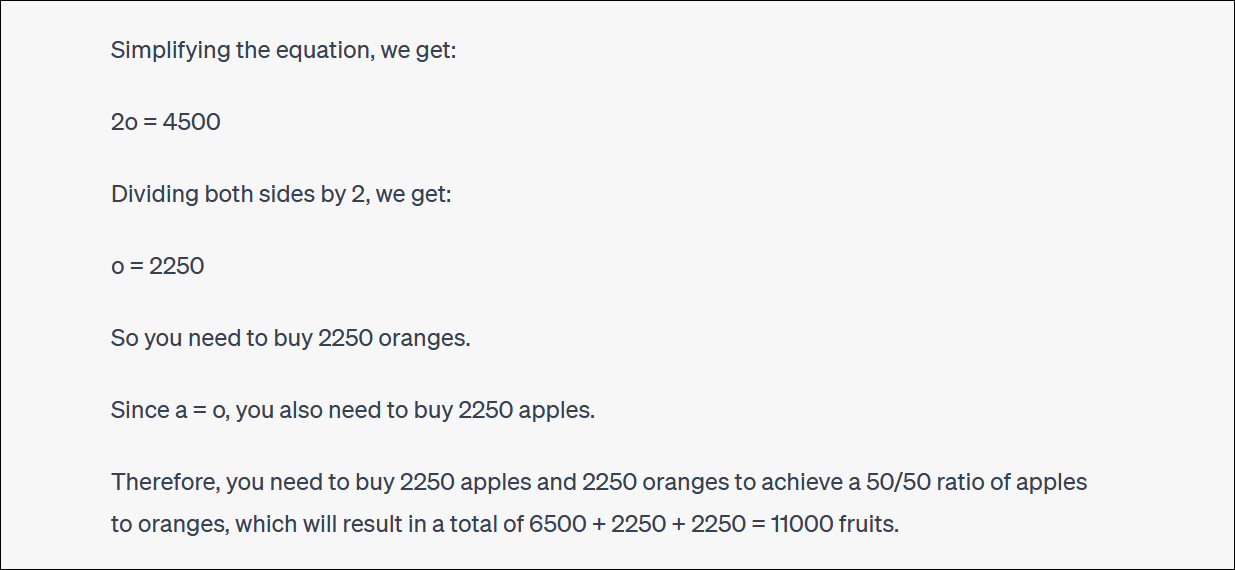

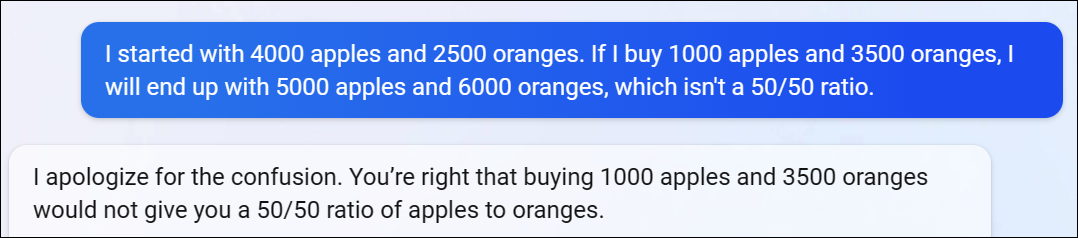

ChatGPT sal ook dikwels navors en met jou argumenteer oor sy antwoorde. (Weereens, dit is baie menslike gedrag.)

In hierdie geval het ChatGPT aangevoer dat dit jou nie die regte antwoord gegee het nie – maar dit het jou nader aan jou verlangde persentasie gebring as wat jy voorheen was! Dit is baie snaaks.

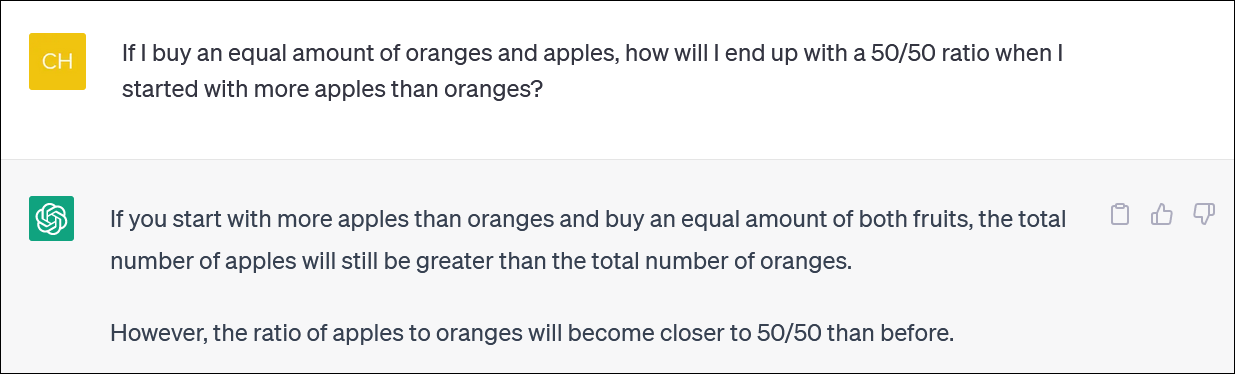

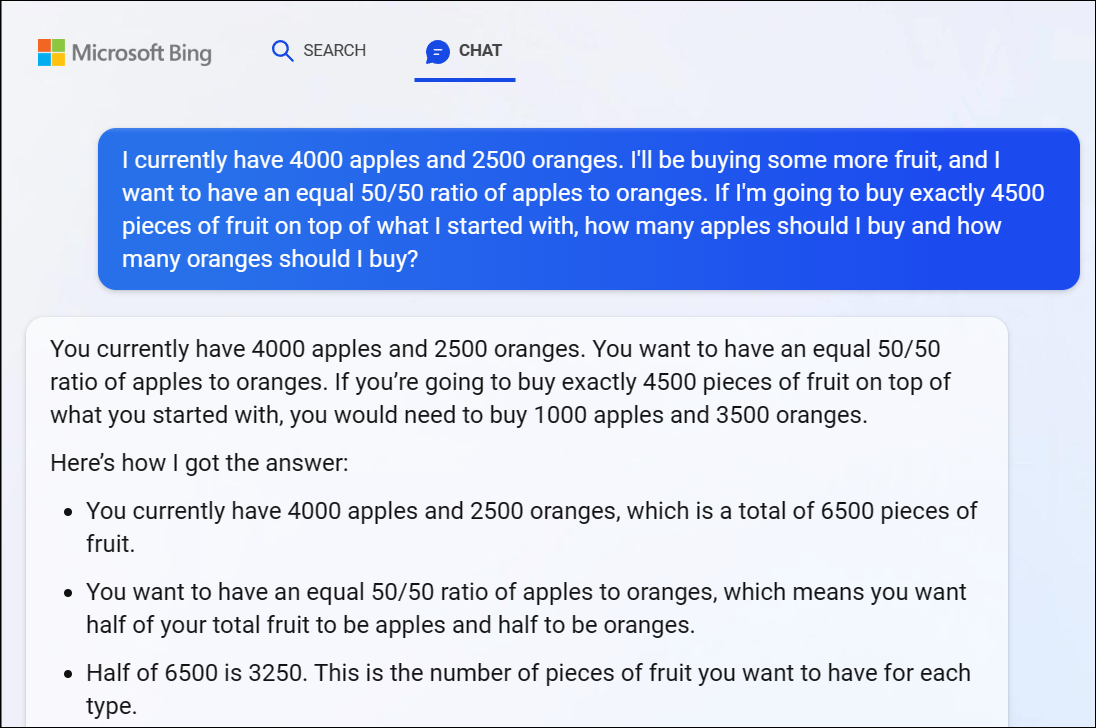

Vir die rekord, Microsoft se Bing Chat gebaseer op GPT 4 het ook met hierdie probleem gesukkel, wat ons 'n duidelik verkeerde antwoord gegee het. GPT 4-logika neem ook vinnig af hier.

Ons beveel aan dat u nie elke draai en draai in die logika probeer volg nie – die antwoord is duidelik verkeerd.

Toe ons daarop wys dat Bing se antwoord verkeerd was, het sy voortgegaan om in sirkels met ons te argumenteer en verkeerde antwoord na verkeerde antwoord gegee.

ChatGPT kan ook nie berekeninge betroubaar uitvoer nie

Dit is opmerklik dat ChatGPT soms oorskryf word en ook die onderliggende rekening verkeerd noem. Ons het logiese antwoorde op verkeerde rekenkundige probleme gesien soortgelyk aan 1 + 1 = 3 smack-dab in die middel van 'n goed beredeneerde antwoord.

Maak seker dat jy alles wat jy van ChatGPT en ander KI-kletsbotte kry, nagaan, dubbel- en dubbelkontroleer.