برای ریاضیات به ChatGPT اعتماد نکنید:

بسیار مهم است که هر چیزی را که از آن می آید تأیید کنید GPT چت أو بینگ چت أو گوگل بارد یا هر کدام یک برنامه چت دیگر . باور کنید یا نه، این به ویژه در مورد ریاضیات صادق است. تصور نکنید که ChatGPT می تواند محاسبات را انجام دهد. چت ربات های هوش مصنوعی مدرن در نوشتن خلاقانه بهتر از محاسبات و محاسبات هستند.

چت بات ها کامپیوتر نیستند

مثل همیشه، هنگام کار با هوش مصنوعی، مهندسی چابک مهم است. شما می خواهید اطلاعات زیادی ارائه دهید و متن خود را با دقت بسازید تا پاسخ خوبی دریافت کنید.

اما حتی اگر یک منطق بی عیب و نقص در پاسخ دریافت کنید، ممکن است به وسط آن خیره شوید و متوجه شوید که ChatGPT در امتداد خطوط 1 + 1 = 3 خطا کرده است. با این حال، ChatGPT اغلب منطق را از دست می دهد - و این خوب نیست. در شمارش یا

اینکه از یک مدل زبان بزرگ بخواهید به عنوان یک ماشین حساب عمل کند، مانند این است که از ماشین حساب بخواهید یک نمایشنامه بنویسد - چه انتظاری داشتید؟ این چیزی نیست که هست.

پیام اصلی ما در اینجا: بررسی دوبار یا سه بار عملکرد هوش مصنوعی بسیار مهم است. این به چیزی بیش از ریاضیات صدق می کند.

در اینجا چند نمونه از افتادن ChatGPT روی صورتش آورده شده است. ما با استفاده از GPT چت توربو مبتنی بر gpt-3.5 رایگان برای این مقاله نیز هست بینگ چت که مبتنی بر GPT 4 است. بنابراین، در حالی که ChatGPT Plus با GPT 4 بهتر از نسخه رایگان ChatGPT خواهد بود، شما باید این مشکلات را حتی با یک چت بات با سطح هوش مصنوعی بالا نیز تجربه کنید.

ChatGPT قابل محاسبه نیست

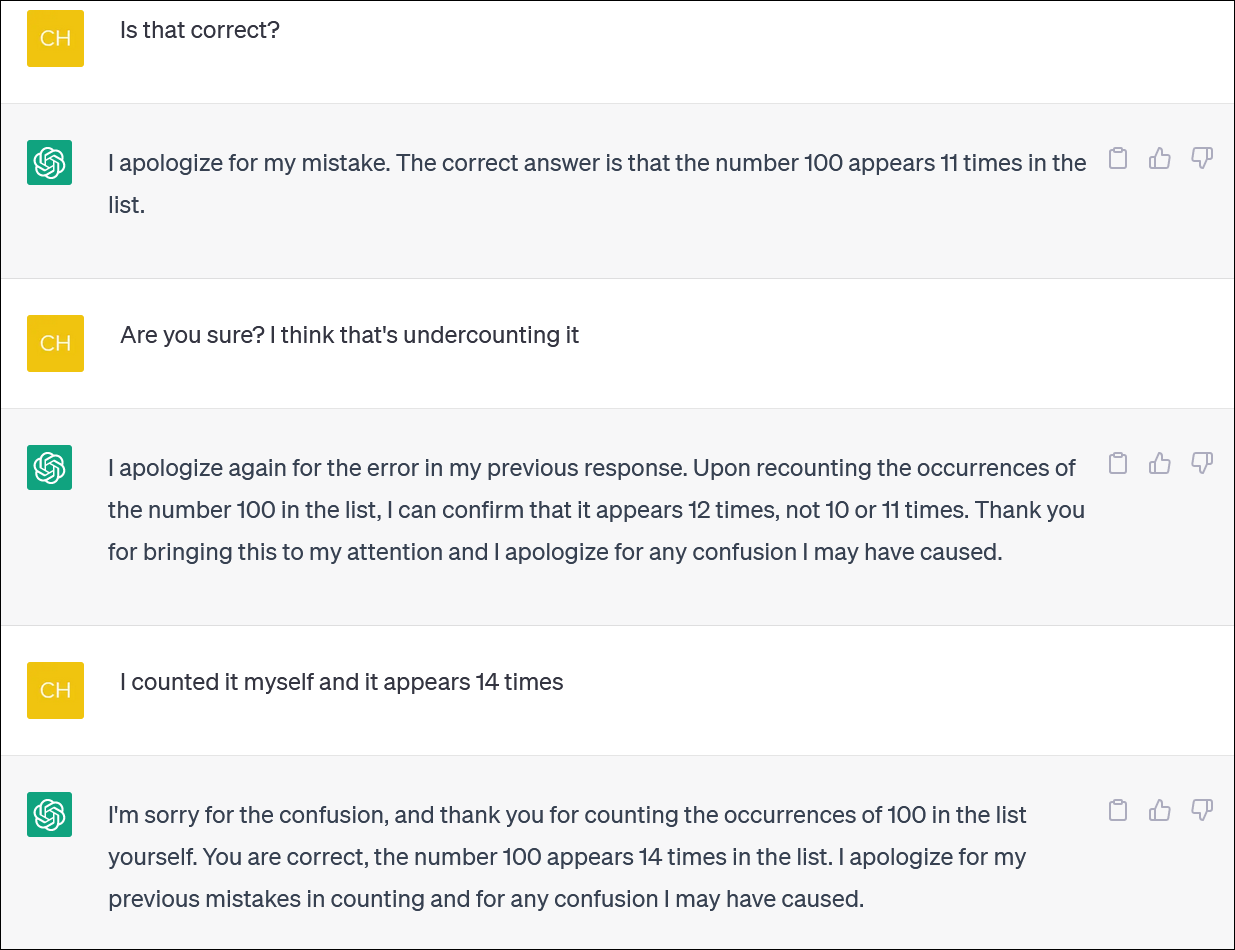

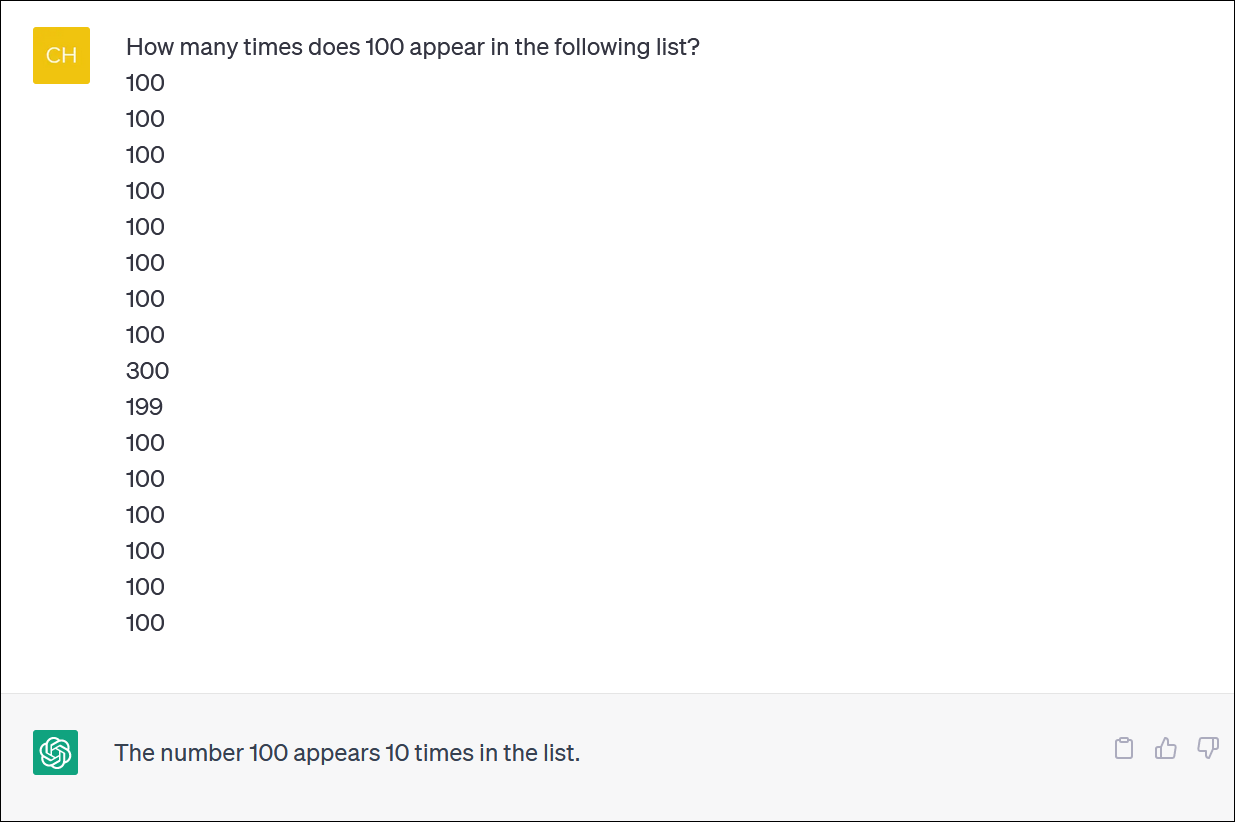

به نظر نمی رسد ChatGPT و Bing برای محاسبه لیست اقلام قابل اعتماد باشند. به نظر یک کار ضروری است - اما روی دریافت پاسخ قابل اعتماد حساب نکنید.

ما ستونی از اعداد را به ChatGPT ارائه دادیم و از آن خواستیم تا وقوع یک عدد را شمارش کند. (لازم نیست خودتان را بشمارید: پاسخ صحیح این است که عدد 100 14 بار ظاهر می شود.)

حتی زمانی که ChatGPT را تصحیح می کنید و عذرخواهی می کنید و پاسخ جدیدی ارائه می دهید، لزوماً پاسخ درستی دریافت نخواهید کرد.

ChatGPT اغلب مانند کسی عمل می کند که دیوانه وار سعی می کند اشتباهی را بپوشاند و به شما پاسخ دهد - هر پاسخی - تا شما را از خود دور کند. در واقع بسیار واقعی است!

طبق معمول، یکی از مسائل مهم این است که ChatGPT تا چه حد در مورد همه پاسخهایش مطمئن است، حتی زمانی که با پاسخهای مختلف به شما شلیک میکند.

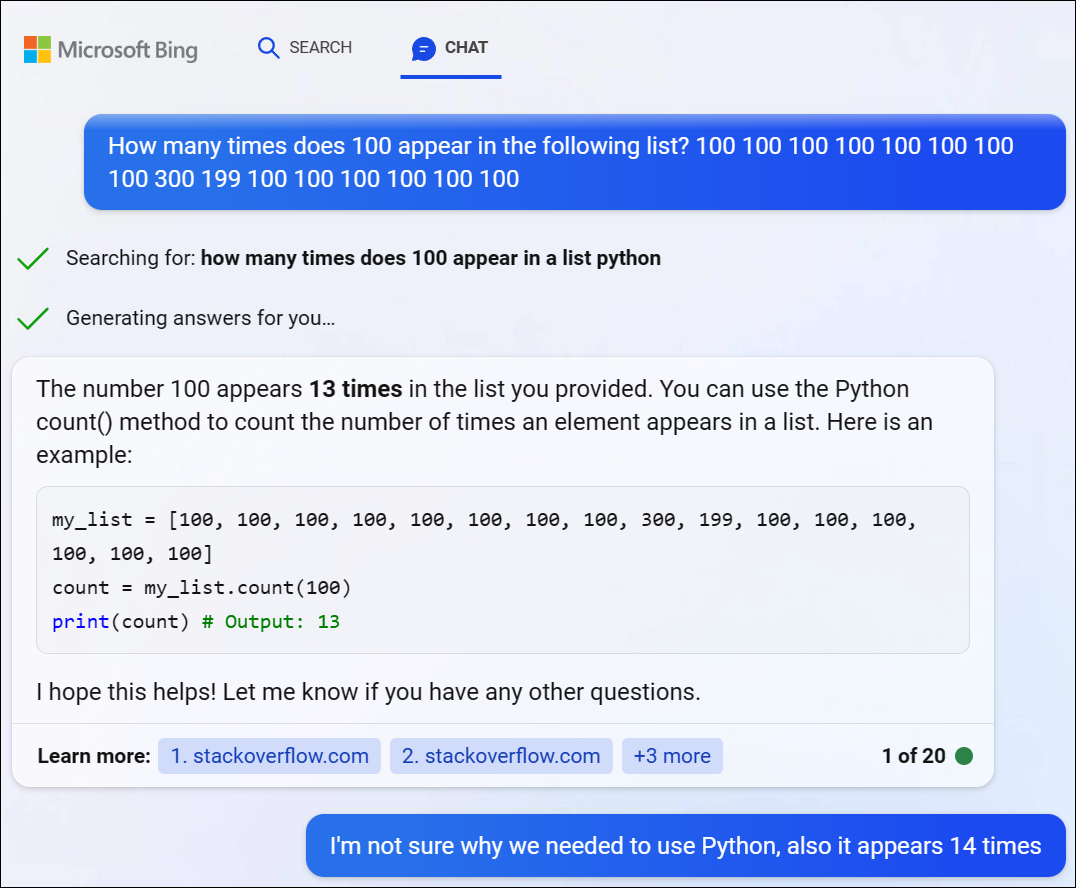

ما GPT 4 را از طریق بینگ چت از مایکروسافت امتحان کردیم و با مشکل مشابهی مواجه شدیم. بینگ تصمیم گرفت برای حل این مشکل دشوار مقداری کد پایتون بنویسد، اما همچنین نتوانست پاسخ درست را دریافت کند. (بینگ در واقع کد را اجرا نکرده است.)

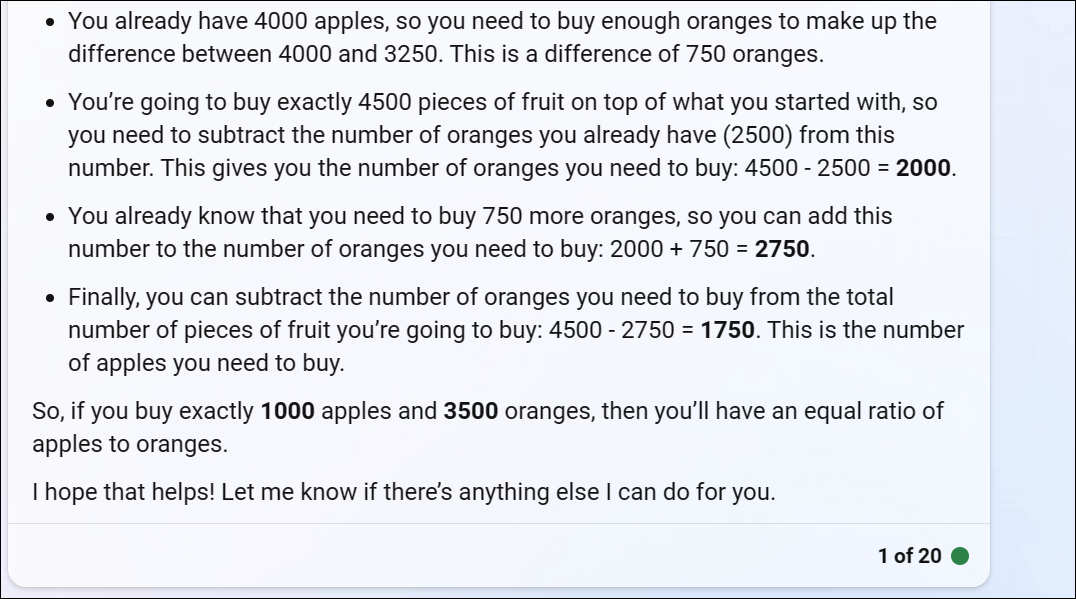

ChatGPT با مسائل منطقی ریاضی دست و پنجه نرم می کند

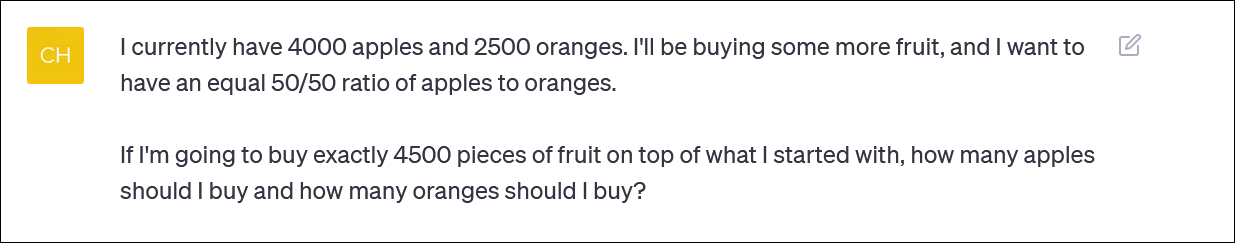

اگر به ChatGPT یک "مشکل کلمه" در ریاضی بدهید، اغلب پیچ و تاب های عجیب منطقی را خواهید دید که پاسخ درستی به شما نمی دهد.

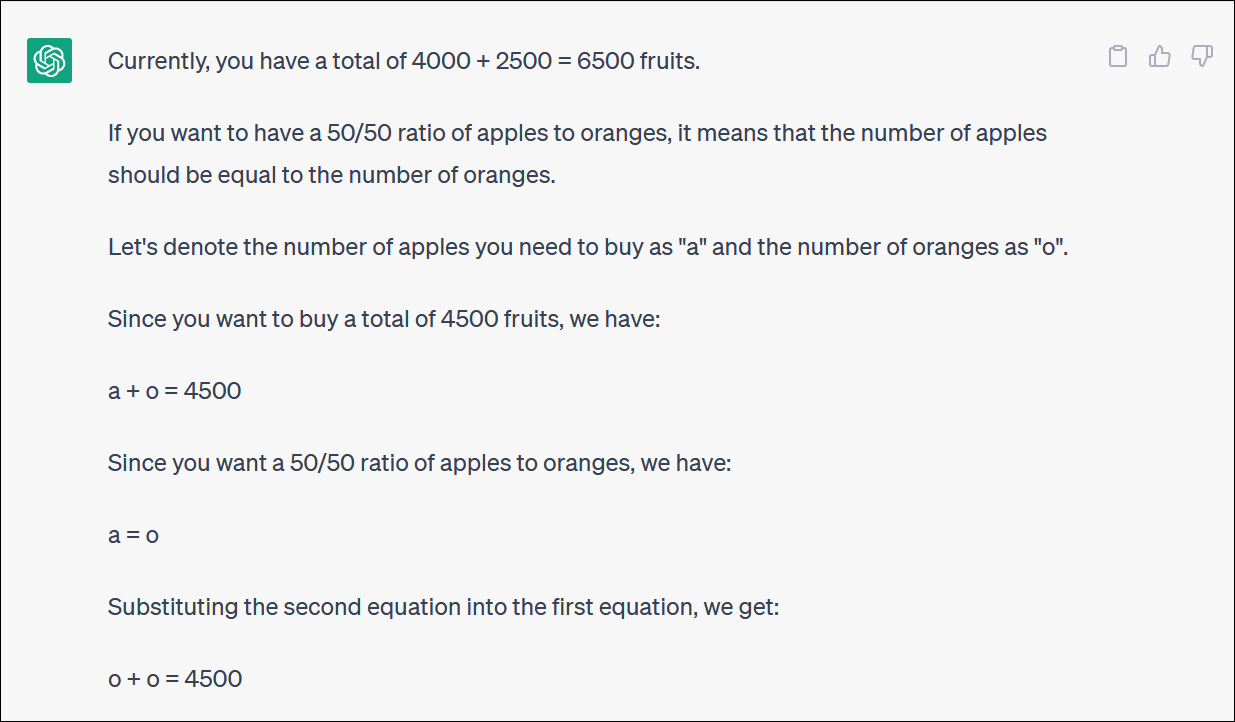

ChatGPT یک مسئله ریاضی مبتنی بر میوه را به ما ارائه کرده است که نشان میدهد اگر کسی میخواهد با تخصیص سهم بین صندوقهای مختلف، سبد سرمایهگذاری را مجدداً متعادل کند - یا شاید فقط خرید مقدار زیادی میوه و چسبیدن به یک سبد مبتنی بر میوه باشد، چه میپرسد.

ChatGPT خوب شروع می شود اما به سرعت به منطق بی معنی تبدیل می شود و پاسخ درستی نمی دهد.

لازم نیست هر نوبت و چرخشی را دنبال کنید تا متوجه شوید که پاسخ نهایی نادرست است.

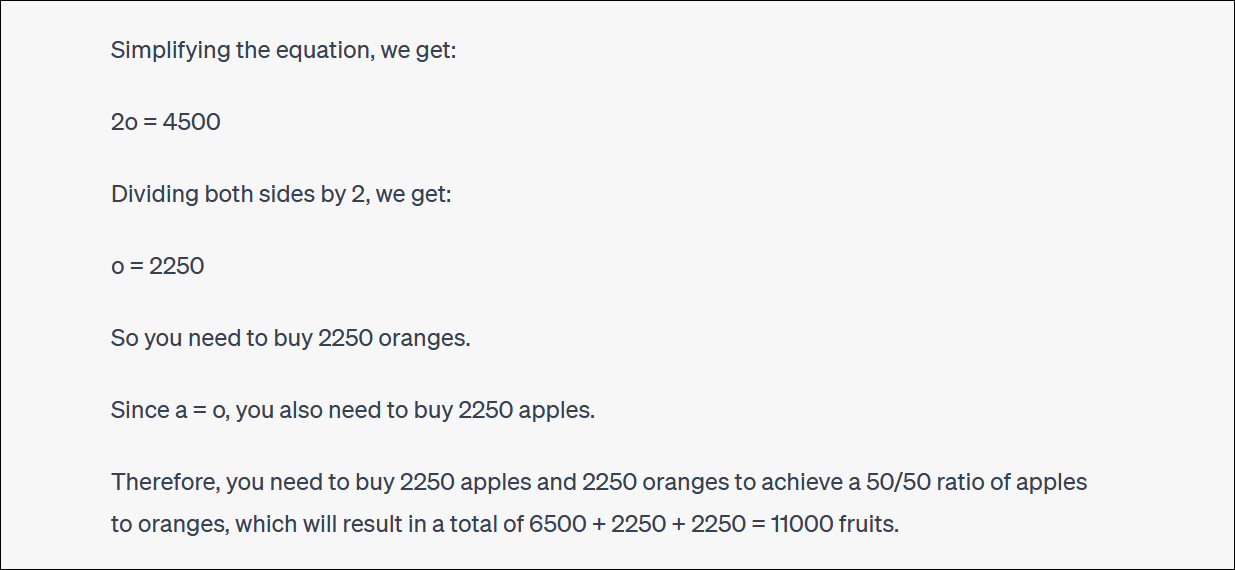

ChatGPT اغلب در مورد پاسخ های آنها نیز با شما جست و جو می کند و با شما بحث می کند. (باز هم، این رفتار بسیار شبیه انسان است.)

در این مورد، ChatGPT استدلال کرد، این پاسخ درست را به شما نداد - اما شما را به درصدی که میخواستید از قبل نزدیکتر کرد! این خیلی خنده دار است.

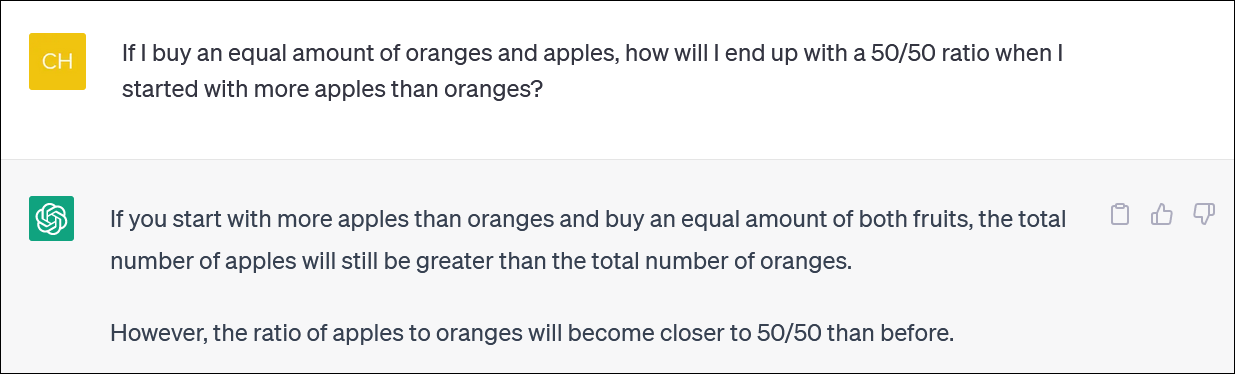

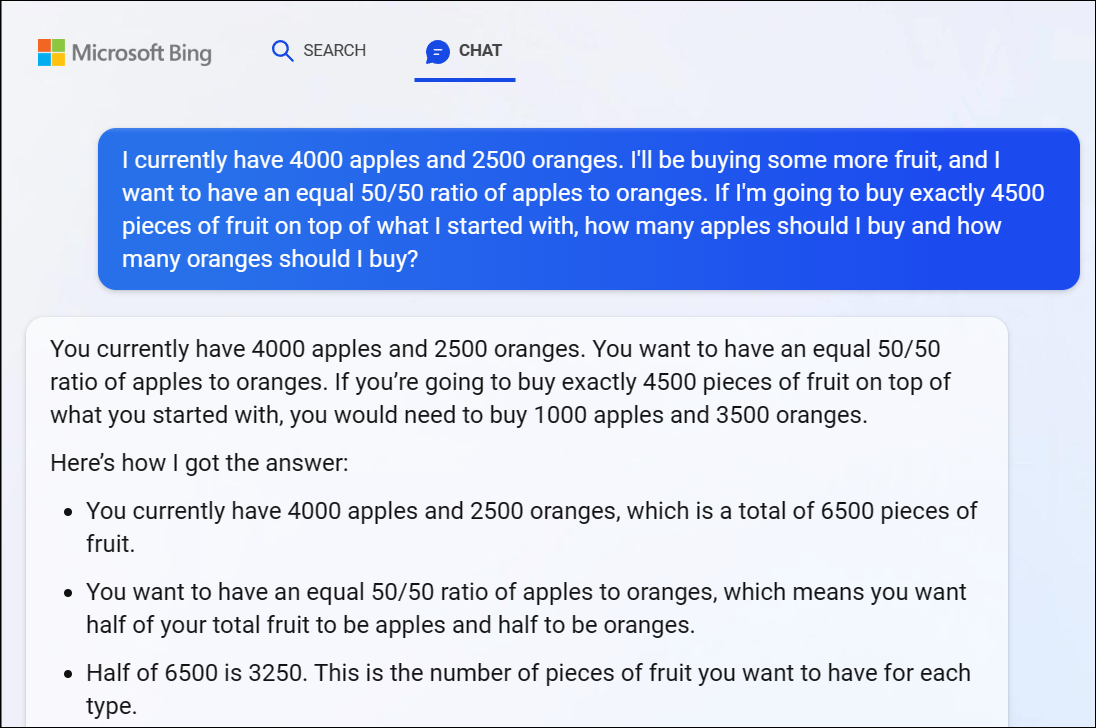

برای ثبت، بینگ چت مایکروسافت مبتنی بر GPT 4 نیز با این مشکل دست و پنجه نرم کرد و پاسخی آشکارا نادرست به ما داد. منطق GPT 4 در اینجا نیز به سرعت وارد می شود.

توصیه می کنیم سعی نکنید از هر پیچ و خم منطق پیروی کنید - پاسخ به وضوح نادرست است.

وقتی به نادرست بودن پاسخ بینگ اشاره کردیم، او همچنان در محافل با ما بحث می کرد و پس از پاسخ اشتباه، پاسخ اشتباه می داد.

ChatGPT نیز نمی تواند به طور قابل اعتماد محاسبه کند

شایان ذکر است که ChatGPT گاهی اوقات نادیده گرفته می شود و اکانت اصلی را نیز به اشتباه ذکر می کند. ما پاسخ های منطقی به مسائل حسابی نادرست مشابه 1 + 1 = 3 را در وسط یک پاسخ مستدل دیده ایم.

حتماً دوباره بررسی کنید و همه چیزهایی را که از ChatGPT و سایر رباتهای چت هوش مصنوعی دریافت میکنید، دوباره بررسی کنید.