Non confíes en ChatGPT para matemáticas:

É fundamental validar todo o que vén Chat GPT أو Chat de Bing أو Google xenial ou calquera Outro programa de chat . Créalo ou non, isto é especialmente certo para as matemáticas. Non asumas que ChatGPT pode facer as contas. Os chatbots modernos de intelixencia artificial son mellores na escritura creativa que en aritmética e aritmética.

Os chatbots non son ordenadores

Como sempre, cando se traballa con IA, a enxeñería áxil é importante. Queres proporcionar moita información e elaborar o teu texto con coidado para obter unha boa resposta.

Pero aínda que obteñas unha peza de lóxica perfecta na resposta, podes mirar no medio dela e darte conta de que ChatGPT cometeu un erro na liña de 1 + 1 = 3. Non obstante, ChatGPT adoita perder a lóxica, e non é bo. ao contar tampouco.

Pedirlle a un gran modelo lingüístico que actúe como calculadora é como pedirlle a unha calculadora que escriba unha obra de teatro: que esperabas? Iso non é o que é.

A nosa mensaxe principal aquí: é fundamental verificar dúas veces ou tres veces o funcionamento da IA. Isto aplícase a algo máis que ás matemáticas.

Aquí tes algúns exemplos de ChatGPT caendo de cara. Usamos Chat GPT O turbo gratuíto baseado en gpt-3.5 para este artigo tamén Chat de Bing , que está baseado en GPT 4. Así, aínda que ChatGPT Plus con GPT 4 será mellor que a versión gratuíta de ChatGPT, terás que experimentar estes problemas mesmo cun chatbot cun alto nivel de IA.

ChatGPT non se pode calcular

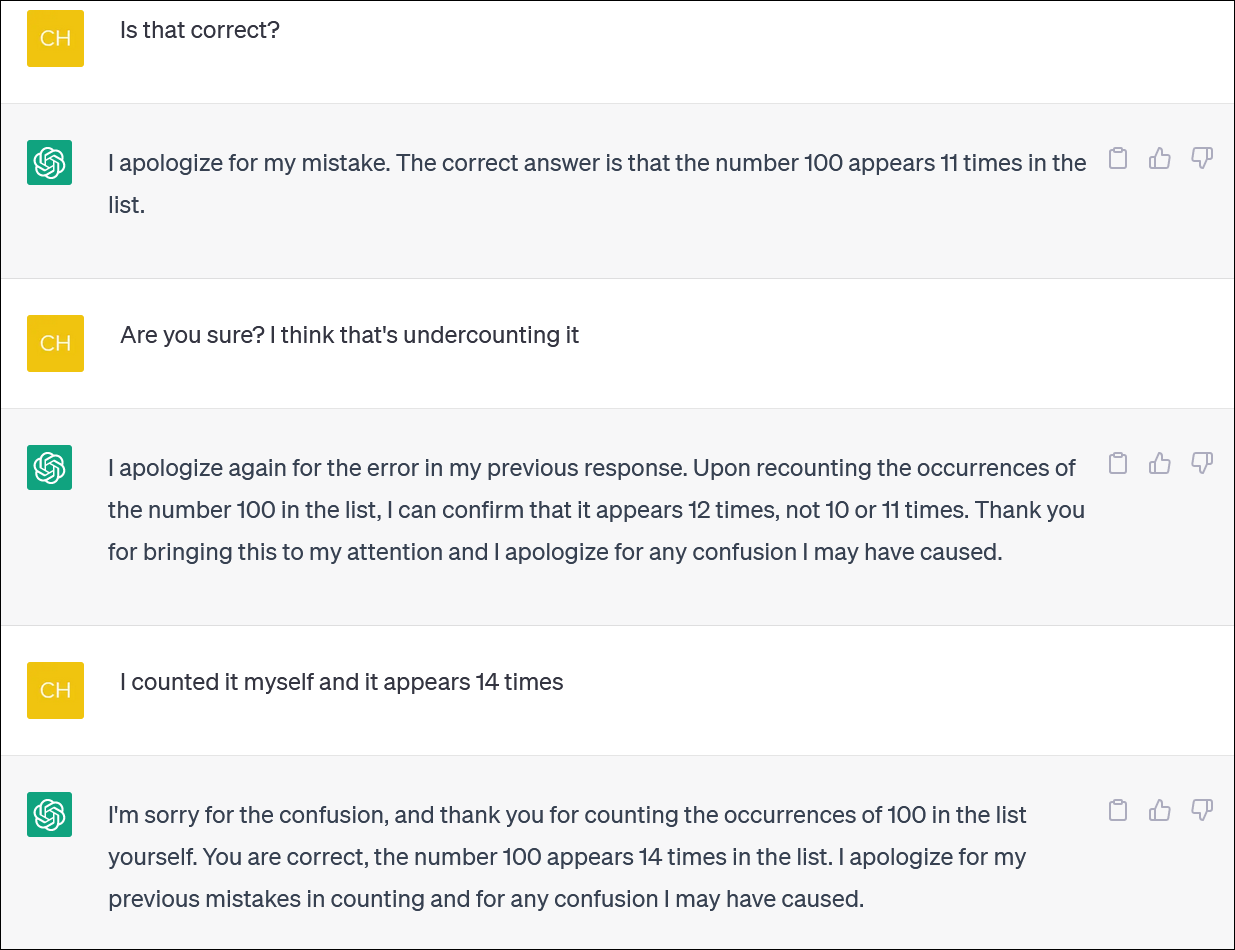

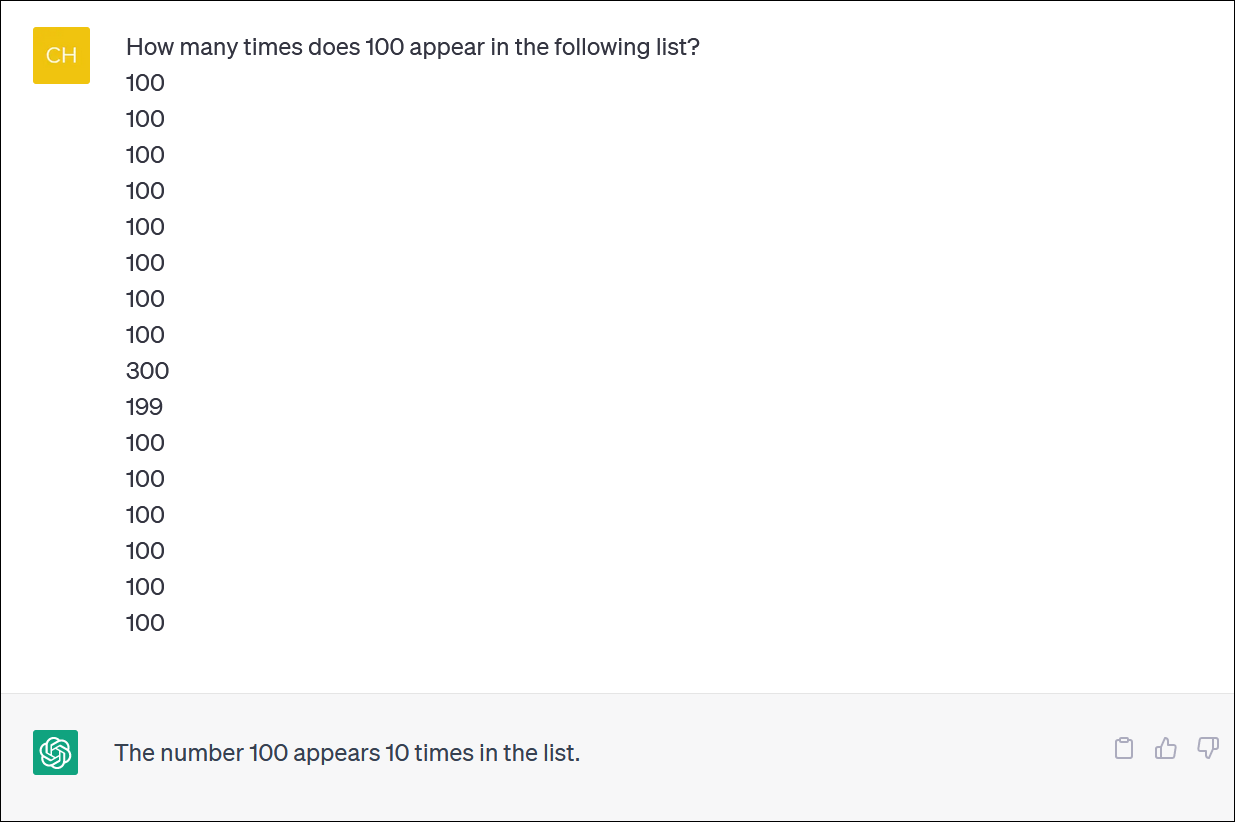

ChatGPT e Bing non parecen ser fiables para calcular listas de elementos. Parece unha tarefa esencial, pero non conte con obter unha resposta fiable.

Fornecemos a ChatGPT unha columna de números e pedímoslle que contase as aparicións dun número. (Non tes que contar: a resposta correcta é que o número 100 aparece 14 veces).

Mesmo cando corrixas ChatGPT e desculpas e proporcionas unha nova resposta, non necesariamente obterás unha resposta correcta.

ChatGPT adoita actuar como alguén que tenta frenéticamente encubrir un erro e darche unha resposta, calquera resposta, para quitarte as súas costas. En realidade é moi realista!

Como é habitual, un dos grandes problemas é o que está absolutamente seguro de que ChatGPT ten todas as súas respostas, mesmo cando che dispara con respostas diferentes.

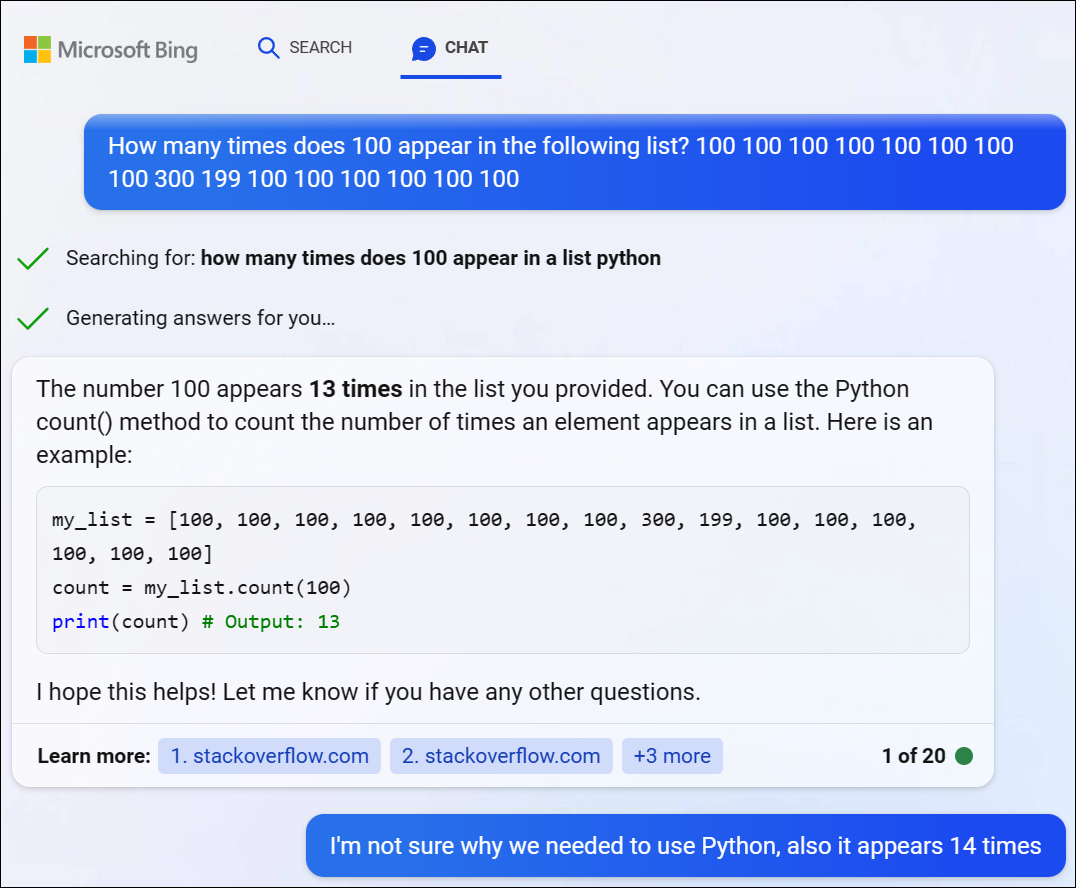

Probamos GPT 4 a través de Bing Chat de Microsoft e atopamos un problema similar. Bing decidiu escribir algún código Python para resolver este problema difícil, pero tampouco conseguiu a resposta correcta. (Bing non executou o código en realidade).

ChatGPT loita con problemas de lóxica matemática

Se lle dás a ChatGPT un "problema de palabras" en matemáticas, moitas veces verás reviravoltas estrañas de lóxica que non che darán a resposta correcta.

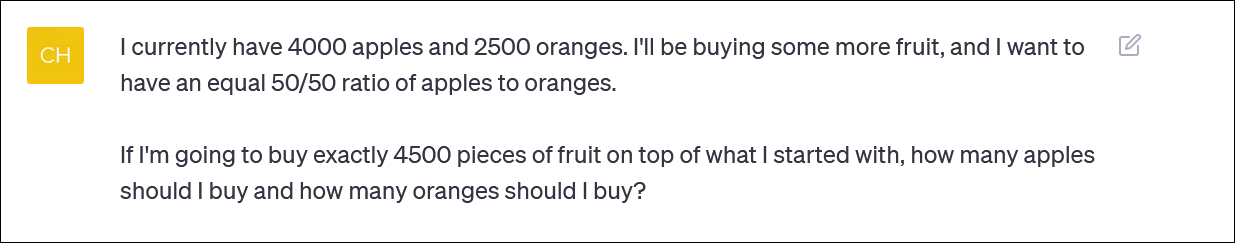

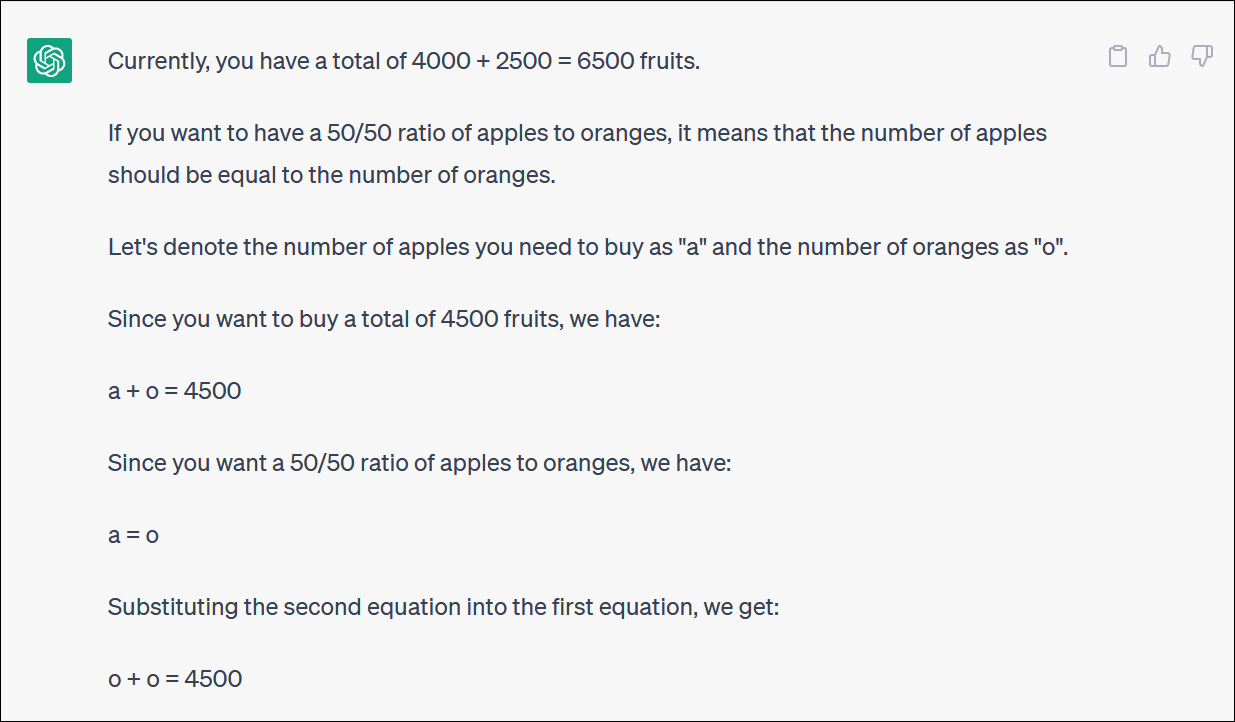

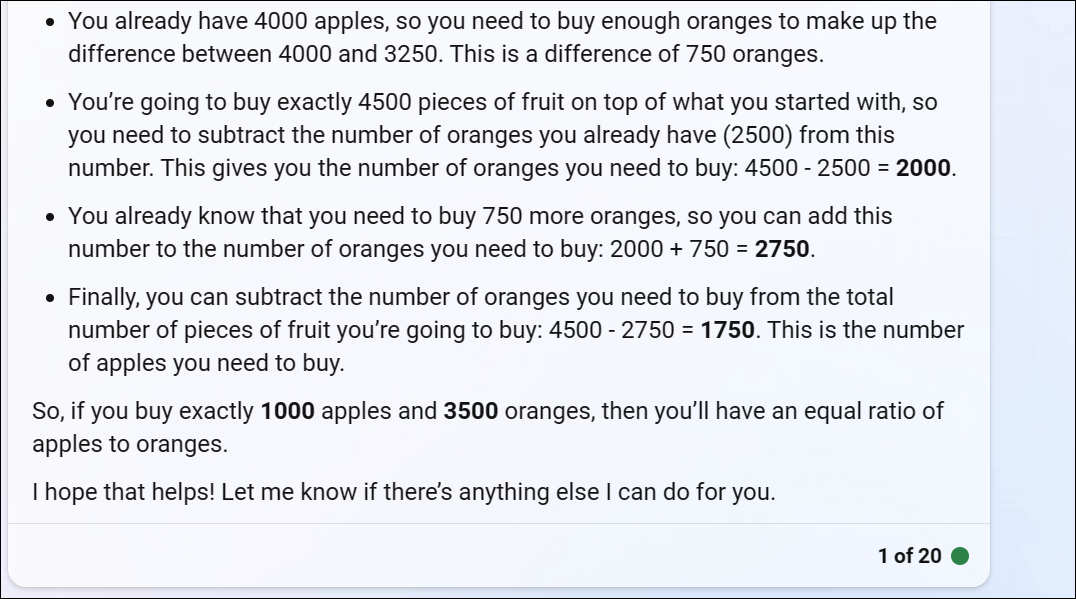

ChatGPT proporcionounos un problema matemático baseado en froitas que reflicte o que alguén podería preguntar se estivese tentando reequilibrar unha carteira de investimento asignando unha contribución entre diferentes fondos, ou quizais simplemente comprando moita froita e uníndose a unha carteira baseada en froitas.

ChatGPT comeza ben pero rapidamente se transforma nunha lóxica sen sentido e non dará unha resposta correcta.

Non tes que seguir todos os xiros para darte conta de que a resposta final é incorrecta.

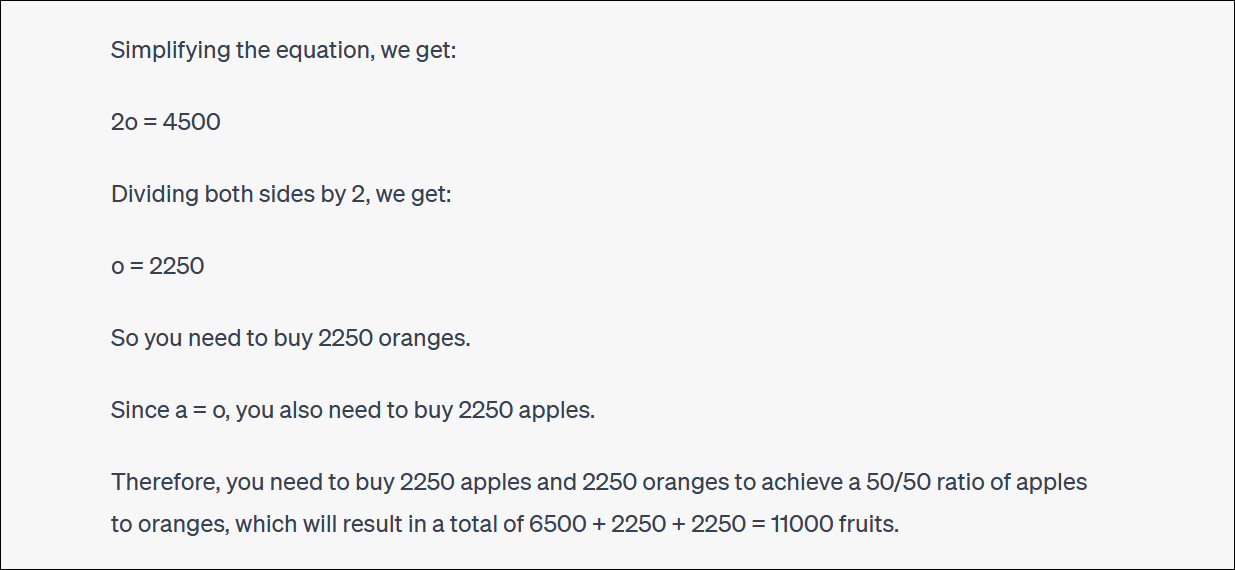

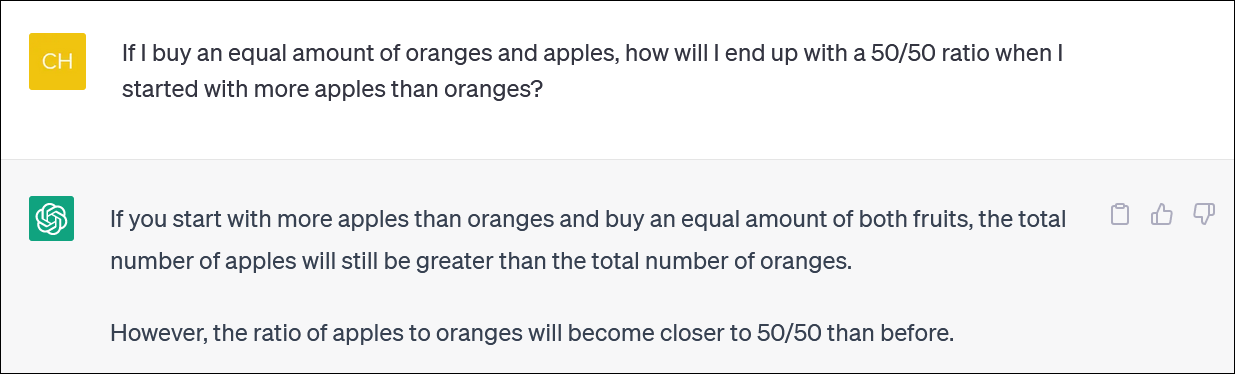

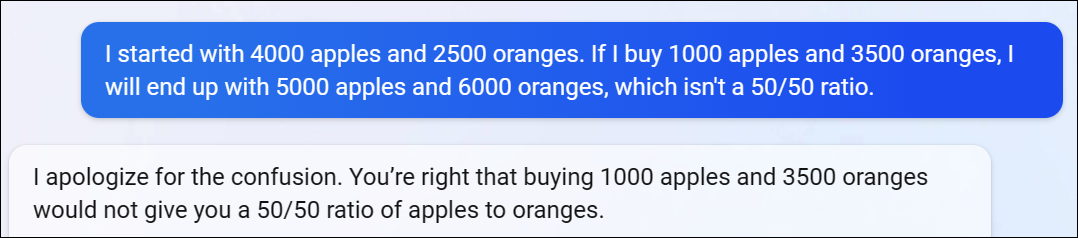

ChatGPT adoita buscar e discutir contigo tamén sobre as súas respostas. (De novo, este é un comportamento moi humano.)

Neste caso, argumentou ChatGPT, isto non che deu a resposta correcta, pero achegouche á porcentaxe que querías que antes. Iso é moi divertido.

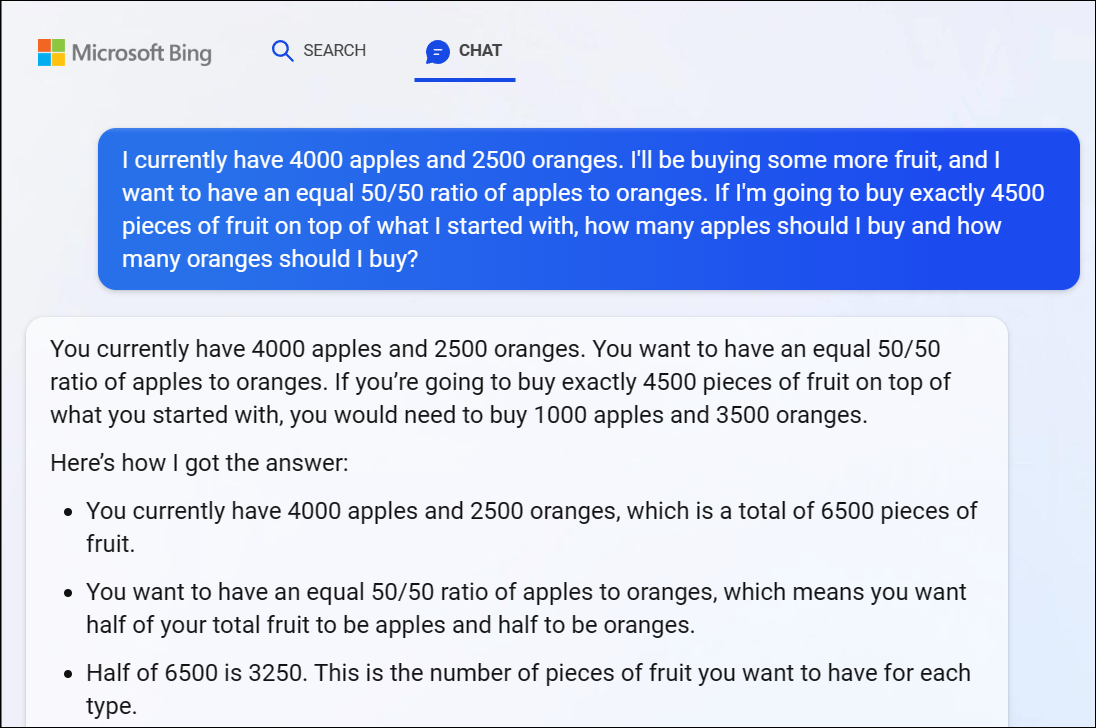

Para que conste, o Bing Chat de Microsoft baseado en GPT 4 tamén tivo problemas con este problema, dándonos unha resposta obviamente incorrecta. A lóxica GPT 4 tamén entra rapidamente aquí.

Recomendamos non tentar seguir todos os xiros da lóxica: a resposta é claramente incorrecta.

Cando sinalamos que a resposta de Bing era incorrecta, ela continuou discutindo connosco en círculos, dando resposta incorrecta tras resposta incorrecta.

ChatGPT tampouco pode facer as contas de forma fiable

Paga a pena notar que ChatGPT ás veces se omite e tamén menciona incorrectamente a conta principal. Vimos respostas lóxicas a problemas aritméticos incorrectos similares a 1 + 1 = 3 smack-dab no medio dunha resposta ben razoada.

Asegúrate de comprobar de novo e comprobar todo o que obteñas de ChatGPT e doutros chatbots de IA.