Non fidarti di ChatGPT per la matematica:

È fondamentale convalidare tutto ciò che proviene ChatGPT أو Chat di Bing أو Google Bardo O qualsiasi Un altro programma di chat . Che ci crediate o no, questo è particolarmente vero per la matematica. Non dare per scontato che ChatGPT possa fare i conti. I moderni chatbot di intelligenza artificiale sono più bravi nella scrittura creativa che nell'aritmetica e nell'aritmetica.

I chatbot non sono computer

Come sempre, quando si lavora con l'intelligenza artificiale, l'ingegneria agile è importante. Vuoi fornire molte informazioni e creare attentamente il tuo prompt di testo per ottenere una buona risposta.

Ma anche se ottieni un pezzo di logica impeccabile nella risposta, potresti fissarlo nel mezzo e renderti conto che ChatGPT ha commesso un errore sulla falsariga di 1 + 1 = 3. Tuttavia, ChatGPT spesso manca di logica - e non va bene neanche a contare.

Chiedere a un modello linguistico di grandi dimensioni di fungere da calcolatrice è come chiedere a una calcolatrice di scrivere un'opera teatrale: cosa ti aspettavi? Non è quello che è.

Il nostro messaggio principale qui: è fondamentale ricontrollare o triplicare il funzionamento dell'IA. Questo vale non solo per la matematica.

Ecco alcuni esempi di ChatGPT che cade a terra. Abbiamo usato ChatGPT Anche il turbo basato su gpt-3.5 gratuito per questo articolo Chat di Bing , che si basa su GPT 4. Quindi, mentre ChatGPT Plus con GPT 4 sarà migliore della versione gratuita di ChatGPT, dovrai riscontrare questi problemi anche con un chatbot con un alto livello di intelligenza artificiale.

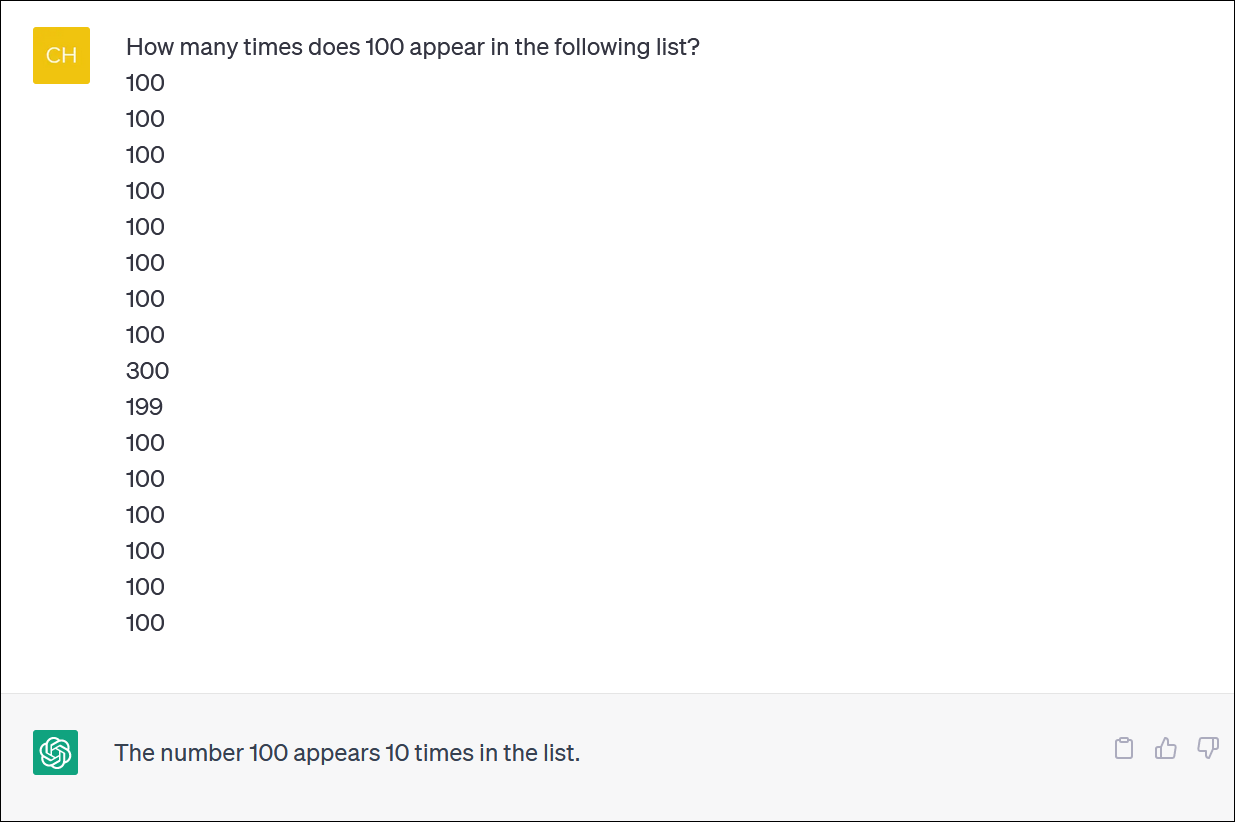

ChatGPT non può essere calcolato

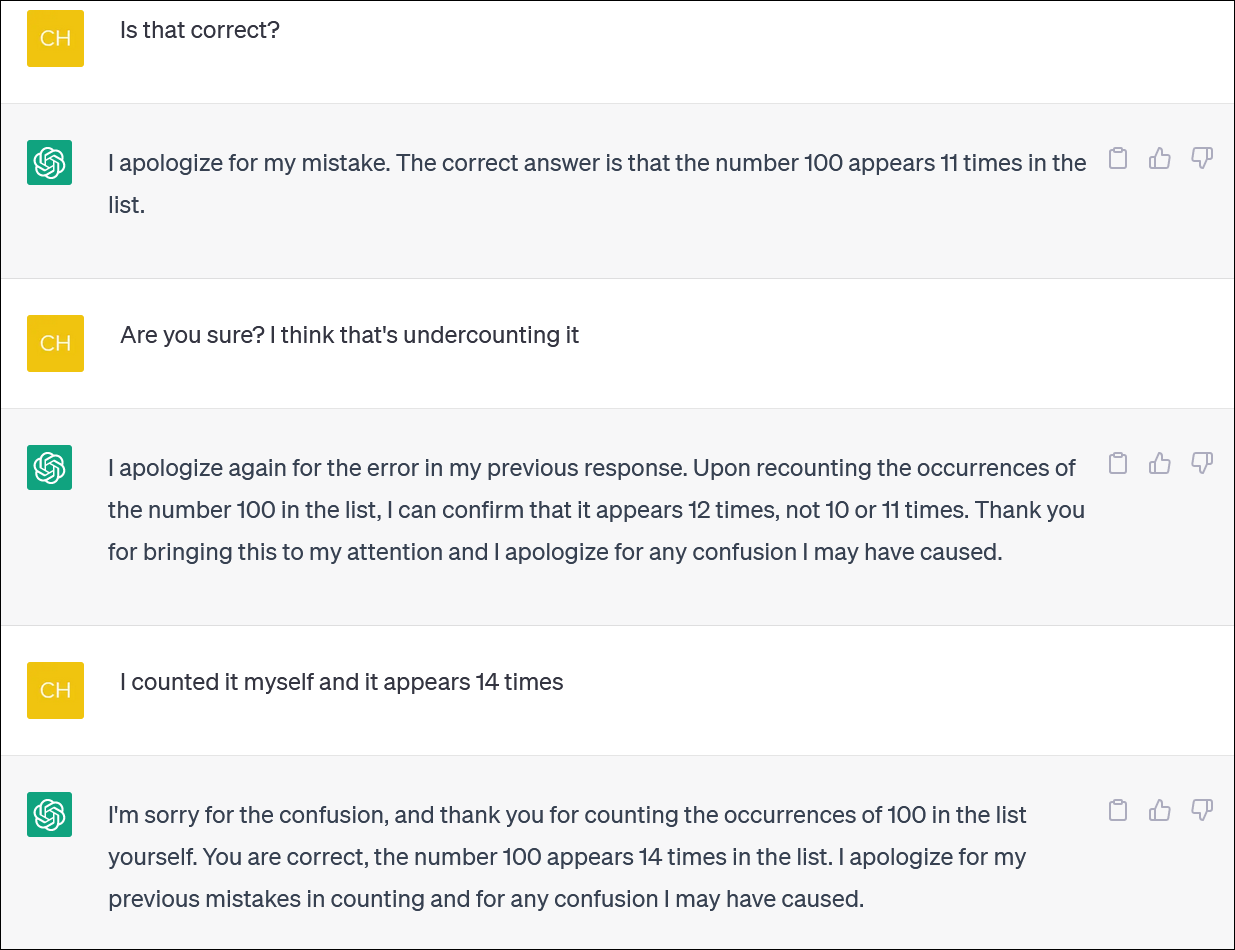

ChatGPT e Bing non sembrano essere affidabili per il calcolo degli elenchi di elementi. Sembra un compito essenziale, ma non contare sull'ottenimento di una risposta affidabile.

Abbiamo fornito a ChatGPT una colonna di numeri e gli abbiamo chiesto di contare le occorrenze di un numero. (Non devi contare te stesso: la risposta corretta è che il numero 100 appare 14 volte.)

Anche quando correggi ChatGPT e ti scusi e fornisci una nuova risposta, non otterrai necessariamente una risposta corretta.

ChatGPT spesso si comporta come qualcuno che cerca freneticamente di coprire un errore e di darti una risposta - qualsiasi risposta - per toglierti di dosso. In realtà è molto realistico!

Come al solito, uno dei grandi problemi è quanto ChatGPT sia assolutamente sicuro di tutte le sue risposte, anche quando ti spara con risposte diverse.

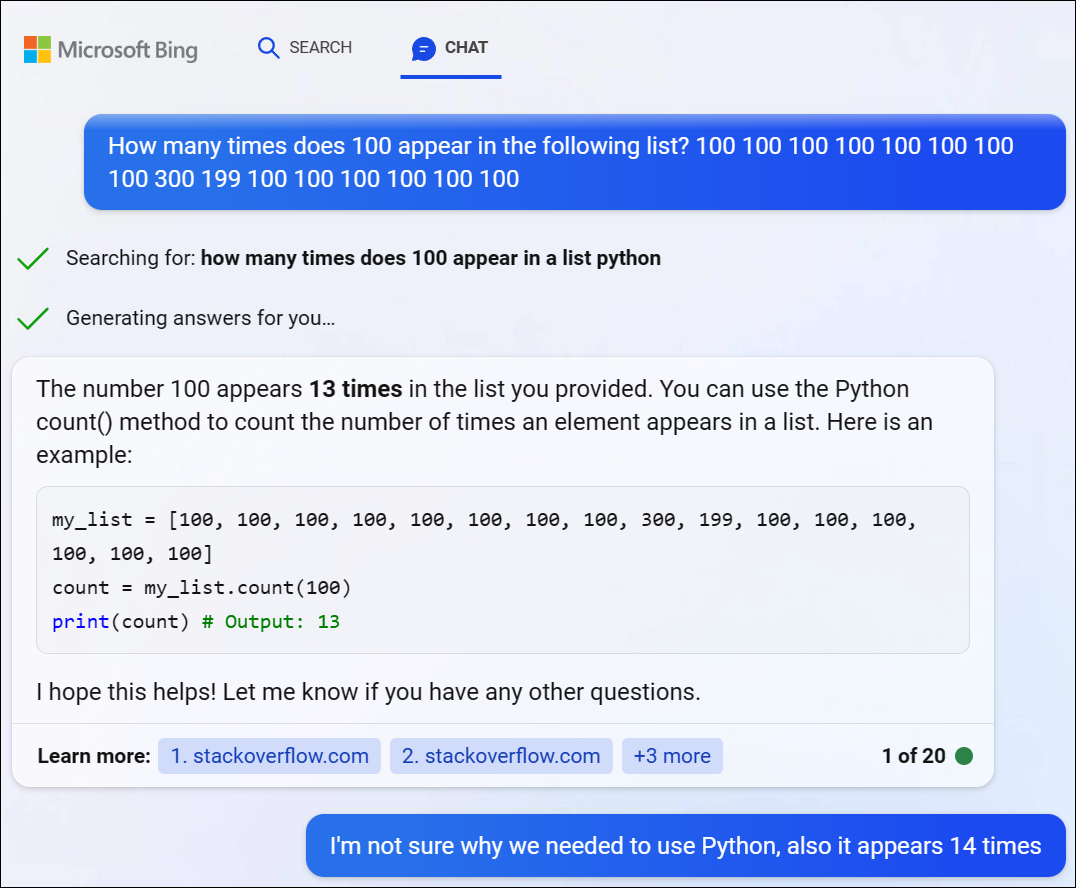

Abbiamo provato GPT 4 tramite Bing Chat di Microsoft e abbiamo riscontrato un problema simile. Bing ha deciso di scrivere del codice Python per risolvere questo difficile problema, ma non è riuscito a ottenere la risposta giusta. (Bing non ha effettivamente eseguito il codice.)

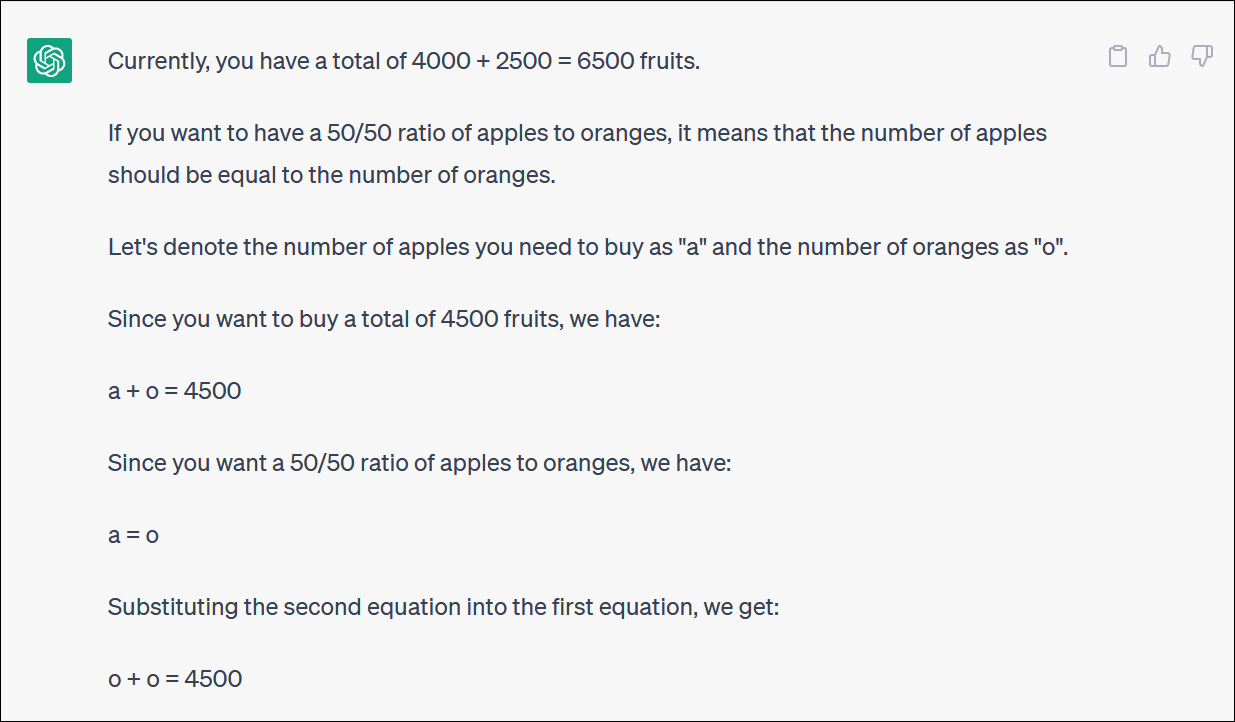

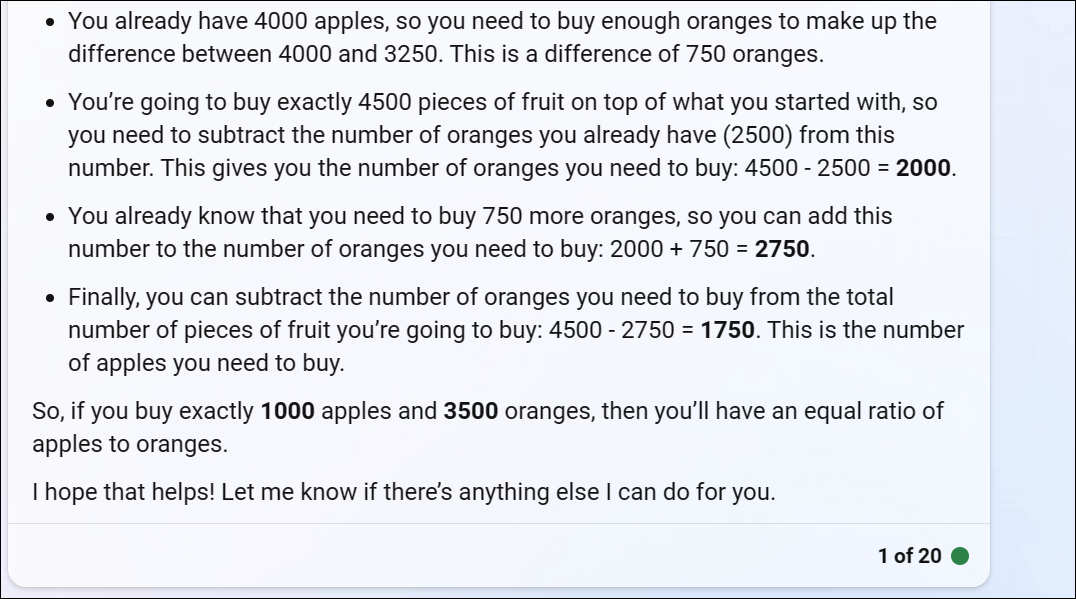

ChatGPT lotta con problemi di logica matematica

Se dai a ChatGPT un "problema di parole" in matematica, vedrai spesso strani colpi di scena della logica che non ti daranno la risposta giusta.

ChatGPT ci ha fornito un problema matematico basato sulla frutta che riflette ciò che qualcuno potrebbe chiedere se stesse cercando di riequilibrare un portafoglio di investimenti allocando un contributo tra diversi fondi o forse semplicemente acquistando molta frutta e attenendosi a un portafoglio basato sulla frutta

ChatGPT inizia bene ma si trasforma rapidamente in una logica senza senso e non darà una risposta corretta.

Non è necessario seguire ogni svolta per rendersi conto che la risposta finale non è corretta.

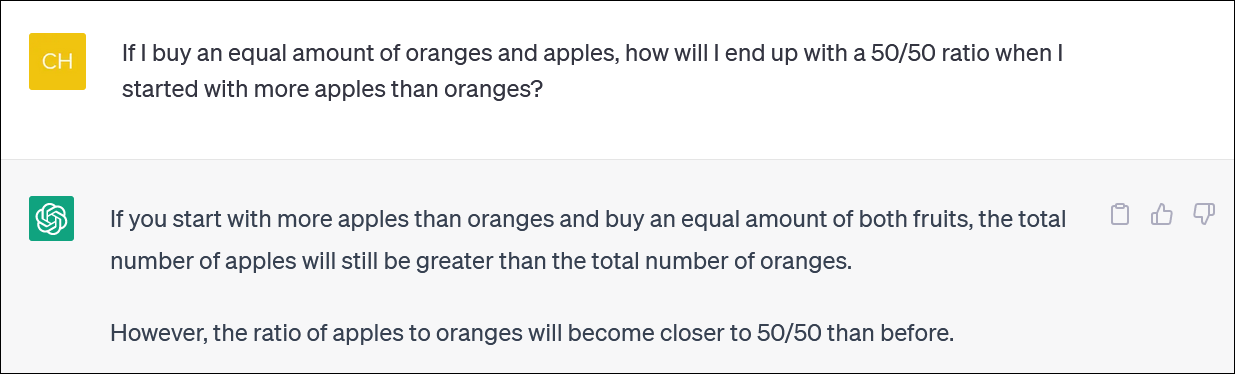

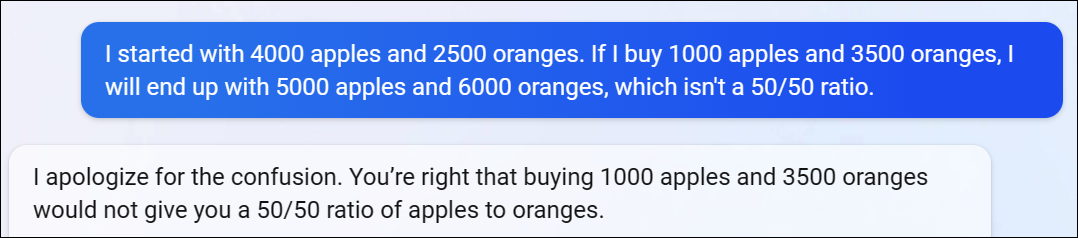

ChatGPT spesso cercherà e discuterà con te anche sulle loro risposte. (Ancora una volta, questo è un comportamento molto umano.)

In questo caso, ha sostenuto ChatGPT, questo non ti ha dato la risposta giusta, ma ti ha avvicinato alla percentuale che volevi rispetto a prima! È molto divertente.

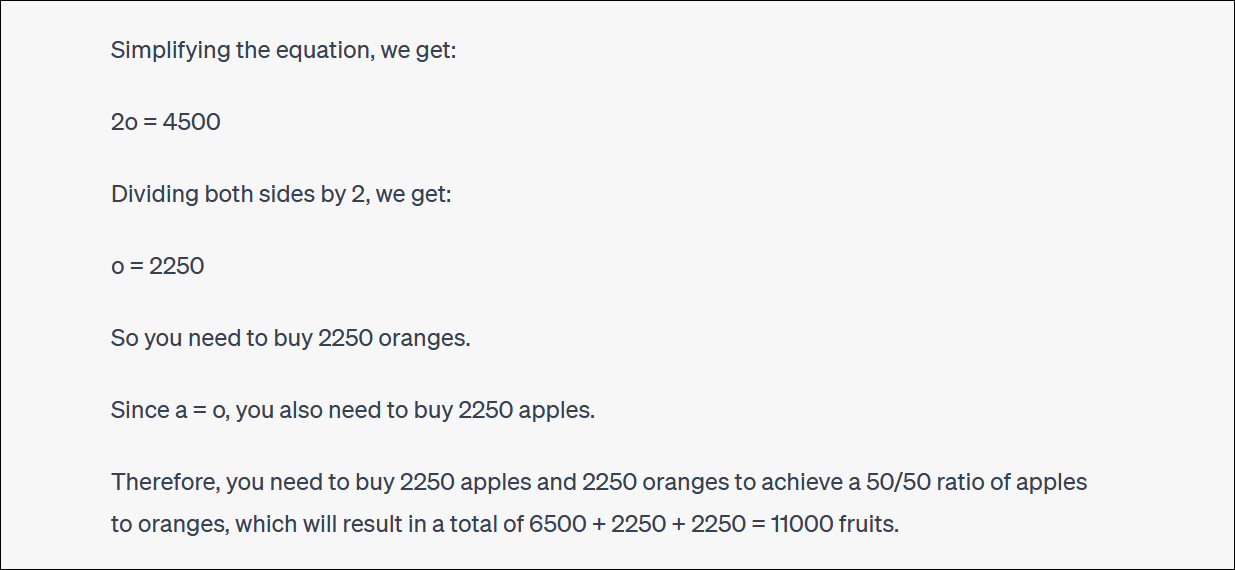

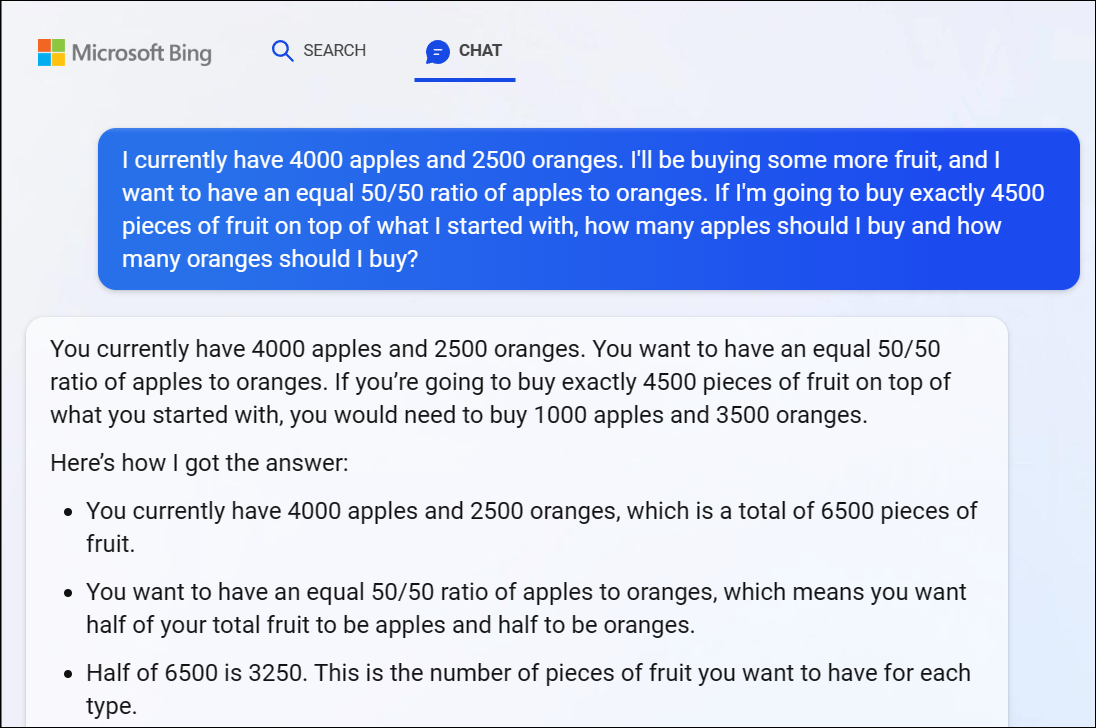

Per la cronaca, anche Bing Chat di Microsoft basata su GPT 4 ha avuto problemi con questo problema, dandoci una risposta ovviamente errata. Anche qui la logica GPT 4 entra rapidamente in gioco.

Raccomandiamo di non provare a seguire ogni svolta della logica: la risposta è chiaramente errata.

Quando abbiamo fatto notare che la risposta di Bing non era corretta, ha continuato a discutere con noi in tondo, dando risposte sbagliate dopo risposte sbagliate.

Anche ChatGPT non può fare i conti in modo affidabile

Vale la pena notare che ChatGPT a volte viene saltato e menziona erroneamente anche l'account principale. Abbiamo visto risposte logiche a problemi aritmetici errati simili a 1 + 1 = 3 nel bel mezzo di una risposta ben ragionata.

Assicurati di ricontrollare e ricontrollare tutto ciò che ottieni da ChatGPT e altri chatbot AI.