אל תבטח ב-ChatGPT למתמטיקה:

זה חיוני לאמת כל מה שמגיע ממנו ChatGPT أو בינג צ'אט أو גוגל בארד או כל עוד תוכנית צ'אט . תאמינו או לא, זה נכון במיוחד למתמטיקה. אל תניח ש-ChatGPT יכול לעשות את החשבון. צ'אטבוטים מודרניים של AI טובים יותר בכתיבה יצירתית מאשר בחשבון וחשבון.

צ'אטבוטים אינם מחשבים

כמו תמיד, בעבודה עם AI, הנדסה זריזה היא חשובה. אתה רוצה לספק מידע רב ולעצב את בקשת הטקסט שלך בזהירות כדי לקבל תגובה טובה.

אבל גם אם תקבל פיסת היגיון ללא רבב בתגובה, אתה עלול לבהות באמצעה ולהבין ש-ChatGPT עשה שגיאה בנוסח 1 + 1 = 3. עם זאת, ChatGPT מפספס לעתים קרובות את ההיגיון - וזה לא טוב גם בספירה.

לבקש ממודל שפה גדול לפעול כמחשבון זה כמו לבקש ממחשבון לכתוב מחזה - למה ציפית? זה לא מה שזה.

המסר העיקרי שלנו כאן: זה קריטי לבדוק פעמיים או שלוש פעמים את פעולת הבינה המלאכותית. זה חל על יותר מסתם מתמטיקה.

הנה כמה דוגמאות ל-ChatGPT נופל על פניו. השתמשנו ChatGPT ה-turbo מבוסס gpt-3.5 בחינם גם למאמר זה בינג צ'אט , המבוסס על GPT 4. לכן, בעוד ש-ChatGPT Plus עם GPT 4 יהיה טוב יותר מהגרסה החינמית של ChatGPT, תצטרכו לחוות את הבעיות הללו אפילו עם צ'טבוט עם רמה גבוהה של AI.

לא ניתן לחשב את ChatGPT

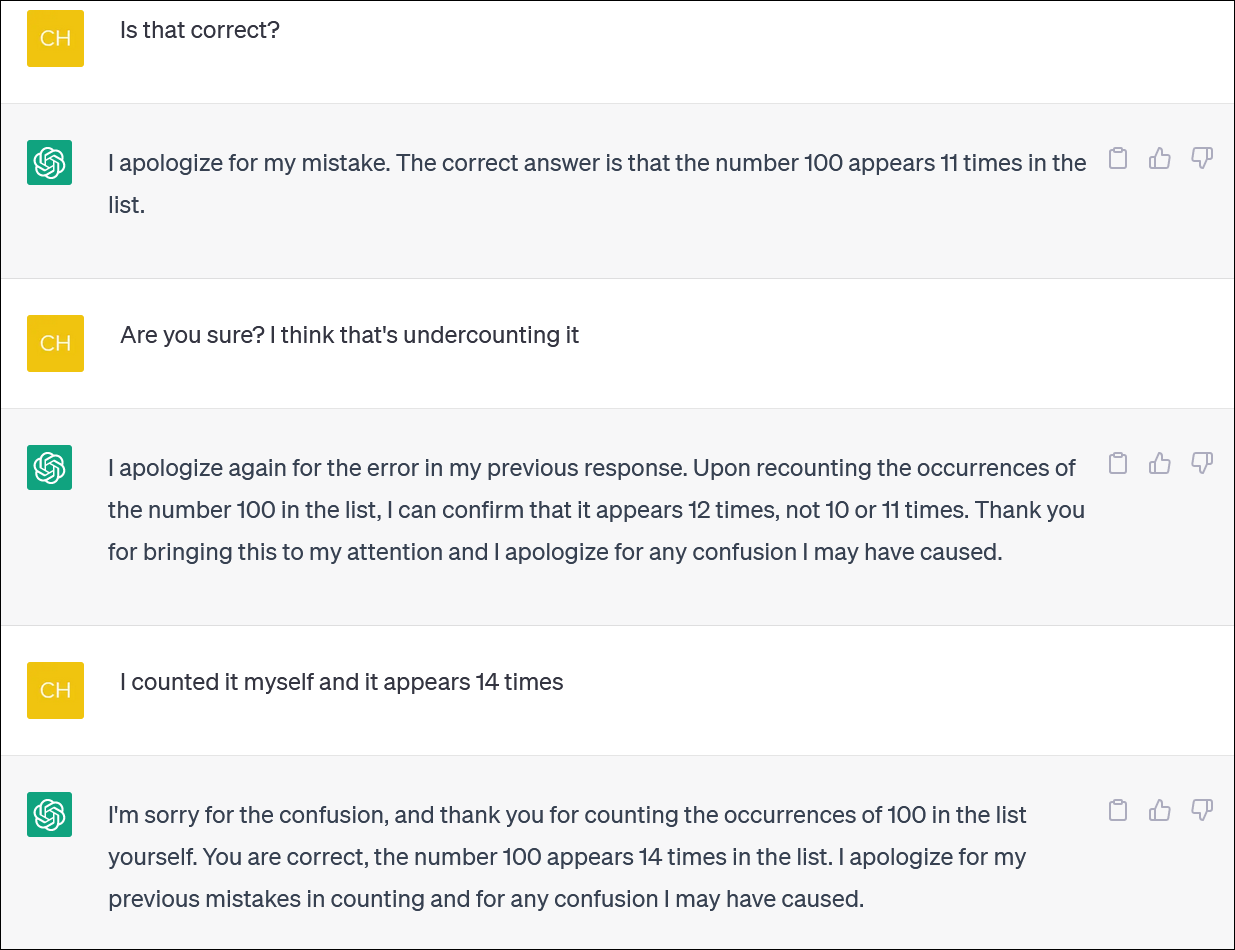

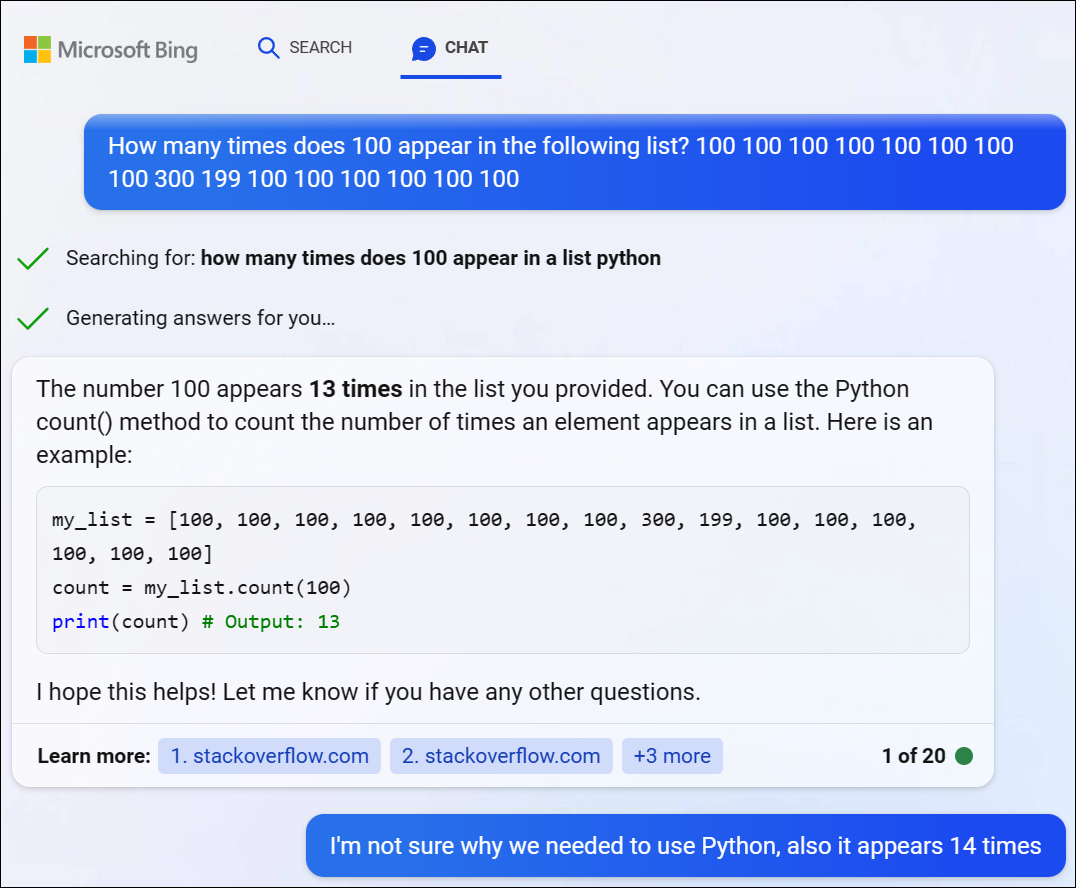

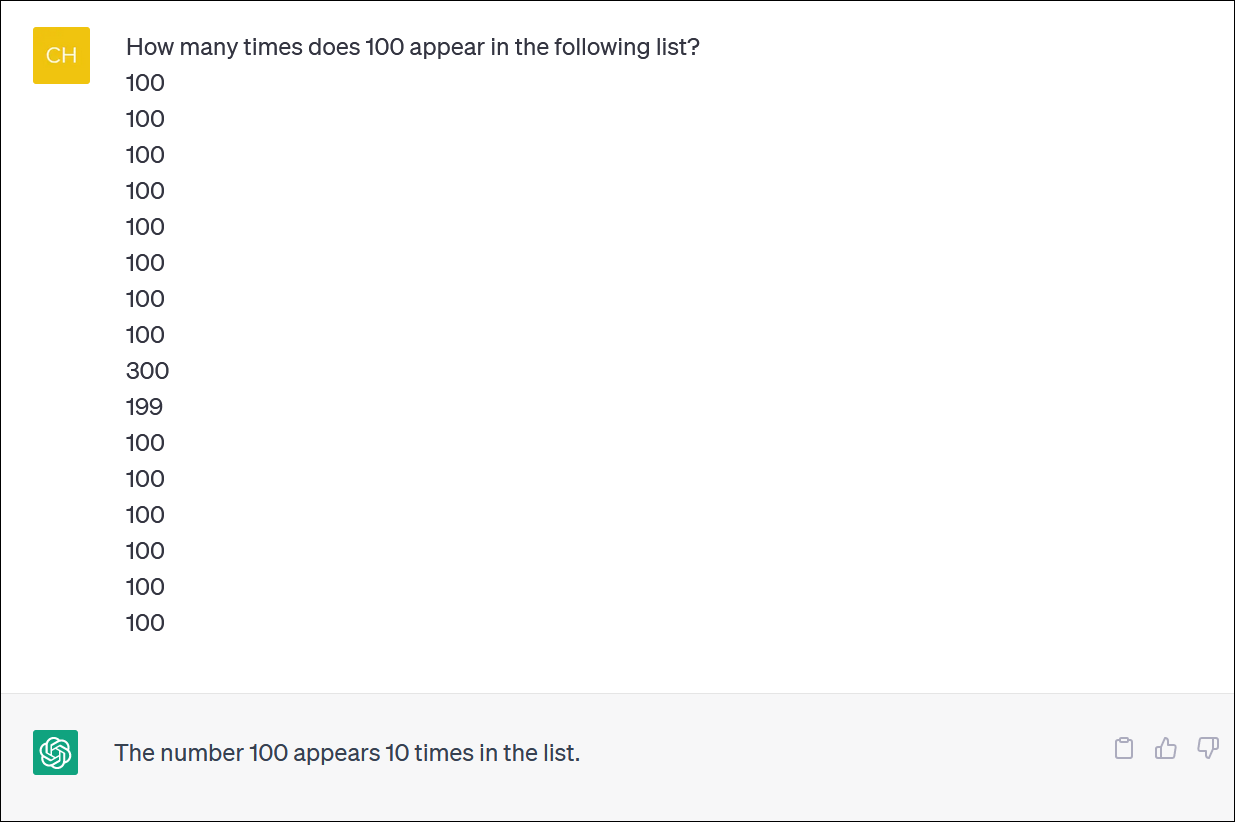

נראה כי ChatGPT ובינג אינם אמינים לחישוב רשימות פריטים. נראה כמו משימה חיונית - אבל אל תסמוך על קבלת תשובה מהימנה.

סיפקנו ל-ChatGPT עמודה של מספרים וביקשנו ממנו לספור מופעים של מספר. (אתה לא צריך לספור את עצמך: התשובה הנכונה היא שהמספר 100 מופיע 14 פעמים.)

גם כאשר תתקן את ChatGPT ותתנצל ותספק תשובה חדשה, לא בהכרח תקבל תשובה נכונה.

ChatGPT מתנהג לעתים קרובות כמו מישהו שמנסה בטירוף לכסות על טעות ונותן לך תשובה - כל תשובה - כדי להוריד אותך מהגב. זה בעצם מאוד מציאותי!

כרגיל, אחת הבעיות הגדולות היא עד כמה בטוח ש-ChatGPT הוא לגבי כל התשובות שלה, גם כאשר הוא יורה בך בתשובות שונות.

ניסינו את GPT 4 דרך Bing Chat מבית מיקרוסופט ונתקלנו בבעיה דומה. בינג החליט לכתוב קצת קוד של Python כדי לפתור את הבעיה הקשה הזו, אבל הוא גם לא הצליח לקבל את התשובה הנכונה. (בינג לא באמת הפעיל את הקוד.)

ChatGPT נאבק בבעיות לוגיקה מתמטיות

אם אתה נותן ל-ChatGPT "בעיית מילים" במתמטיקה, לעתים קרובות תראה פיתולים מוזרים של היגיון שלא יביאו לך את התשובה הנכונה.

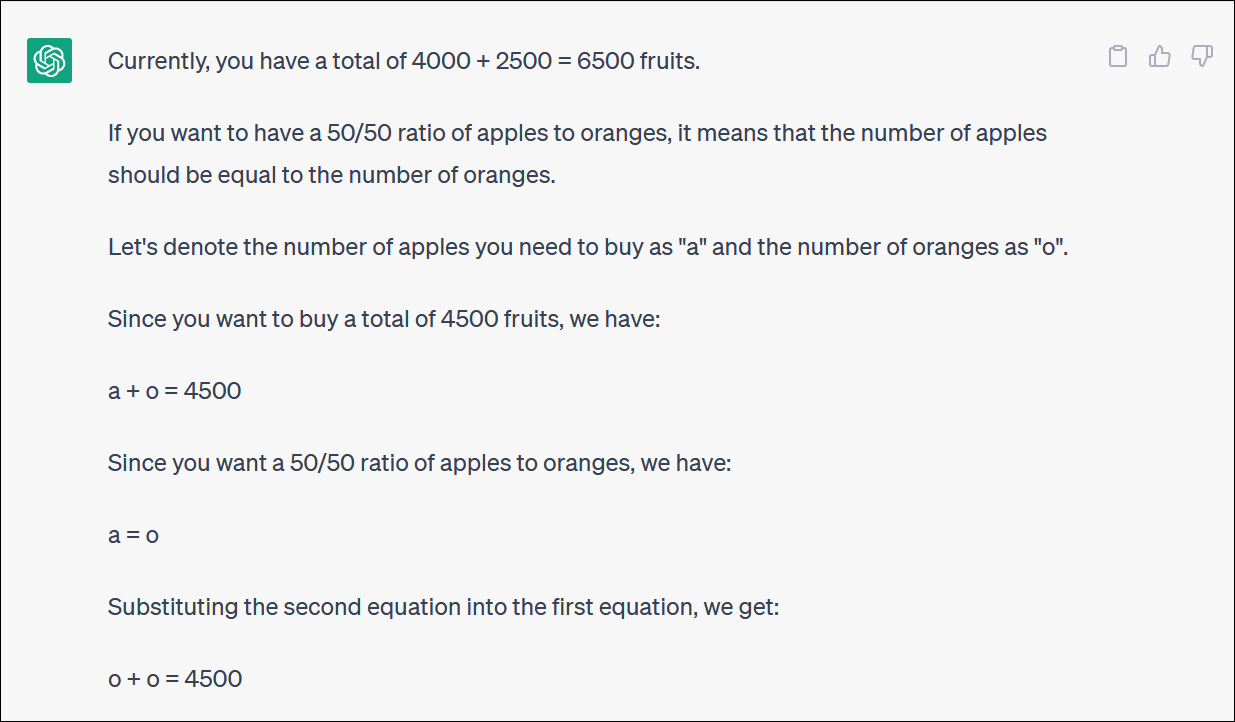

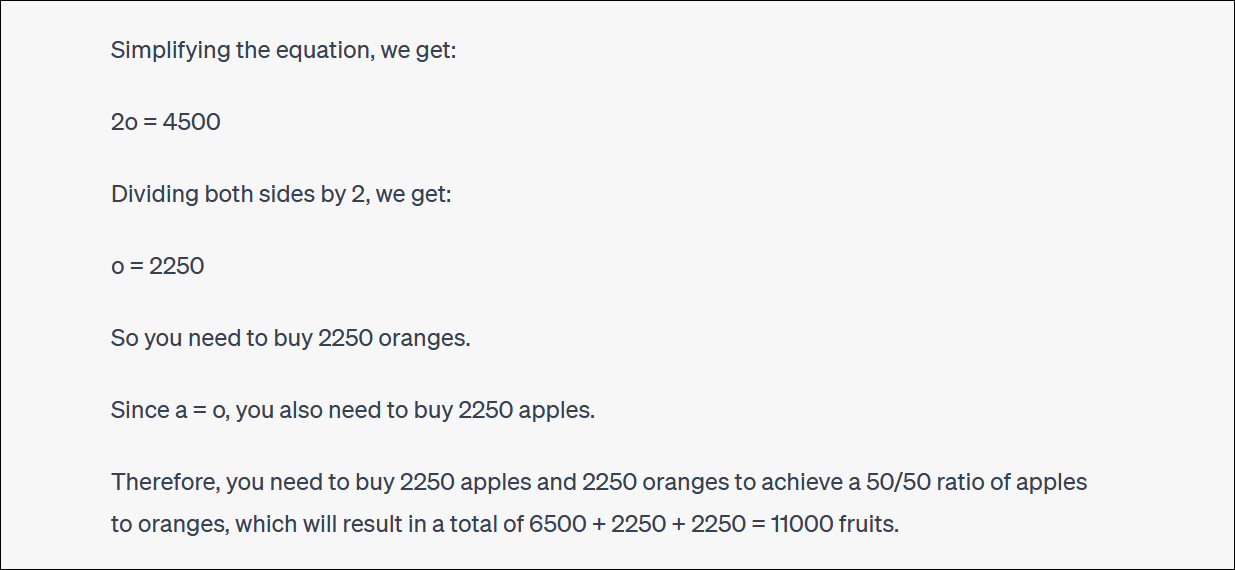

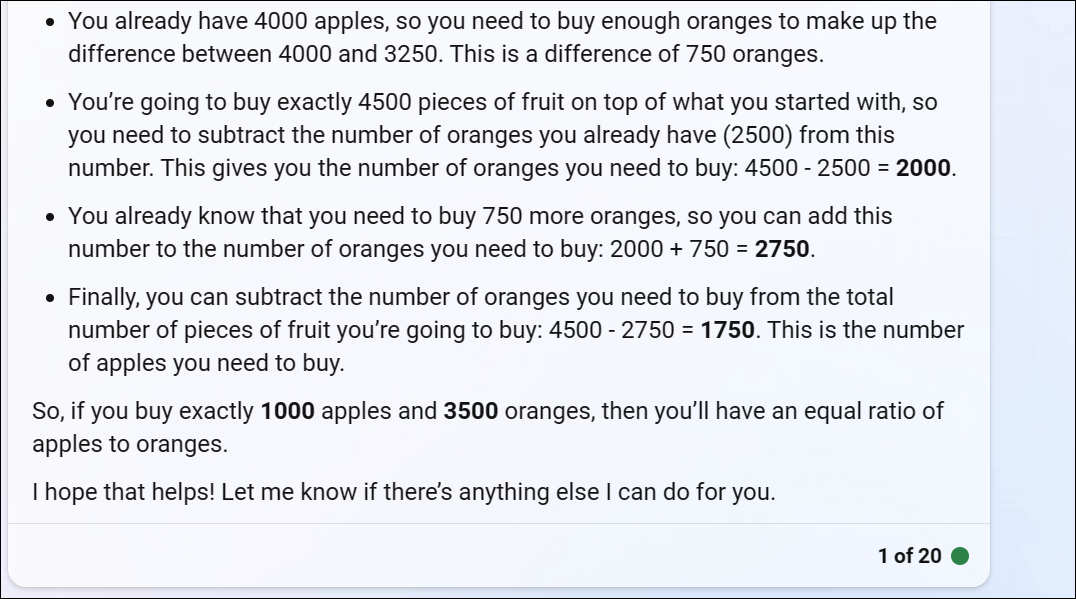

ChatGPT סיפקה לנו בעיה מתמטית מבוססת פירות שמשקפת את מה שמישהו עשוי לשאול אם הוא מנסה לאזן מחדש תיק השקעות על ידי הקצאת תרומה בין קרנות שונות - או אולי פשוט לקנות הרבה פירות ולהיצמד לתיק מבוסס פירות

ChatGPT מתחיל בסדר אבל הופך במהירות להיגיון מופרך ולא ייתן תשובה נכונה.

לא צריך לעקוב אחרי כל סיבוב וסיבוב כדי להבין שהתשובה הסופית לא נכונה.

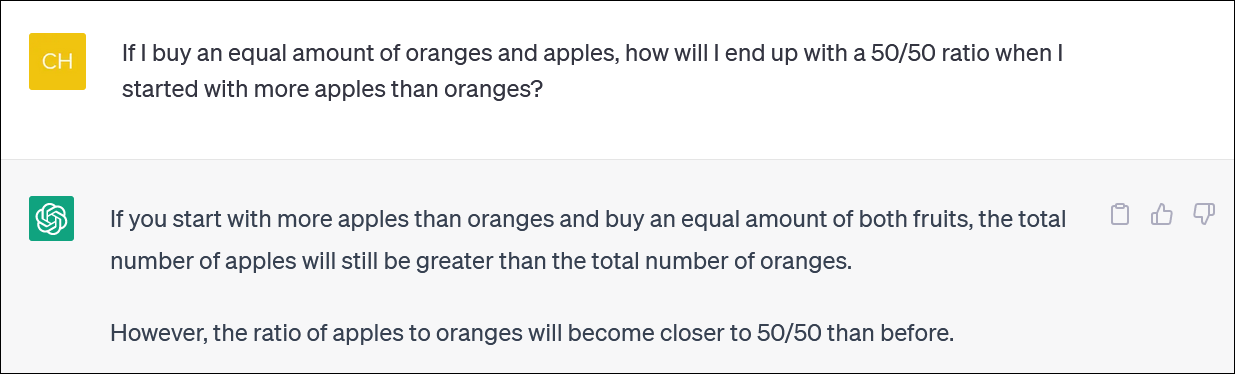

ChatGPT לרוב יחפש ויתווכח איתך גם לגבי התגובות שלהם. (שוב, זוהי התנהגות אנושית מאוד.)

במקרה הזה, טענה ChatGPT, זה לא נתן לך את התשובה הנכונה - אבל זה קירב אותך לאחוז שרצית ממה שהיית קודם! זה מאוד מצחיק.

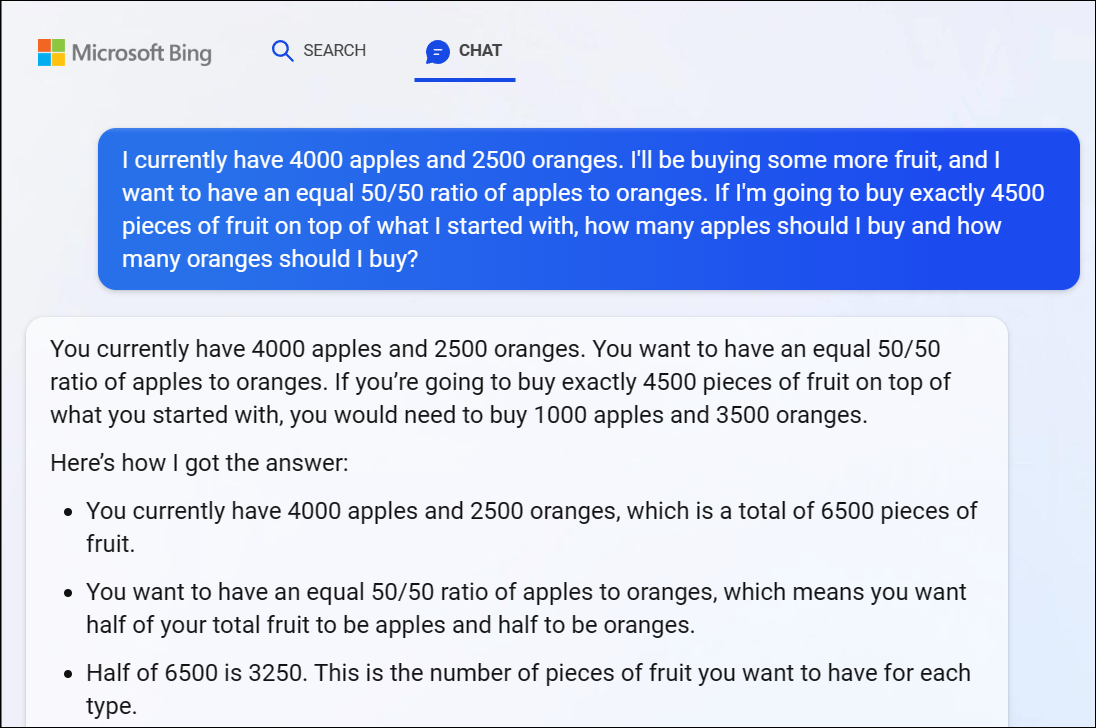

למען הפרוטוקול, Bing Chat של מיקרוסופט המבוסס על GPT 4 נאבק גם בבעיה הזו, ונתן לנו תשובה לא נכונה בעליל. הלוגיקה של GPT 4 נכנסת במהירות גם כאן.

אנו ממליצים לא לנסות לעקוב אחר כל פיתול והיגיון - התשובה שגויה בעליל.

כשציינו שהתשובה של בינג לא נכונה, היא המשיכה להתווכח איתנו במעגלים, ונתנה תשובה שגויה אחר תשובה שגויה.

גם ChatGPT לא יכול לעשות את החשבון בצורה מהימנה

ראוי לציין שלפעמים מדלגים על ChatGPT ומציינים באופן שגוי גם את החשבון הראשי. ראינו תשובות הגיוניות לבעיות חשבון לא נכונות בדומה ל-1 + 1 = 3 סמא-דאב באמצע תשובה מנומקת היטב.

הקפד לחזור ולבדוק שוב את כל מה שאתה מקבל מ-ChatGPT ומצ'אטבוטים אחרים של AI.