Не верувајте во ChatGPT за математика:

Клучно е да се потврди се што доаѓа од Разговор GPT أو Бинг разговор أو Гугл кул или било кој Друга програма за разговор . Верувале или не, ова особено важи за математиката. Не претпоставувајте дека ChatGPT може да направи математика. Современите чат-ботови со вештачка интелигенција се подобри во креативното пишување отколку во аритметиката и аритметиката.

Четботите не се компјутери

Како и секогаш, кога работите со вештачка интелигенција, важно е агилното инженерство. Сакате да дадете многу информации и внимателно да го изработите текстот за да добиете добар одговор.

Но, дури и ако добиете беспрекорна логика во одговорот, може да се загледате во средината и да сфатите дека ChatGPT направи грешка по линијата 1 + 1 = 3. Сепак, ChatGPT често ја пропушта логиката - и тоа не е добро или при броење.

Да барате голем јазичен модел да дејствува како калкулатор е исто како да барате калкулатор да напише драма - што очекувавте? Тоа не е тоа што е.

Нашата главна порака овде: од клучно значење е двојно или тројно да се провери функционирањето на вештачката интелигенција. Ова се однесува на повеќе од само математика.

Еве неколку примери на ChatGPT кој паѓа со лице. Ние употребивме Разговор GPT Бесплатното турбо базирано на gpt-3.5 и за овој напис Бинг разговор , кој се базира на GPT 4. Значи, иако ChatGPT Plus со GPT 4 ќе биде подобар од бесплатната верзија на ChatGPT, ќе мора да ги доживеете овие проблеми дури и со chatbot со високо ниво на вештачка интелигенција.

ChatGPT не може да се пресмета

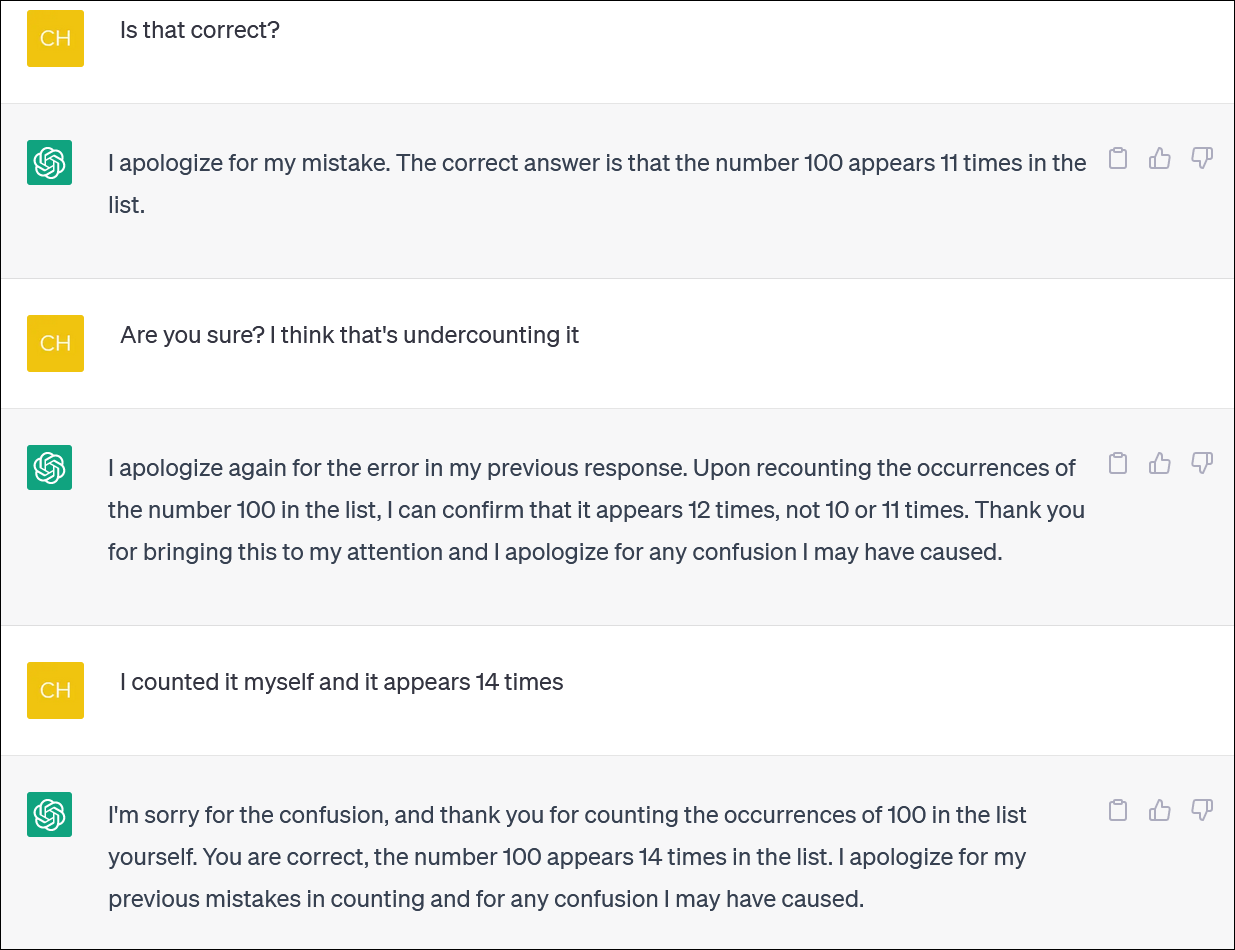

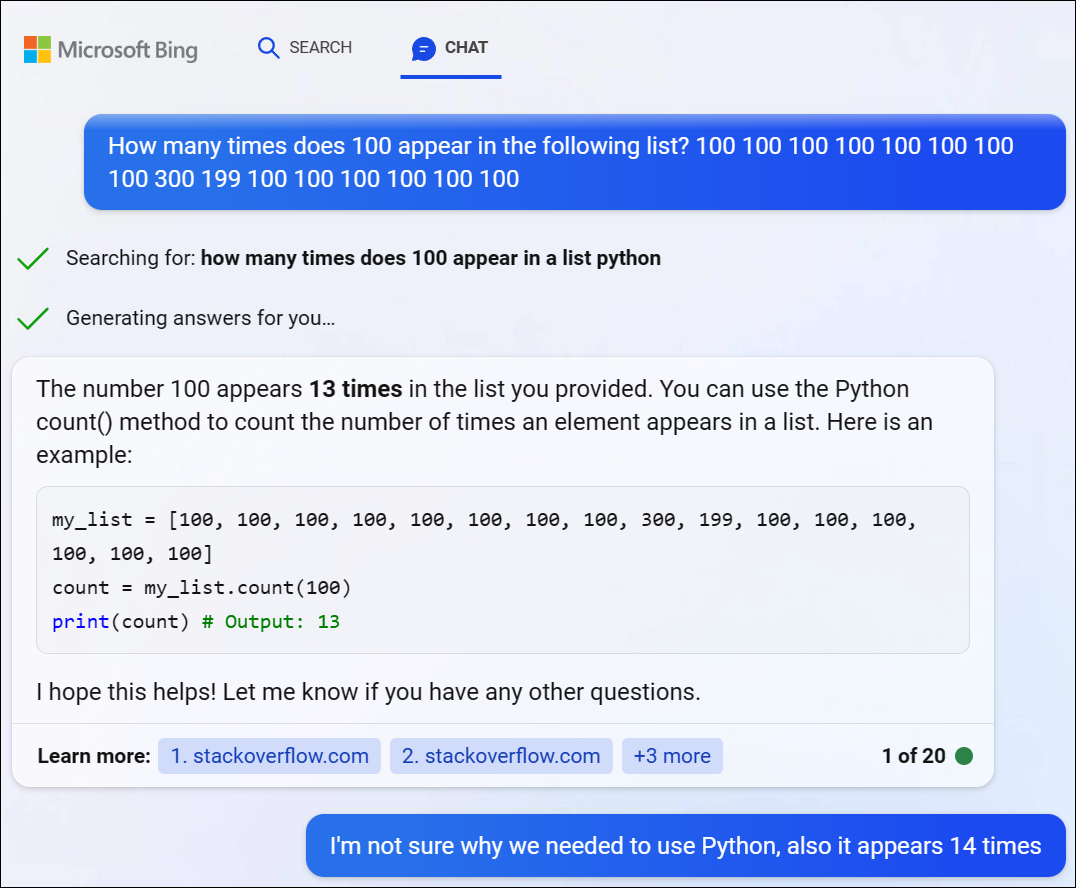

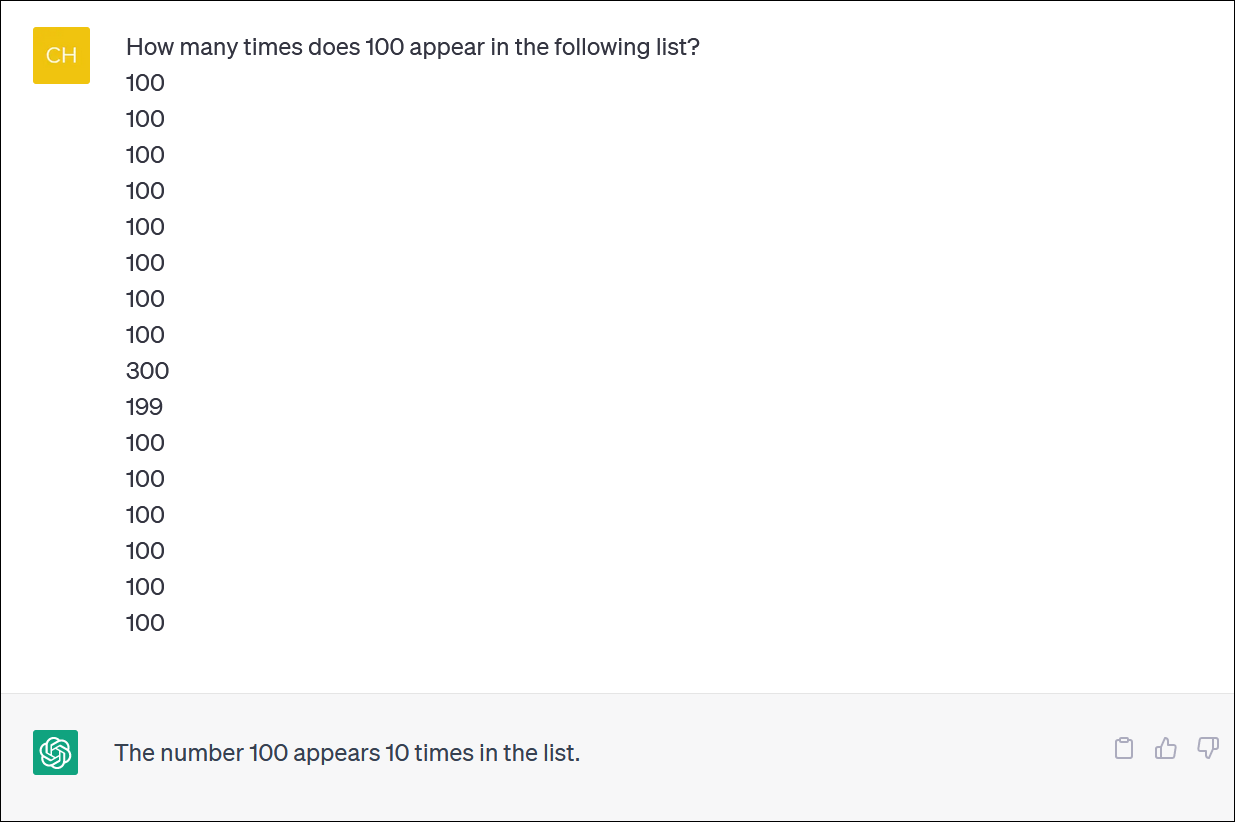

ChatGPT и Bing се чини дека не се сигурни за пресметување на списоци со ставки. Изгледа како суштинска задача - но не сметајте на добивање доверлив одговор.

На ChatGPT му дадовме колона со броеви и побаравме да брои појава на број. (Не мора да се броите: точниот одговор е дека бројот 100 се појавува 14 пати.)

Дури и кога ќе го поправите ChatGPT и ќе се извините и ќе дадете нов одговор, нема да мора да добиете точен одговор.

ChatGPT често се однесува како некој што избезумено се обидува да прикрие грешка и да ви даде одговор - каков било одговор - за да ве тргне од грбот. Тоа е всушност многу реалистично!

Како и обично, еден од големите проблеми е колку ChatGPT е апсолутно сигурен за сите негови одговори, дури и кога ќе ве застрела со различни одговори.

Пробавме GPT 4 преку Bing Chat од Microsoft и наидовме на сличен проблем. Бинг одлучи да напише малку Python код за да го реши овој тежок проблем, но исто така не успеа да го добие вистинскиот одговор. (Бинг всушност не го извршил кодот.)

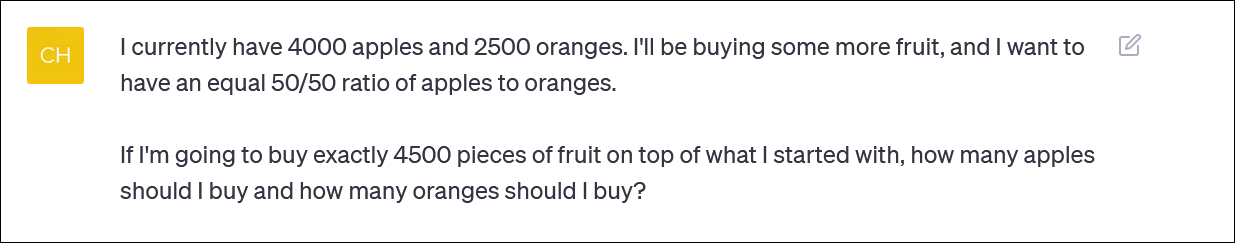

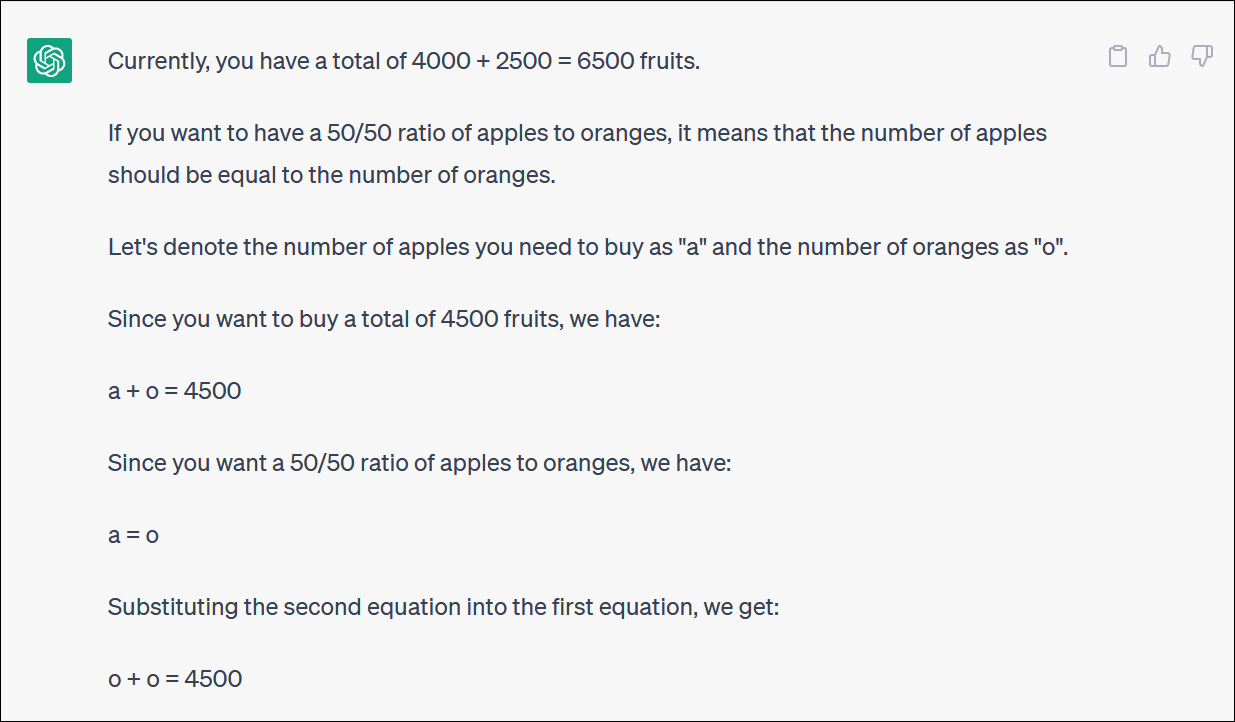

ChatGPT се бори со математички логички проблеми

Ако му дадете на ChatGPT „проблема со зборови“ во математиката, честопати ќе видите чудни пресврти на логиката што нема да ви го дадат вистинскиот одговор.

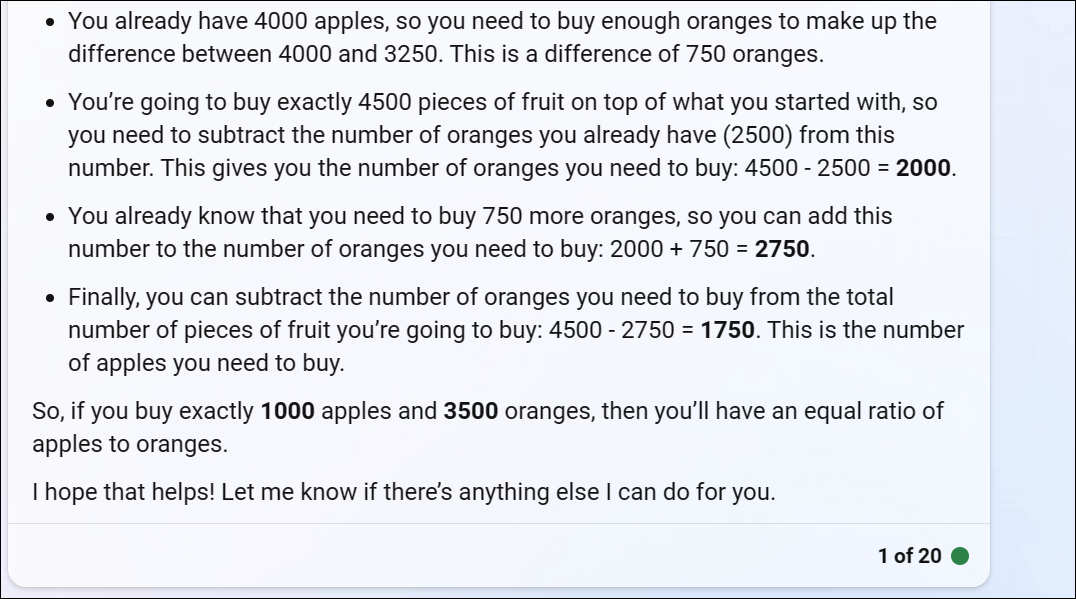

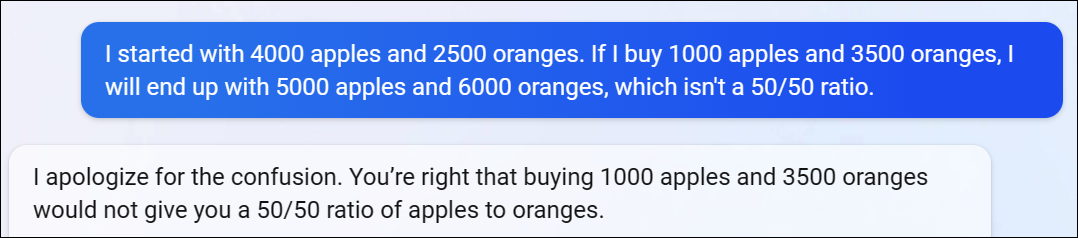

ChatGPT ни обезбеди математички проблем заснован на овошје што го одразува она што некој би можел да го праша ако се обидува да го ребалансира инвестициското портфолио со распределба на придонес помеѓу различни фондови - или можеби само купување многу овошје и држење до портфолио засновано на овошје

ChatGPT започнува добро, но брзо се претвора во бесмислена логика и нема да даде точен одговор.

Не мора да го следите секој чекор и вртење за да сфатите дека конечниот одговор е неточен.

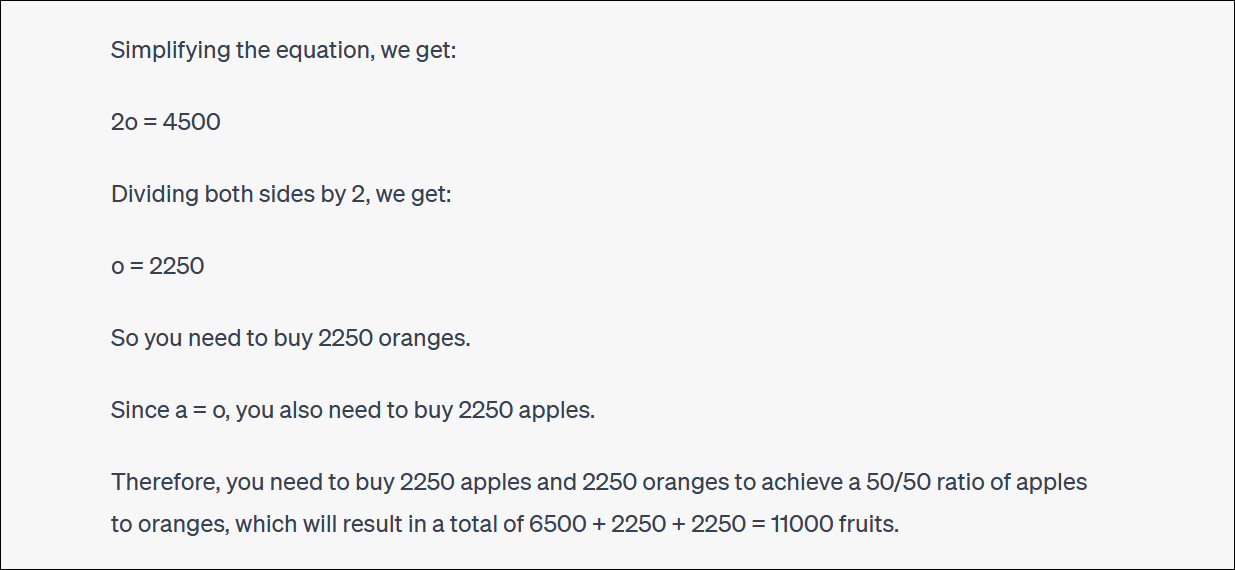

ChatGPT често ќе пребарува и ќе се расправа со вас и за нивните одговори. (Повторно, ова е многу човечко однесување.)

Во овој случај, тврдеше ChatGPT, ова не ви го даде вистинскиот одговор - но ве приближи до процентот што го посакувавте отколку што бевте порано! Тоа е многу смешно.

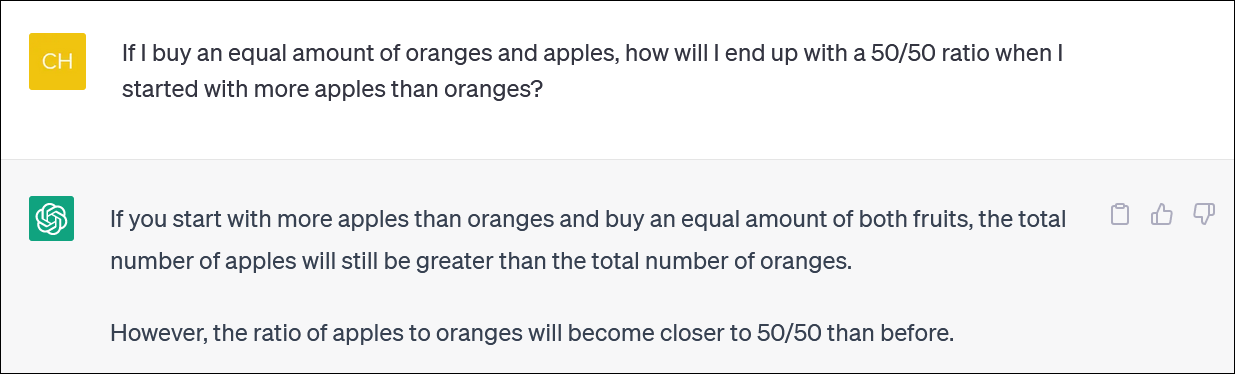

За евиденција, Bing Chat на Microsoft базиран на GPT 4 се бореше и со овој проблем, давајќи ни очигледно неточен одговор. Логиката на GPT 4 брзо влегува и овде.

Препорачуваме да не се обидувате да го следите секој пресврт и пресврт на логиката - одговорот е очигледно неточен.

Кога укажавме дека одговорот на Бинг е неточен, таа продолжи да се расправа со нас во кругови, давајќи погрешен одговор по погрешен одговор.

ChatGPT не може со сигурност да ја направи математиката

Вреди да се напомене дека ChatGPT понекогаш се прескокнува и погрешно ја споменува и примарната сметка. Видовме логични одговори на неточни аритметички проблеми слични на 1 + 1 = 3 smack-dab во средината на добро образложен одговор.

Погрижете се да проверите повторно и да проверите двапати сè што добивате од ChatGPT и другите чат-ботови со вештачка интелигенција.