သင်္ချာအတွက် ChatGPT ကို မယုံကြည်ပါနှင့်။

လာသမျှအရာအားလုံးကို မှန်ကန်ကြောင်း အတည်ပြုရန် အရေးကြီးသည်။ GPT ချတ် أو bingchat أو Google က အေးတယ်။ သို့မဟုတ် တစ်ခုခု နောက်ထပ်စကားပြောအစီအစဉ် . ယုံသည်ဖြစ်စေ၊ ChatGPT သည် သင်္ချာလုပ်နိုင်သည်ဟု မထင်ပါနှင့်။ ခေတ်မီ AI chatbot များသည် ဂဏန်းသင်္ချာနှင့် ဂဏန်းသင်္ချာတို့ထက် တီထွင်ဖန်တီးမှုဆိုင်ရာ အရေးအသားတွင် ပိုမိုကောင်းမွန်ပါသည်။

Chatbot များသည် ကွန်ပျူတာများ မဟုတ်ပါ။

အမြဲလိုလို AI နဲ့ အလုပ်လုပ်တဲ့အခါ သွက်လက်တဲ့ အင်ဂျင်နီယာက အရေးကြီးတယ်။ သတင်းအချက်အလက်များစွာကို ပေးဆောင်ပြီး ကောင်းမွန်သောတုံ့ပြန်မှုရရှိရန် သင့်စာသားကို ဂရုတစိုက်ပြုလုပ်လိုပါသည်။

သို့သော် သင်သည် တုံ့ပြန်မှုတွင် အပြစ်ကင်းစင်သော ယုတ္တိတစ်ခုရလျှင်ပင်၊ ၎င်းကို အလယ်တွင် စိုက်ကြည့်ကာ ChatGPT သည် 1 + 1 = 3 မျဉ်းကြောင်းတစ်လျှောက်တွင် အမှားအယွင်းတစ်ခု ပြုလုပ်ခဲ့သည်ကို သိရှိနိုင်သည်။ သို့သော်၊ ChatGPT သည် ယုတ္တိဗေဒကို မကြာခဏ လွဲချော်နေသော်လည်း ၎င်းမှာ မကောင်းပါ။ ရေတွက်ရာတွင်လည်းကောင်း။

ဂဏန်းပေါင်းစက်တစ်ခုအဖြစ် လုပ်ဆောင်ရန် ကြီးမားသောဘာသာစကားပုံစံတစ်ခုကို တောင်းဆိုခြင်းသည် ဂဏန်းပေါင်းစက်တစ်ခုအား ဂိမ်းတစ်ခုရေးရန် တောင်းဆိုခြင်းကဲ့သို့ဖြစ်သည် - သင်ဘာကိုမျှော်လင့်ထားသနည်း။ အဲဒါ မဟုတ်ဘူး။

ဤနေရာတွင် ကျွန်ုပ်တို့၏ အဓိကသတင်းစကား- AI ၏ လုပ်ဆောင်ချက်များကို နှစ်ချက်စစ်ဆေးရန် သို့မဟုတ် သုံးဆစစ်ဆေးရန် အရေးကြီးပါသည်။ ဒါက သင်္ချာသက်သက်ထက် ပိုသက်ဆိုင်ပါတယ်။

ဤသည်မှာ ChatGPT ၏မျက်နှာပေါ်တွင် ပြားပြားဝပ်နေသော ဥပမာအချို့ဖြစ်သည်။ သုံးတယ်။ GPT ချတ် ဤဆောင်းပါးအတွက် gpt-3.5-based-turbo အခမဲ့ဖြစ်သည်။ bingchat GPT 4 ကိုအခြေခံထားသည့်၊ ထို့ကြောင့်၊ GPT 4 နှင့် ChatGPT Plus သည် ChatGPT ၏အခမဲ့ဗားရှင်းထက် ပိုကောင်းသော်လည်း AI အဆင့်မြင့်မားသော chatbot ဖြင့်ပင် ဤပြဿနာများကို သင်ကြုံတွေ့ရမည်ဖြစ်ပါသည်။

ChatGPT တွက်ချက်၍မရပါ။

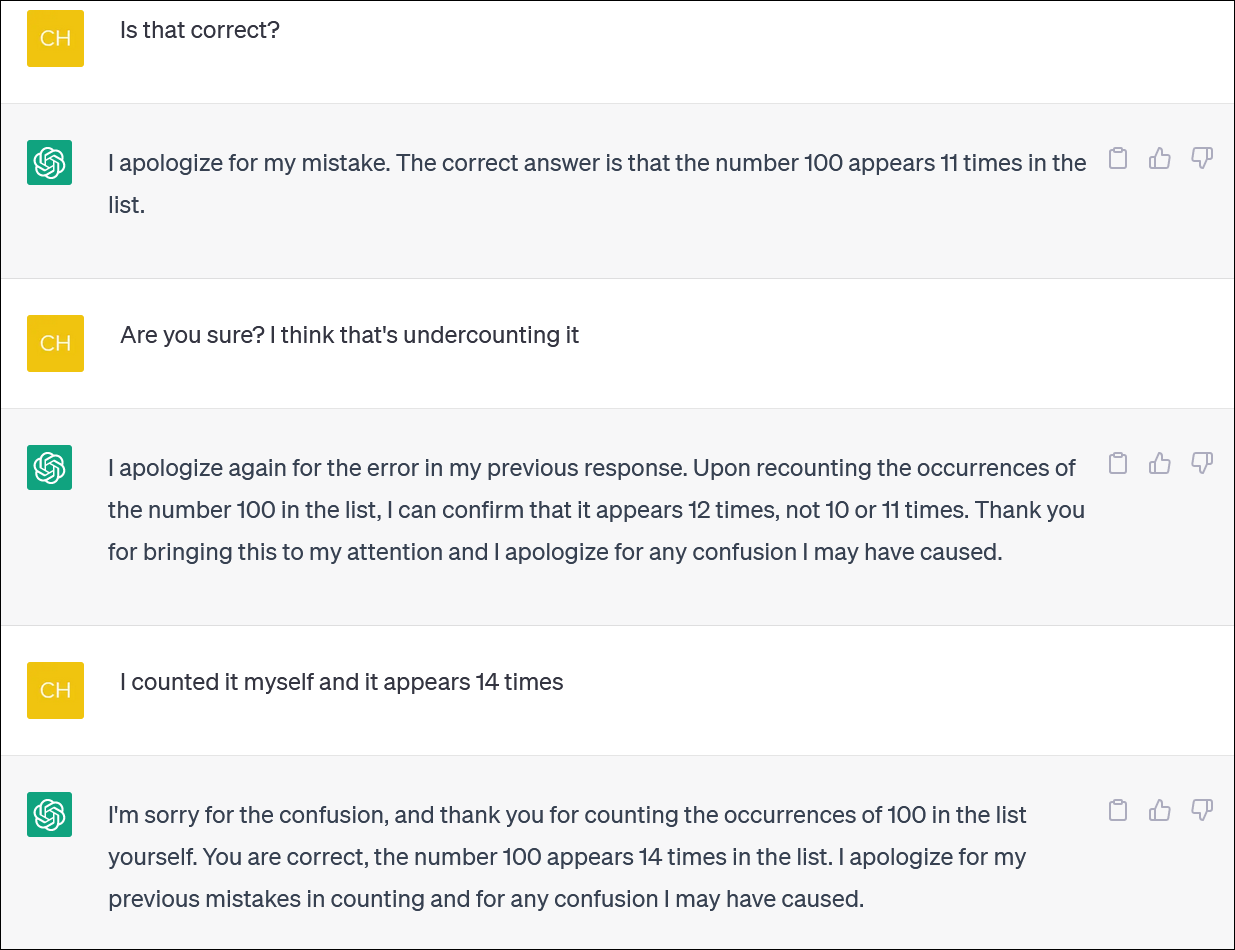

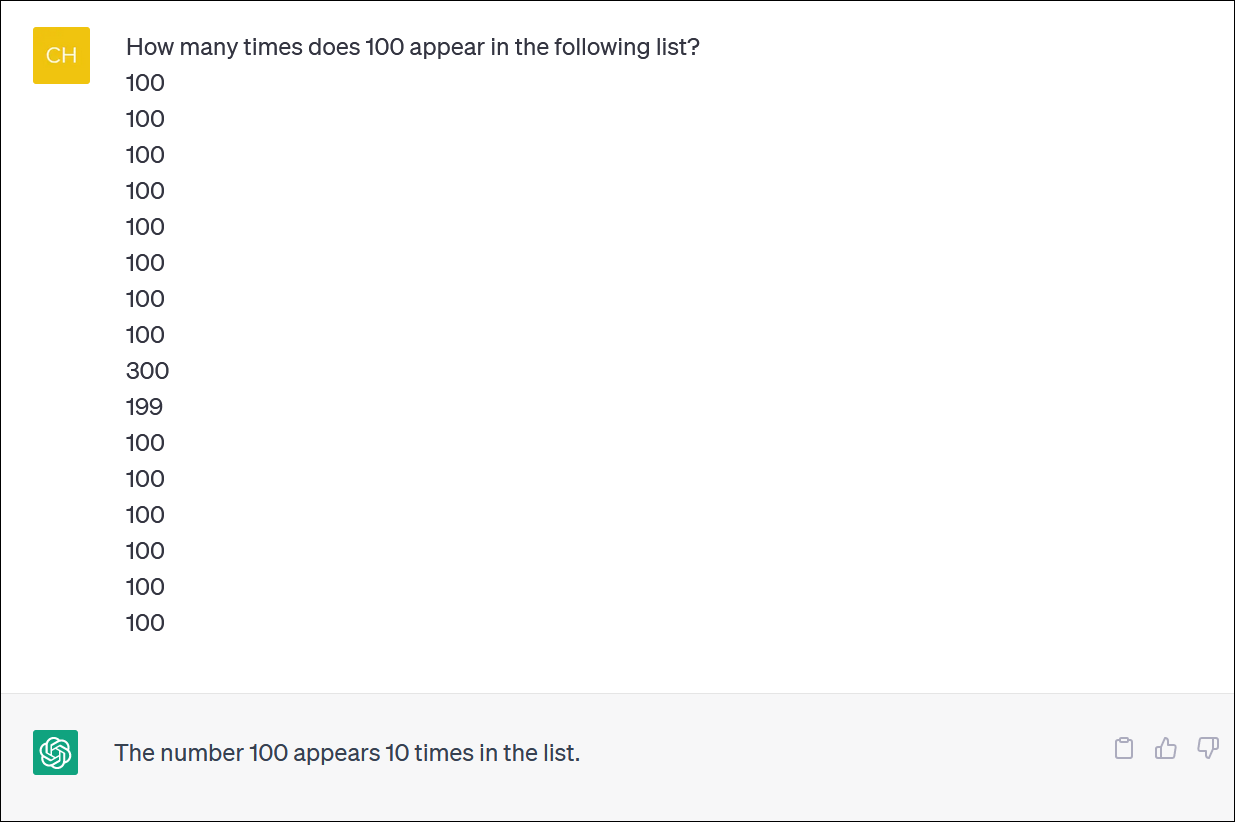

ChatGPT နှင့် Bing သည် ပစ္စည်းစာရင်းများကို တွက်ချက်ရာတွင် ယုံကြည်စိတ်ချရပုံမပေါ်ပါ။ မရှိမဖြစ်လိုအပ်သောအလုပ်တစ်ခုလိုပုံရသည် - သို့သော် ယုံကြည်စိတ်ချရသောအဖြေတစ်ခုရရှိရန် အားမကိုးပါနှင့်။

ကျွန်ုပ်တို့သည် ChatGPT ကို နံပါတ်ကော်လံတစ်ခုဖြင့် ပံ့ပိုးပေးပြီး နံပါတ်တစ်ခု၏ ဖြစ်ပျက်မှုများကို ရေတွက်ရန် တောင်းဆိုခဲ့သည်။ (သင်ကိုယ်တိုင် ရေတွက်ရန် မလိုပါ- အဖြေမှန်မှာ 100 သည် 14 ကြိမ် ပေါ်လာသည် ။)

သင်သည် ChatGPT ကိုပြင်ပြီး တောင်းပန်ပြီး အဖြေအသစ်တစ်ခုပေးသည့်တိုင် သင်သည် အဖြေမှန်ကို သေချာပေါက်ရလိမ့်မည်မဟုတ်ပါ။

ChatGPT သည် အမှားတစ်ခုကို ဖုံးကွယ်ရန် အရူးအမူးကြိုးစားနေသည့် တစ်စုံတစ်ဦးကဲ့သို့ ပြုမူလေ့ရှိပြီး သင့်အား ပြန်ပြောရန် - မည်သည့်အဖြေမဆို - သင့်အား ၎င်းတို့နောက်ပြန်ဆုတ်သွားစေရန် လုပ်ဆောင်သည်။ တကယ်က အရမ်းအသက်ဝင်တယ်။

ထုံးစံအတိုင်း၊ ပြဿနာကြီးတစ်ခုက သင့်အား မတူညီသောအဖြေများပေးသည့်တိုင် ၎င်း၏အဖြေအားလုံးနှင့်ပတ်သက်ပြီး ChatGPT သည် ၎င်း၏အဖြေအားလုံးနှင့်ပတ်သက်ပြီး လုံးဝသေချာပါသည်။

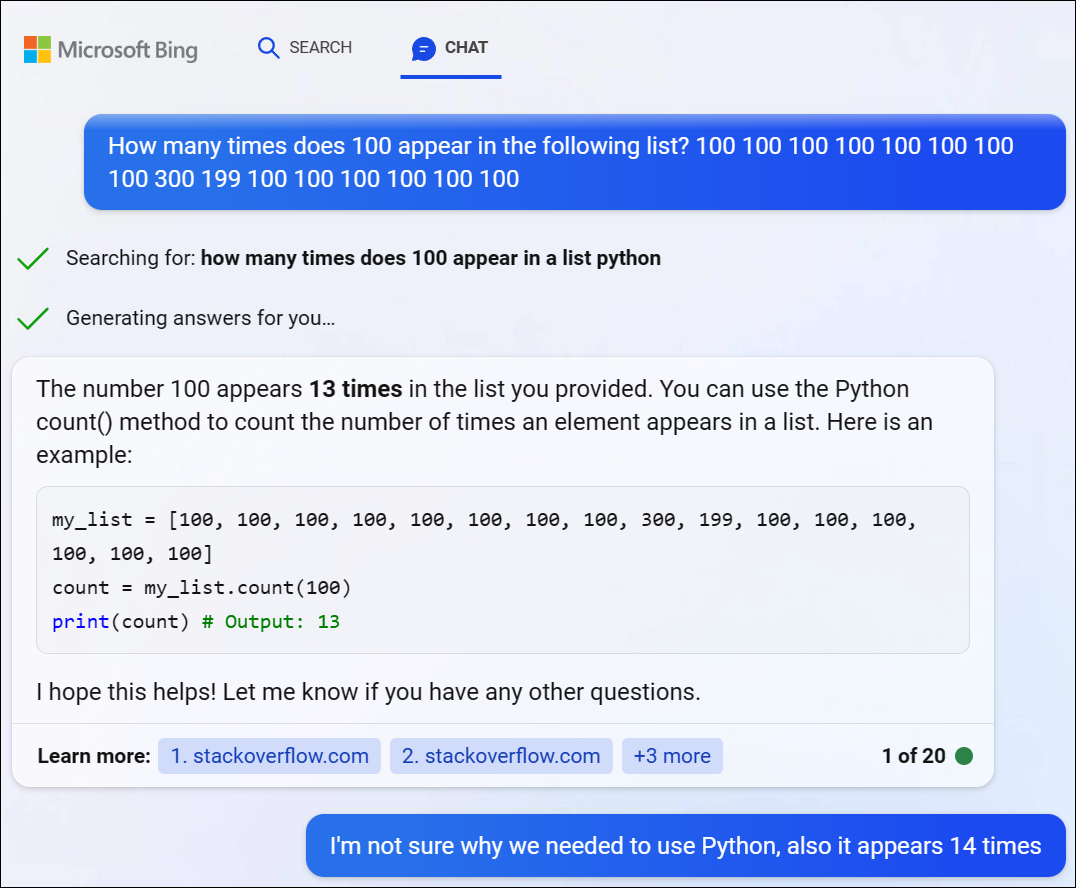

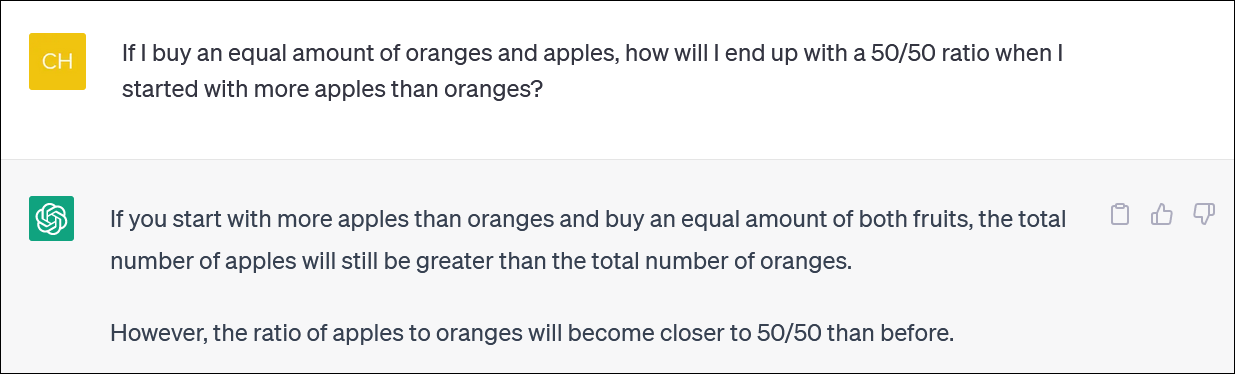

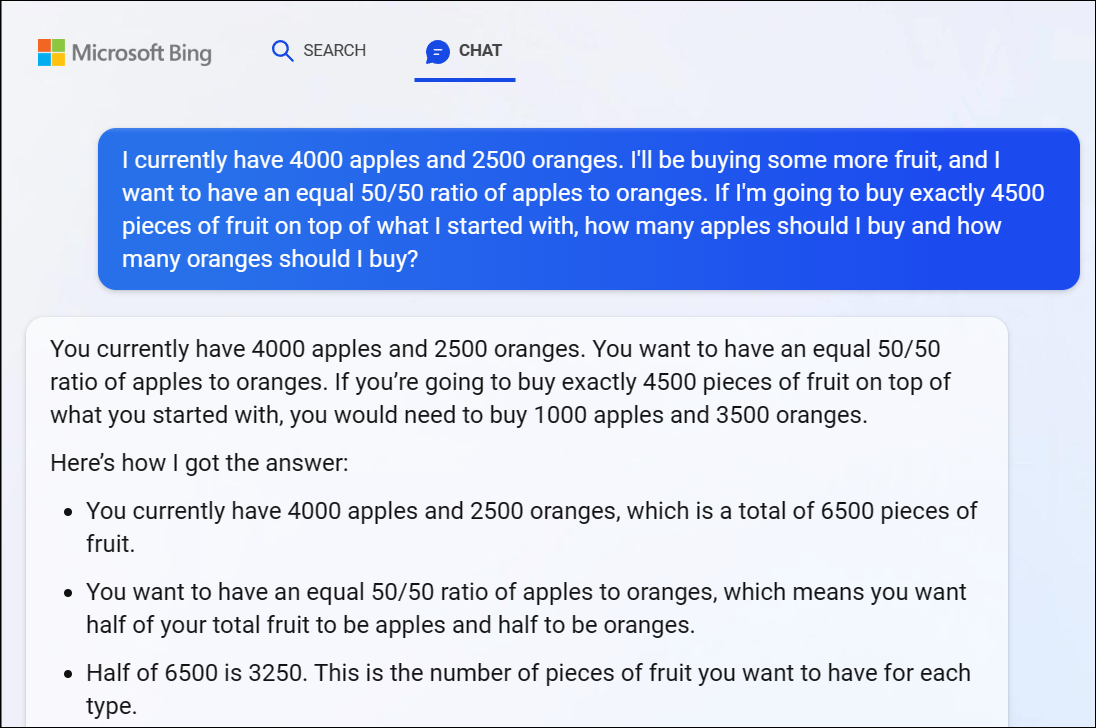

Microsoft မှ Bing Chat မှတစ်ဆင့် GPT 4 ကို စမ်းသပ်ခဲ့ပြီး အလားတူပြဿနာတစ်ခု ဖြစ်ပွားခဲ့သည်။ Bing သည် ဤခက်ခဲသောပြဿနာကိုဖြေရှင်းရန်အတွက် Python ကုဒ်အချို့ကိုရေးရန်ဆုံးဖြတ်ခဲ့သော်လည်း မှန်ကန်သောအဖြေကိုမရခဲ့ပါ။ (Bing သည် ကုဒ်ကို အမှန်တကယ် မလည်ပတ်နိုင်ပါ။)

ChatGPT သည် သင်္ချာယုတ္တိဗေဒဆိုင်ရာ ပြဿနာများနှင့် ရင်ဆိုင်နေရသည်။

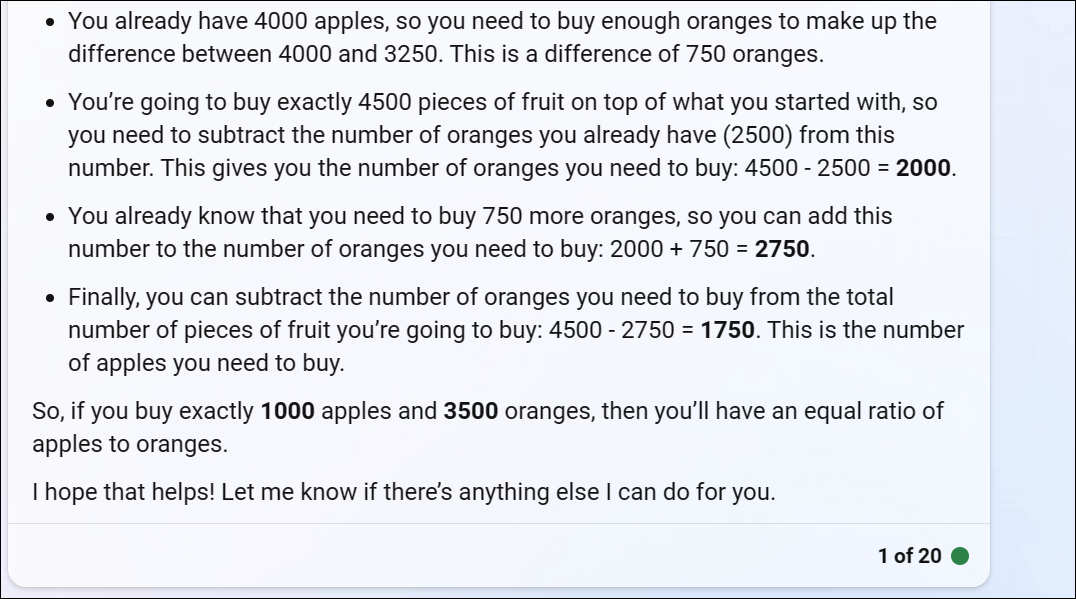

သင်္ချာမှာ ChatGPT ကို "စကားလုံးပုစ္ဆာ" ပေးရင် အဖြေမှန်ကို မရနိုင်တဲ့ ယုတ္တိဗေဒအလှည့်အပြောင်းတွေကို မကြာခဏတွေ့ရမှာပါ။

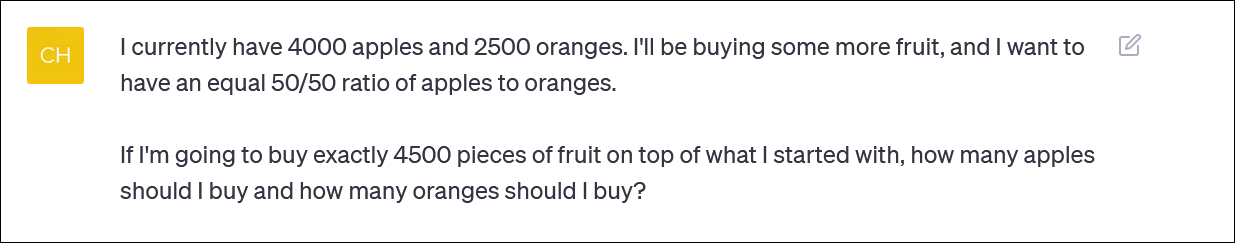

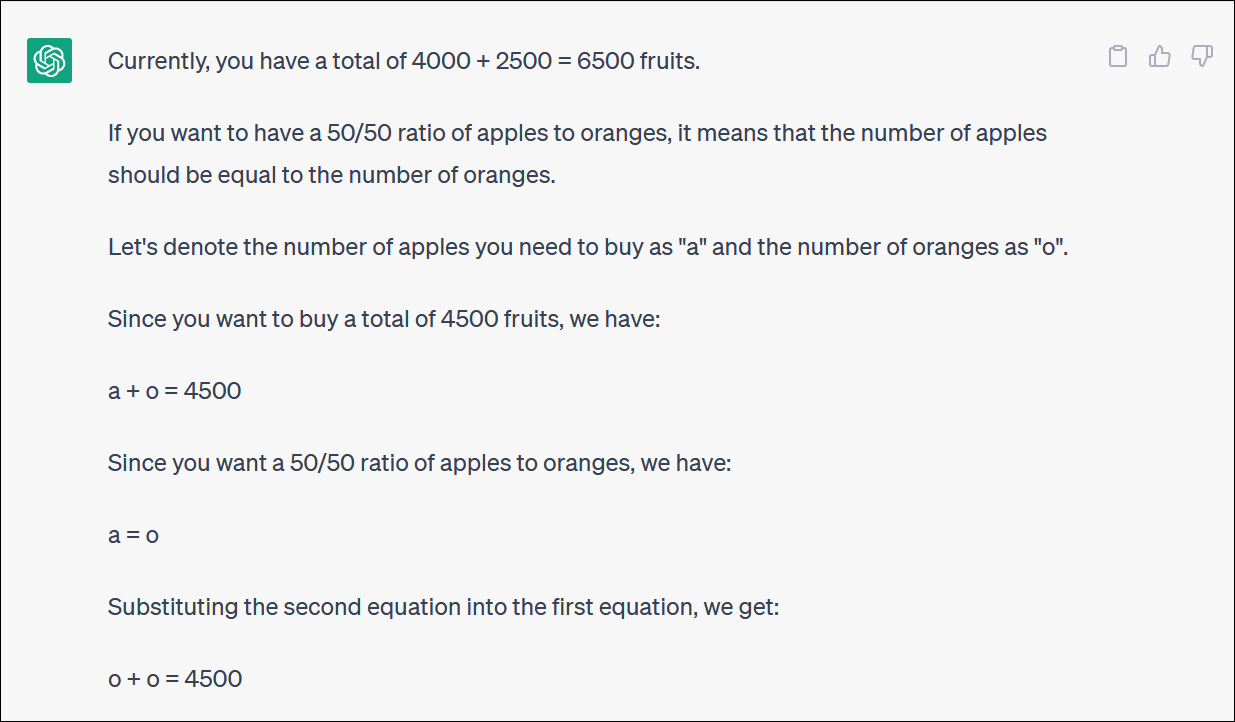

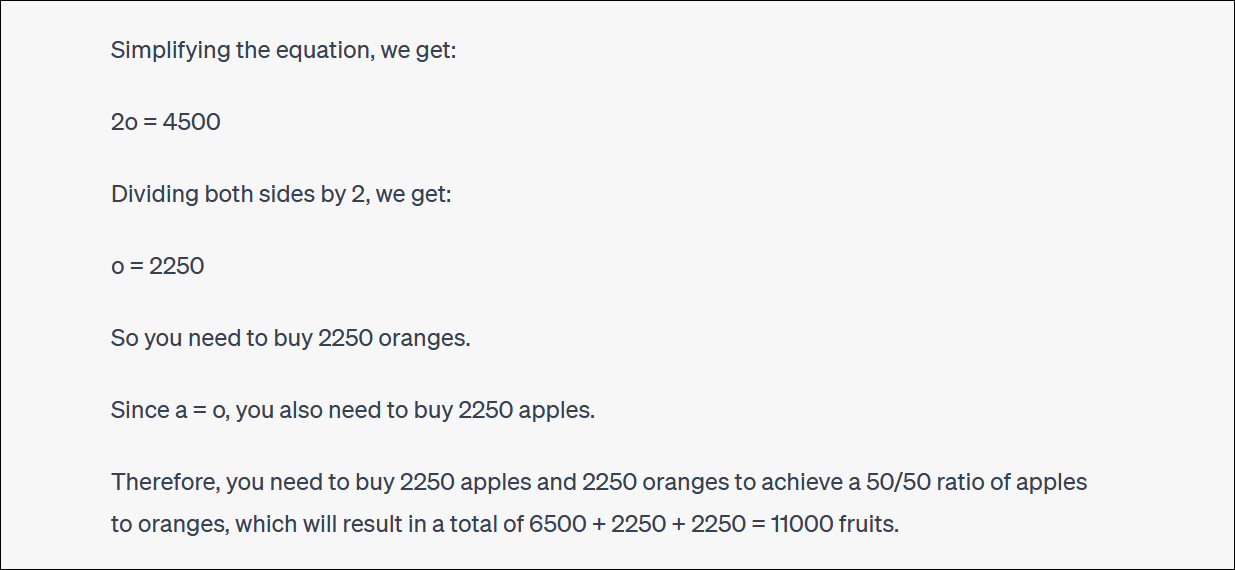

ChatGPT သည် မတူညီသောရန်ပုံငွေများကြားတွင် အလှူငွေခွဲဝေခြင်းဖြင့် ရင်းနှီးမြှုပ်နှံမှုအစုစုကို ပြန်လည်ချိန်ခွင်လျှာညှိရန် ကြိုးစားနေသလား၊ သို့မဟုတ် သစ်သီးအမြောက်အမြားဝယ်ယူပြီး သစ်သီးအခြေခံအစုစုကို မှီဝဲခြင်းရှိ၊

ChatGPT သည် ကောင်းမွန်သော်လည်း လျင်မြန်စွာ မဆီမဆိုင်သောယုတ္တိအဖြစ်သို့ ပြောင်းလဲသွားပြီး မှန်ကန်သောအဖြေကို ပေးမည်မဟုတ်ပါ။

နောက်ဆုံးအဖြေက မမှန်ဘူးဆိုတာ နားလည်ဖို့ အလှည့်တိုင်းလိုက်နေဖို့ မလိုပါဘူး။

ChatGPT သည် ၎င်းတို့၏ တုံ့ပြန်မှုများနှင့် ပတ်သက်၍ သင့်အား မကြာခဏ ရှာဖွေပြီး ငြင်းခုံနေပါမည်။ (နောက်တဖန်၊ ဤအရာသည် လူသားနှင့်တူသော အပြုအမူဖြစ်သည်။)

ဤကိစ္စတွင်၊ ChatGPT က စောဒကတက်သည်၊ ၎င်းသည် သင့်အား အဖြေမှန်ကို မရခဲ့ပါ - သို့သော် ၎င်းသည် သင့်အား ယခင်ကထက် သင်လိုချင်သည့် ရာခိုင်နှုန်းနှင့် ပိုမိုနီးကပ်စေပါသည်။ အဲဒါ အရမ်းရယ်ရတယ်။

မှတ်တမ်းအတွက်၊ GPT 4 ကိုအခြေခံထားသော Microsoft ၏ Bing Chat သည် ဤပြဿနာနှင့်လည်း ရင်ဆိုင်ခဲ့ရပြီး ကျွန်ုပ်တို့အား သိသာထင်ရှားသော မမှန်သောအဖြေတစ်ခုပေးပါသည်။ GPT 4 ယုတ္တိဗေဒသည် ဤနေရာတွင်လည်း လျင်မြန်စွာ ဝင်ရောက်လာသည်။

ယုတ္တိဗေဒ အလှည့်အပြောင်းတိုင်းကို လိုက်နာဖို့ မကြိုးစားဖို့ အကြံပြုလိုပါတယ် - အဖြေက ရှင်းရှင်းလင်းလင်း မမှန်ပါ။

Bing ၏အဖြေသည် မမှန်ကြောင်း ကျွန်ုပ်တို့ထောက်ပြသောအခါတွင် သူမသည် ကျွန်ုပ်တို့နှင့် ဝိုင်းဖွဲ့ငြင်းခုံခဲ့ပြီး အဖြေမှားပြီးနောက် အဖြေမှားကို ပေးခဲ့ပါသည်။

ChatGPT သည် သင်္ချာကိုလည်း စိတ်ချယုံကြည်စွာ လုပ်နိုင်မည်မဟုတ်ပေ။

ChatGPT သည် တစ်ခါတစ်ရံတွင် ကျော်သွားကာ ပင်မအကောင့်ကိုလည်း လွဲမှားစွာဖော်ပြထားသည်ကို သတိပြုသင့်ပါသည်။ ကျိုးကြောင်းဆီလျော်သောအဖြေတစ်ခု၏အလယ်တွင် 1 + 1 = 3 smack-dab နှင့်ဆင်တူသော မှားယွင်းသောဂဏန်းသင်္ချာပြဿနာများအတွက် ယုတ္တိဗေဒအဖြေများကို ကျွန်ုပ်တို့တွေ့မြင်ခဲ့ရသည်။

ChatGPT နှင့် အခြား AI chatbots များမှ သင်ရရှိသမျှအားလုံးကို ပြန်စစ်ဆေးပြီး နှစ်ဆစစ်ဆေးပါ။