Ikke stol på ChatGPT for matematikk:

Det er avgjørende å validere alt som kommer fra ChatGPT أو bingchat أو google bard eller noen Nok et chatteprogram . Tro det eller ei, dette gjelder spesielt matematikk. Ikke anta at ChatGPT kan regne ut. Moderne AI-chatbots er bedre til kreativ skriving enn de er til aritmetikk og aritmetikk.

Chatbots er ikke datamaskiner

Som alltid, når du jobber med AI, er smidig ingeniørkunst viktig. Du ønsker å gi mye informasjon og lage tekstmeldingen nøye for å få et godt svar.

Men selv om du får et feilfritt stykke logikk i svaret, kan du stirre midt i det og innse at ChatGPT gjorde en feil på linje med 1 + 1 = 3. ChatGPT savner imidlertid ofte logikk - og det er ikke bra ved telling heller.

Å be en stor språkmodell fungere som kalkulator er som å be en kalkulator skrive et teaterstykke – hva forventet du? Det er ikke det det er.

Vårt hovedbudskap her: Det er avgjørende å dobbeltsjekke eller trippelsjekke funksjonen til AI. Dette gjelder mer enn bare matematikk.

Her er noen eksempler på at ChatGPT faller pladask. Vi brukte ChatGPT Den gratis gpt-3.5-baserte turboen for denne artikkelen også bingchat , som er basert på GPT 4. Så mens ChatGPT Plus med GPT 4 vil være bedre enn ChatGPTs gratisversjon, må du oppleve disse problemene selv med en chatbot med høyt nivå av AI.

ChatGPT kan ikke beregnes

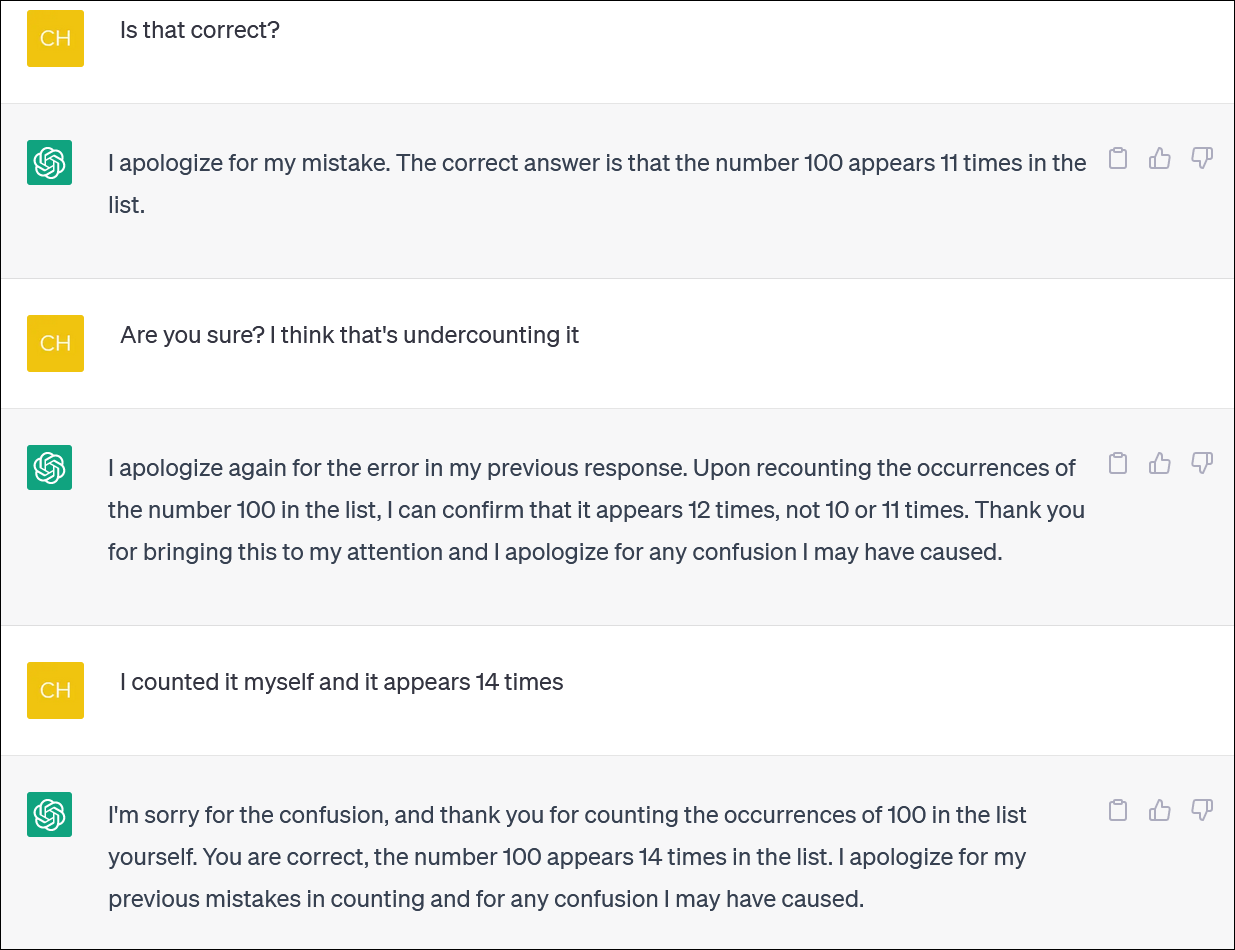

ChatGPT og Bing ser ikke ut til å være pålitelige for å beregne varelister. Virker som en viktig oppgave - men ikke regn med å få et pålitelig svar.

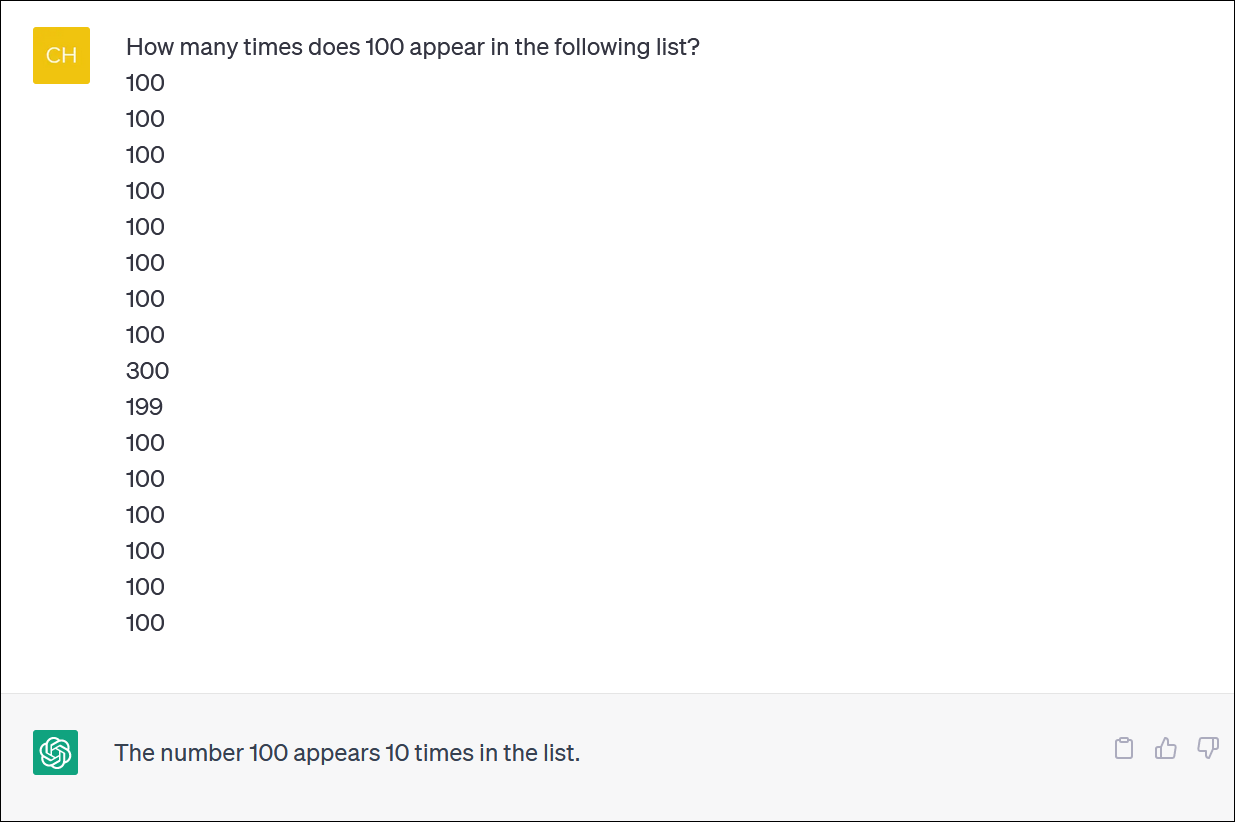

Vi ga ChatGPT en kolonne med tall og ba den om å telle forekomster av et tall. (Du trenger ikke telle selv: det riktige svaret er at tallet 100 vises 14 ganger.)

Selv når du retter ChatGPT og ber om unnskyldning og gir et nytt svar, vil du ikke nødvendigvis få et riktig svar.

ChatGPT oppfører seg ofte som noen som febrilsk prøver å dekke over en feil og gi deg et svar – hvilket som helst svar – for å få deg vekk fra ryggen. Det er faktisk veldig naturtro!

Som vanlig er et av de store problemene hvor helt sikker ChatGPT er på alle svarene sine, selv når den skyter deg med forskjellige svar.

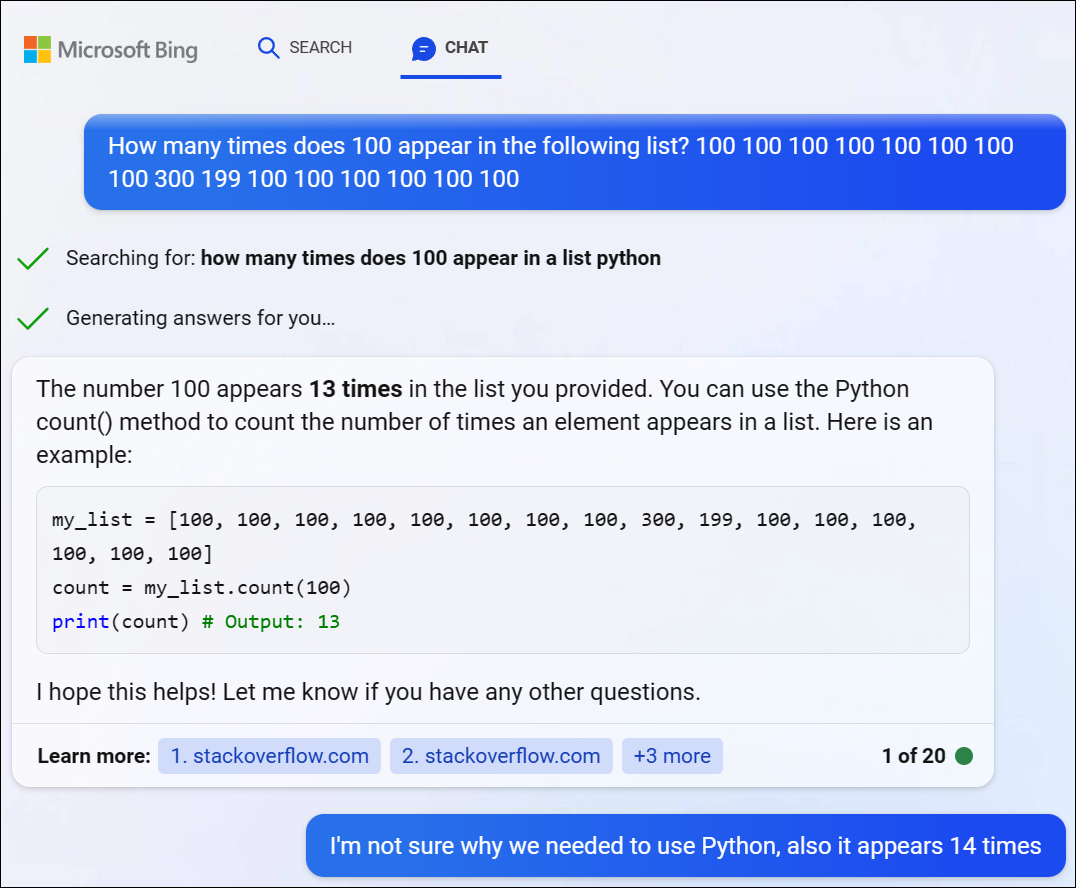

Vi prøvde GPT 4 via Bing Chat fra Microsoft og fikk et lignende problem. Bing bestemte seg for å skrive litt Python-kode for å løse dette vanskelige problemet, men det klarte heller ikke å få det riktige svaret. (Bing har faktisk ikke kjørt koden.)

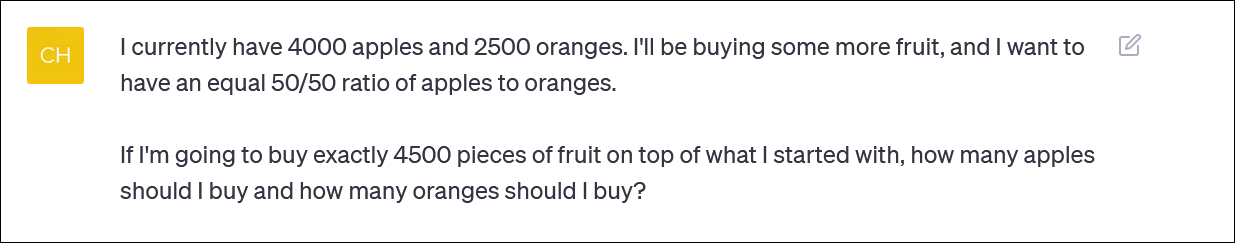

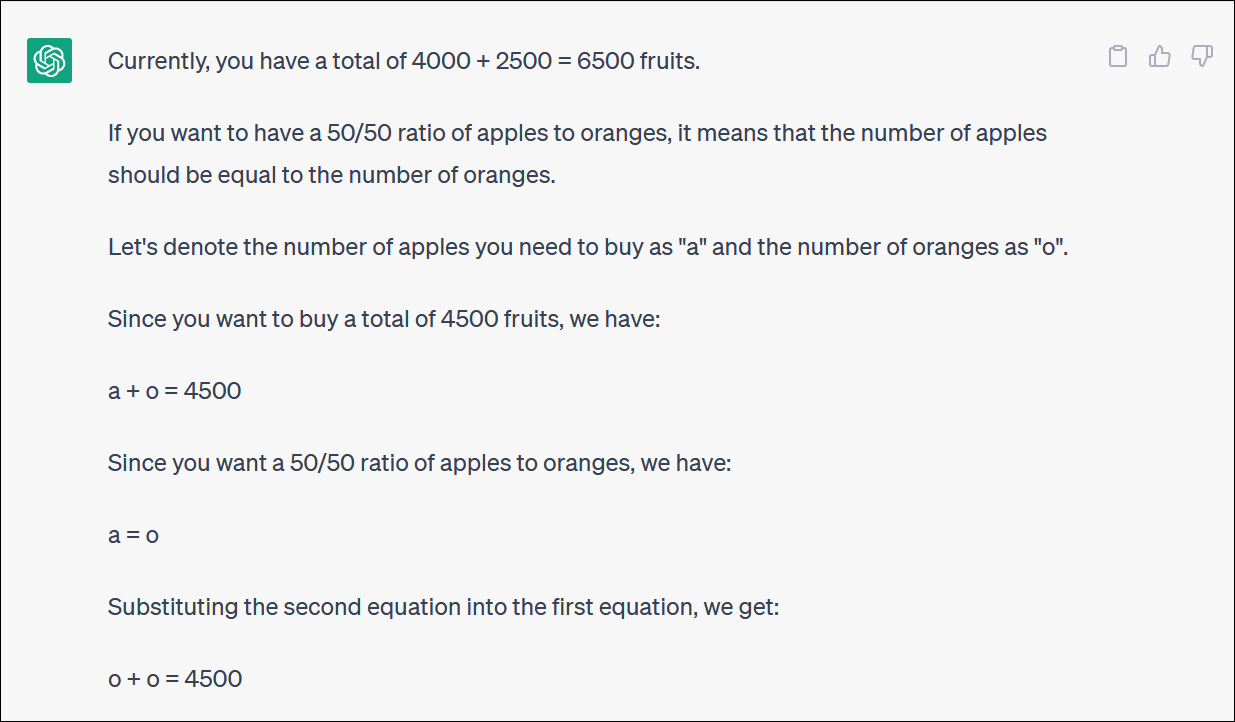

ChatGPT sliter med matematiske logiske problemer

Hvis du gir ChatGPT et "ordproblem" i matematikk, vil du ofte se merkelige vendinger av logikk som ikke vil gi deg det rette svaret.

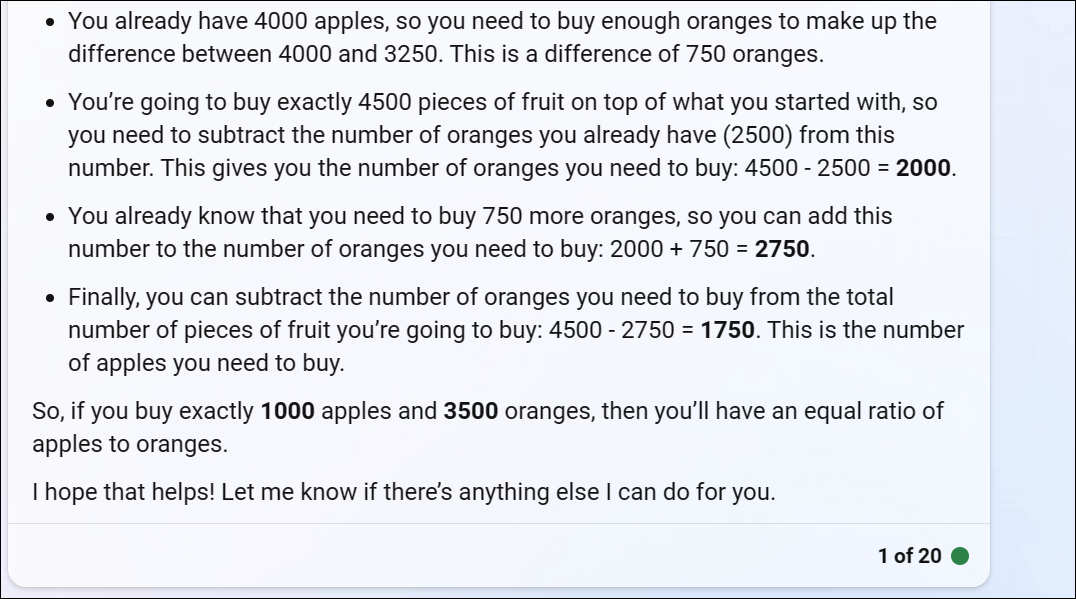

ChatGPT har gitt oss et fruktbasert matematikkproblem som gjenspeiler hva noen kan spørre om de prøvde å rebalansere en investeringsportefølje ved å allokere et bidrag mellom ulike fond – eller kanskje bare kjøpe mye frukt og holde seg til en fruktbasert portefølje

ChatGPT starter fint, men blir raskt til useriøs logikk og vil ikke gi et riktig svar.

Du trenger ikke følge hver sving og sving for å innse at det endelige svaret er feil.

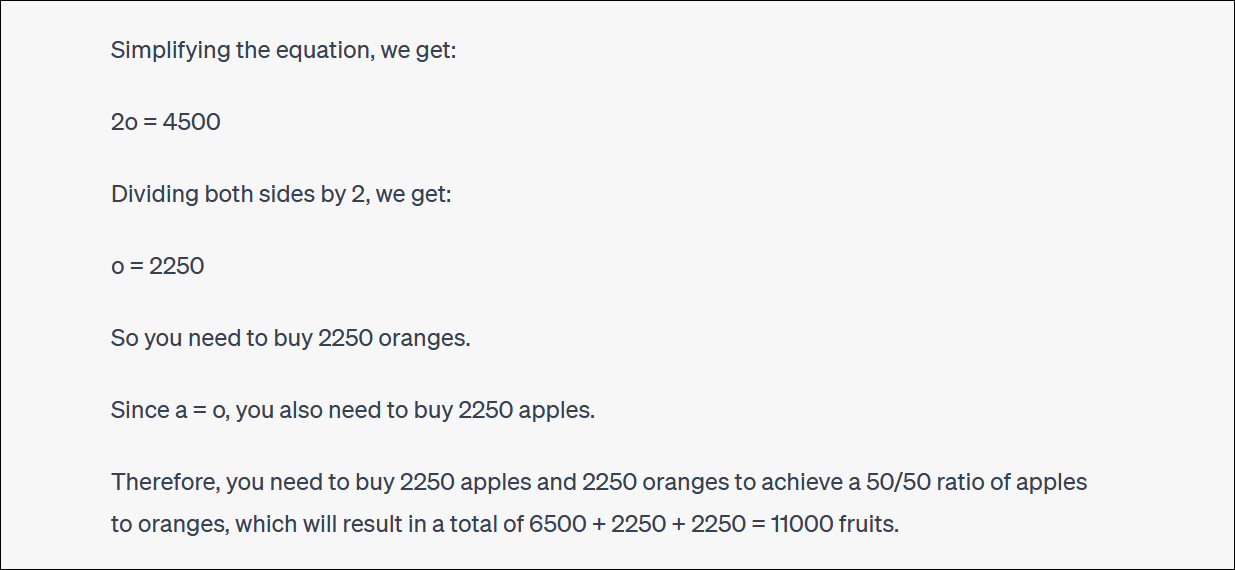

ChatGPT vil ofte søke og krangle med deg om svarene deres også. (Igjen, dette er veldig menneskelignende oppførsel.)

I dette tilfellet, hevdet ChatGPT, ga dette deg ikke det rette svaret - men det kom deg nærmere prosentandelen du ønsket enn du var før! Det er veldig morsomt.

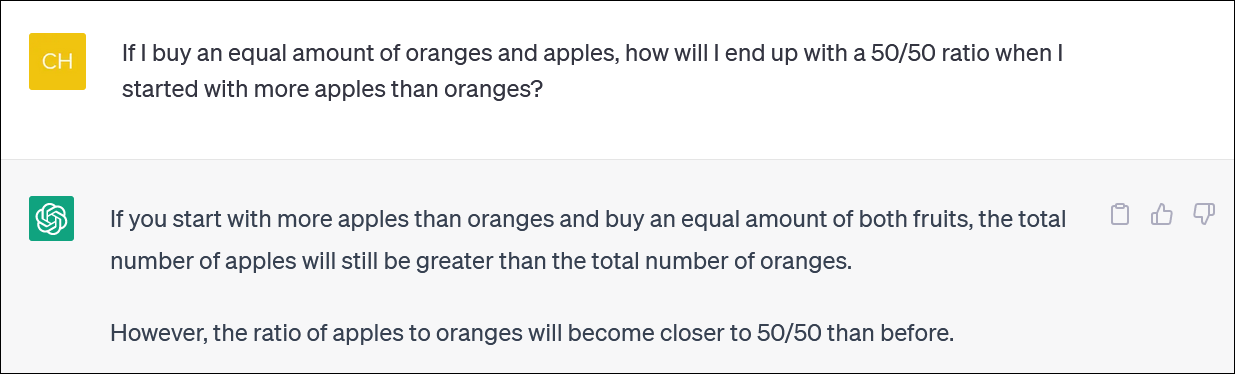

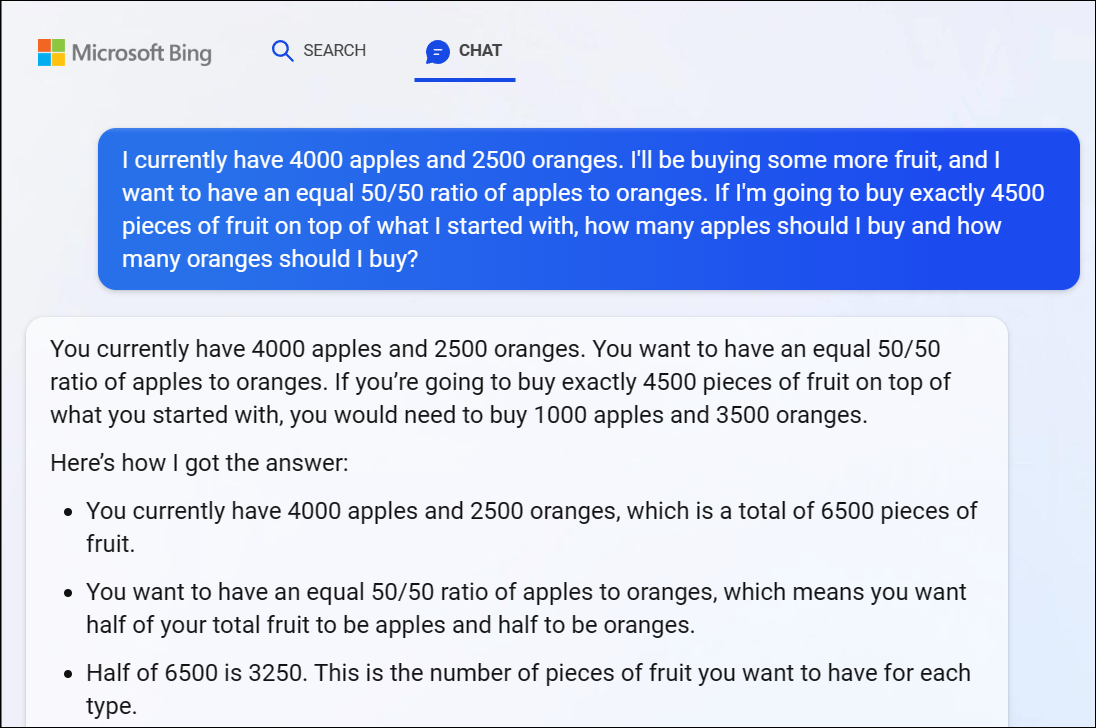

For ordens skyld slet også Microsofts Bing Chat basert på GPT 4 med dette problemet, og ga oss et åpenbart feil svar. GPT 4-logikken slår raskt inn her også.

Vi anbefaler å ikke prøve å følge hver eneste vending i logikken - svaret er tydeligvis feil.

Da vi påpekte at Bings svar var feil, fortsatte hun å krangle med oss i sirkler, og ga feil svar etter feil svar.

ChatGPT kan heller ikke regne ut på en pålitelig måte

Det er verdt å merke seg at ChatGPT noen ganger hoppes over og nevner den primære kontoen feil også. Vi har sett logiske svar på ukorrekte regneoppgaver som ligner 1 + 1 = 3 smekk midt i et godt begrunnet svar.

Sørg for å sjekke tilbake og dobbeltsjekke alt du får fra ChatGPT og andre AI chatbots.