Nie ufaj ChatGPT w kwestiach matematycznych:

Ważne jest, aby zweryfikować wszystko, co pochodzi ChatGPT أو Czat Binga أو Bard Google lub jakikolwiek Kolejny program do czatowania . Wierzcie lub nie, ale dotyczy to zwłaszcza matematyki. Nie zakładaj, że ChatGPT poradzi sobie z matematyką. Nowoczesne chatboty AI są lepsze w kreatywnym pisaniu niż w arytmetyce i arytmetyce.

Chatboty to nie komputery

Jak zawsze, podczas pracy z AI ważna jest zwinna inżynieria. Chcesz podać wiele informacji i starannie przygotować tekst zachęty, aby uzyskać dobrą odpowiedź.

Ale nawet jeśli otrzymasz nieskazitelną logikę w odpowiedzi, możesz wpatrywać się w jej środek i zdać sobie sprawę, że ChatGPT popełnił błąd w stylu 1 + 1 = 3. Jednak ChatGPT często pomija logikę - i to nie jest dobre ani przy liczeniu.

Poproszenie dużego modelu języka, aby działał jako kalkulator, jest jak poproszenie kalkulatora o napisanie sztuki — czego się spodziewałeś? To nie to.

Nasze główne przesłanie tutaj: bardzo ważne jest podwójne lub potrójne sprawdzenie działania sztucznej inteligencji. Dotyczy to nie tylko matematyki.

Oto kilka przykładów upadku ChatGPT na twarz. używaliśmy ChatGPT Darmowe turbo oparte na gpt-3.5 również dla tego artykułu Czat Binga , który jest oparty na GPT 4. Tak więc, chociaż ChatGPT Plus z GPT 4 będzie lepszy niż darmowa wersja ChatGPT, będziesz musiał doświadczyć tych problemów nawet z chatbotem o wysokim poziomie sztucznej inteligencji.

Nie można obliczyć ChatGPT

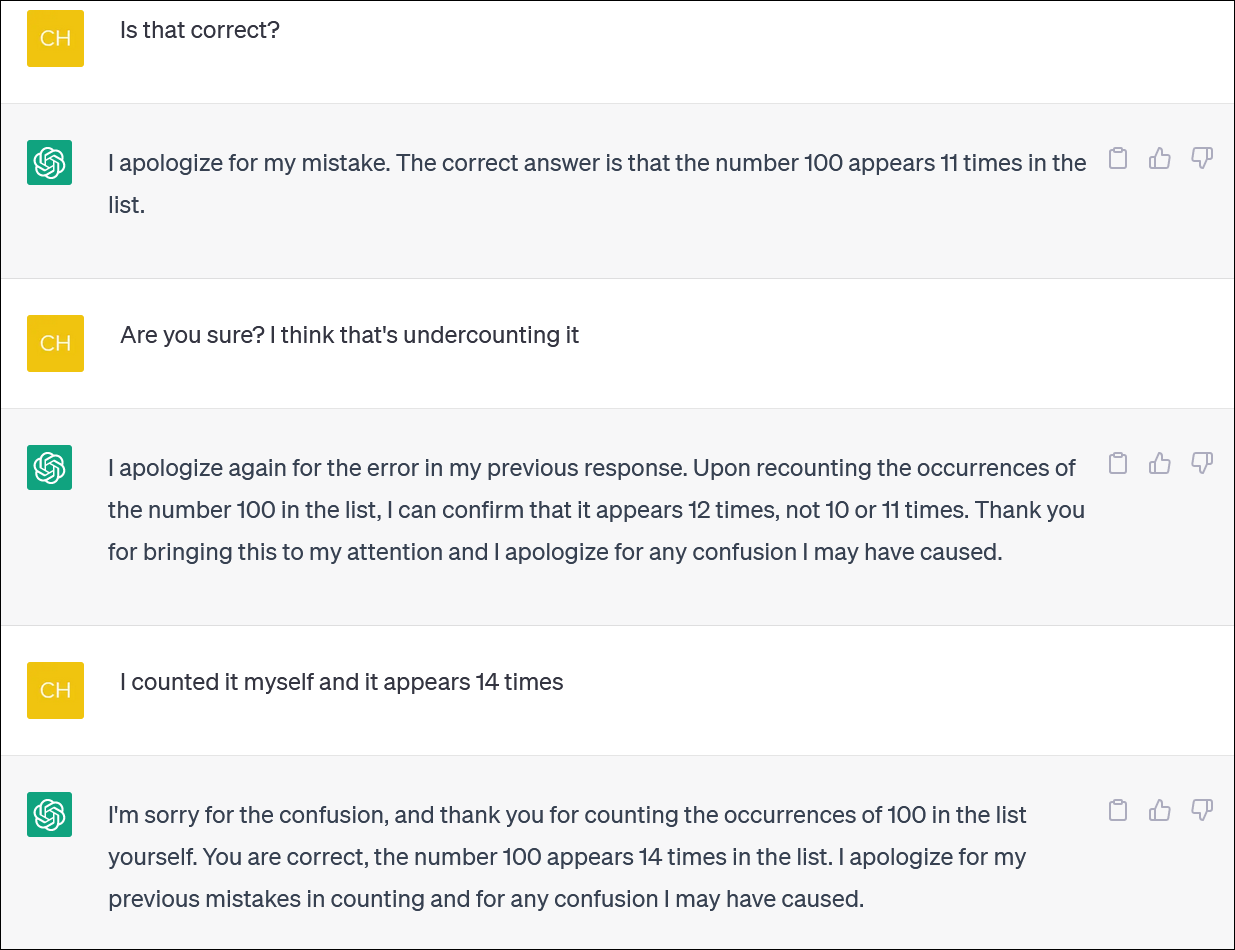

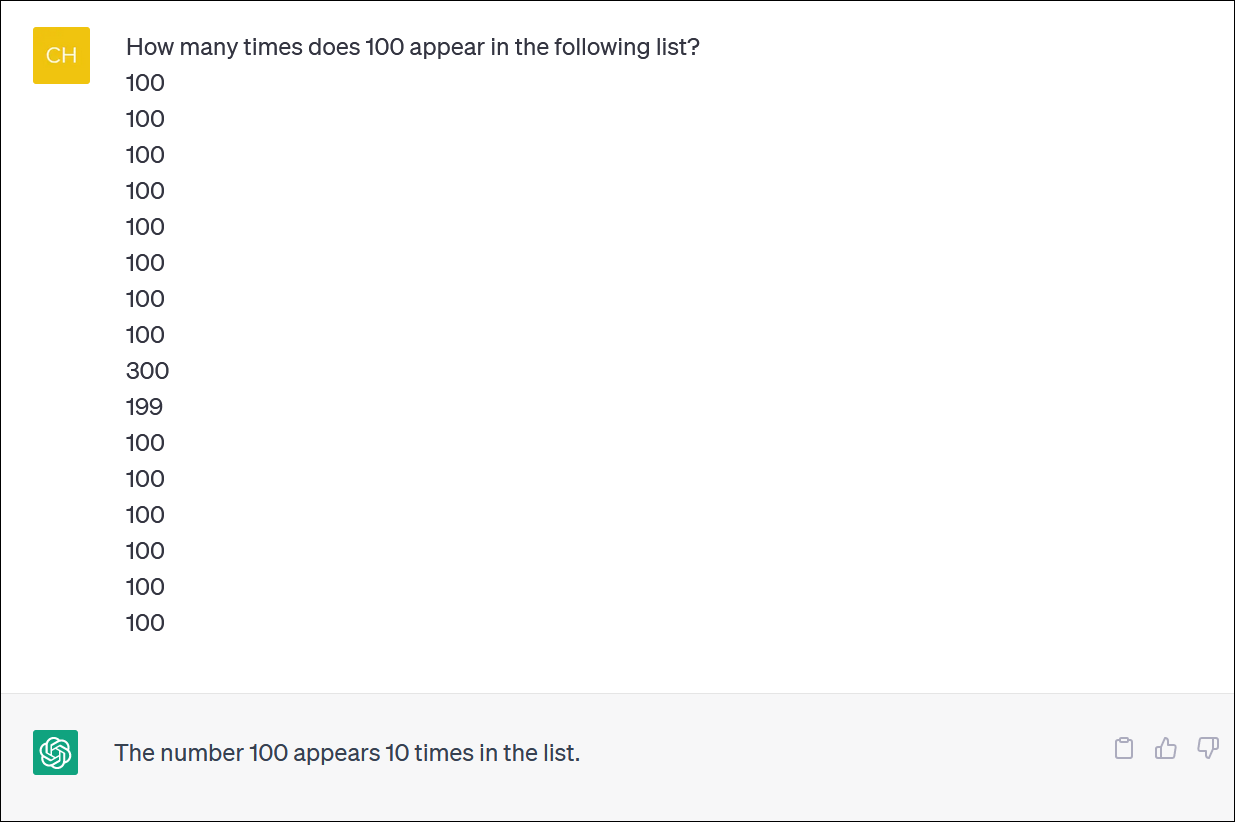

ChatGPT i Bing nie wydają się być wiarygodne do obliczania list przedmiotów. Wydaje się, że jest to niezbędne zadanie - ale nie licz na wiarygodną odpowiedź.

Udostępniliśmy ChatGPT kolumnę liczb i poprosiliśmy o policzenie wystąpień liczby. (Nie musisz się liczyć: prawidłowa odpowiedź brzmi, że liczba 100 pojawia się 14 razy).

Nawet jeśli poprawisz ChatGPT, przeprosisz i podasz nową odpowiedź, niekoniecznie otrzymasz poprawną odpowiedź.

ChatGPT często zachowuje się tak, jakby ktoś gorączkowo próbował zatuszować pomyłkę i udzielić odpowiedzi — dowolnej odpowiedzi — aby odwrócić od siebie uwagę. To naprawdę bardzo życiowe!

Jak zwykle, jednym z największych problemów jest to, jak absolutnie pewny ChatGPT jest na temat wszystkich swoich odpowiedzi, nawet jeśli wysyła ci różne odpowiedzi.

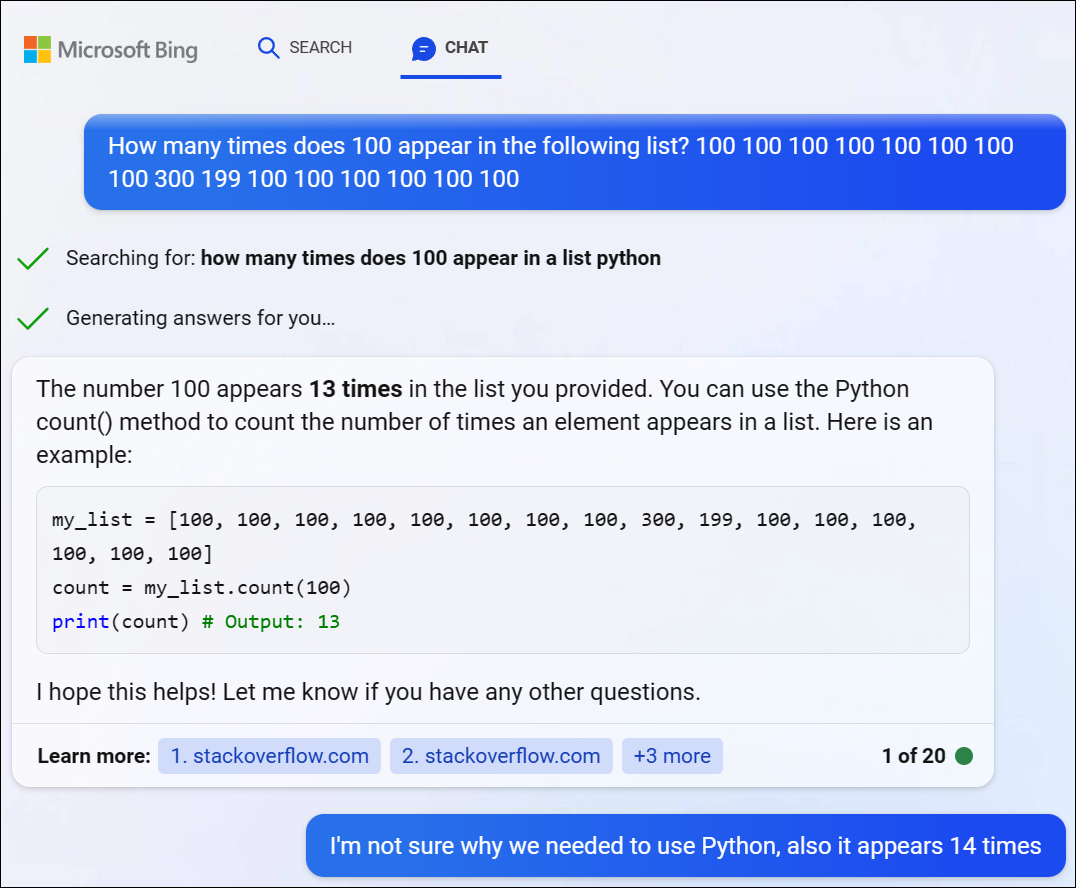

Wypróbowaliśmy GPT 4 przez Bing Chat od Microsoft i napotkaliśmy podobny problem. Bing zdecydował się napisać kod w Pythonie, aby rozwiązać ten trudny problem, ale również nie uzyskał właściwej odpowiedzi. (Bing tak naprawdę nie uruchomił kodu).

ChatGPT zmaga się z problemami z logiką matematyczną

Jeśli zadasz ChatGPT „zadanie tekstowe” z matematyki, często zobaczysz dziwne zwroty akcji, które nie dadzą ci właściwej odpowiedzi.

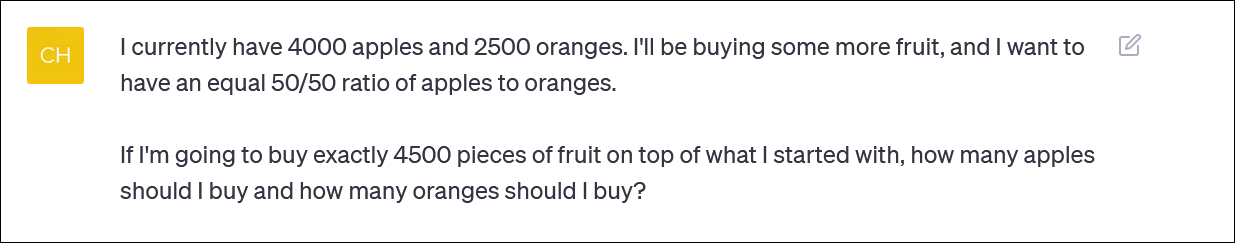

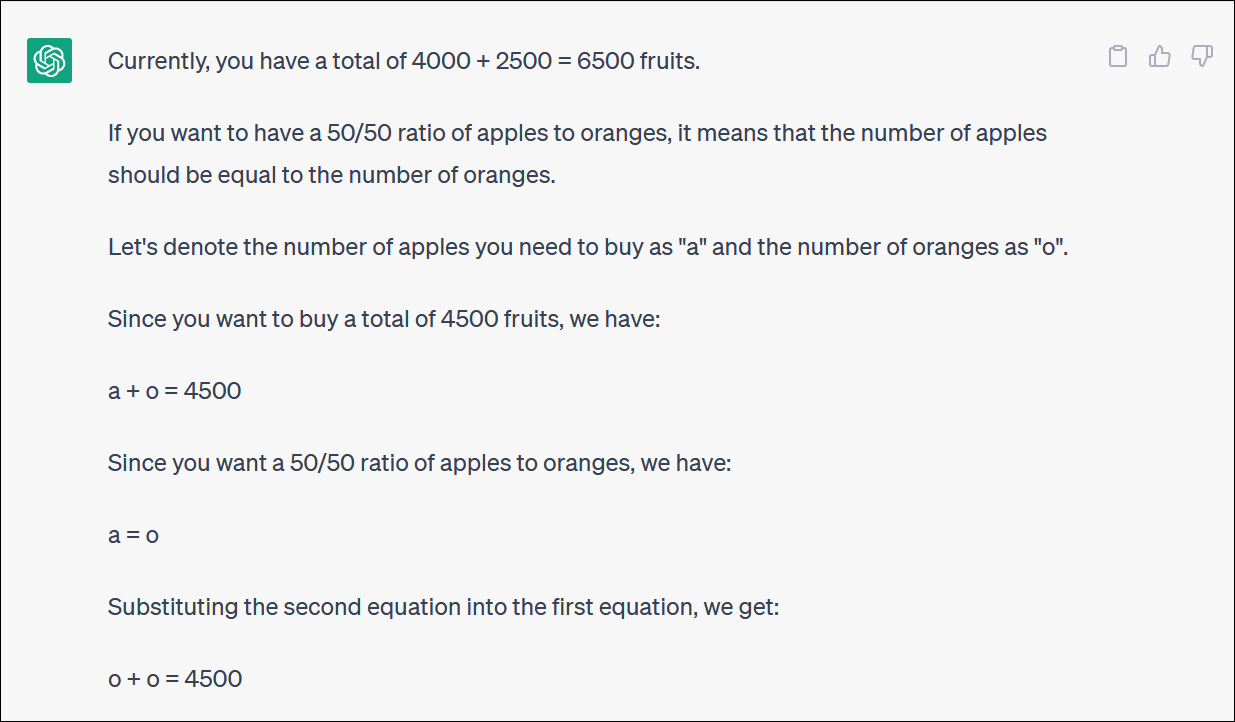

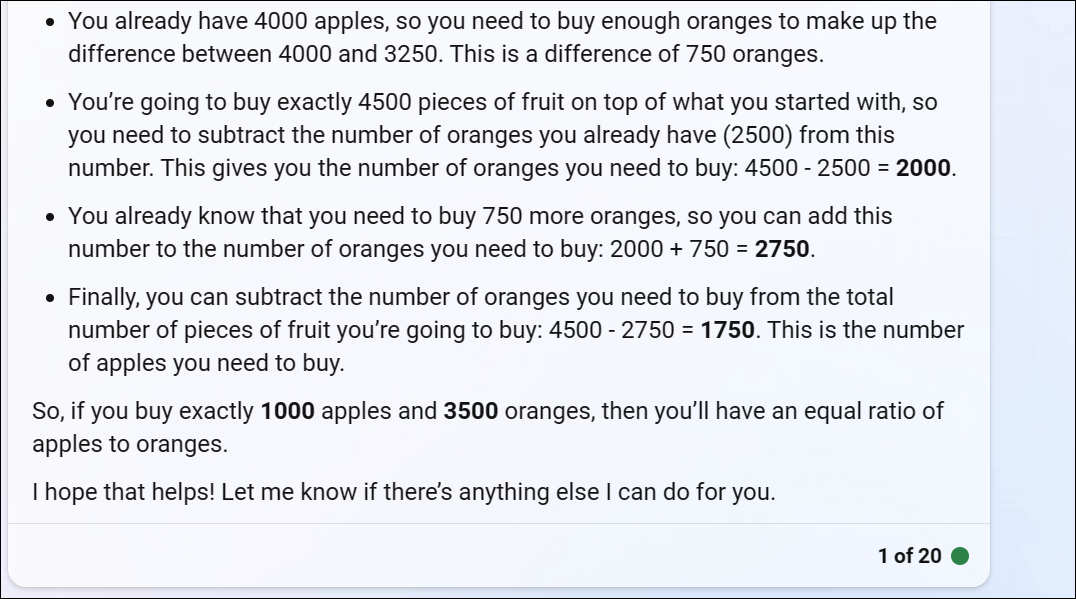

ChatGPT dostarczył nam problem matematyczny oparty na owocach, który odzwierciedla pytanie, o które ktoś mógłby zapytać, gdyby próbował zrównoważyć portfel inwestycyjny poprzez alokację wkładu między różne fundusze – lub po prostu kupowanie dużej ilości owoców i trzymanie się portfela opartego na owocach

ChatGPT zaczyna się dobrze, ale szybko zamienia się w bezsensowną logikę i nie daje poprawnej odpowiedzi.

Nie musisz śledzić każdego zakrętu i zakrętu, aby zdać sobie sprawę, że ostateczna odpowiedź jest błędna.

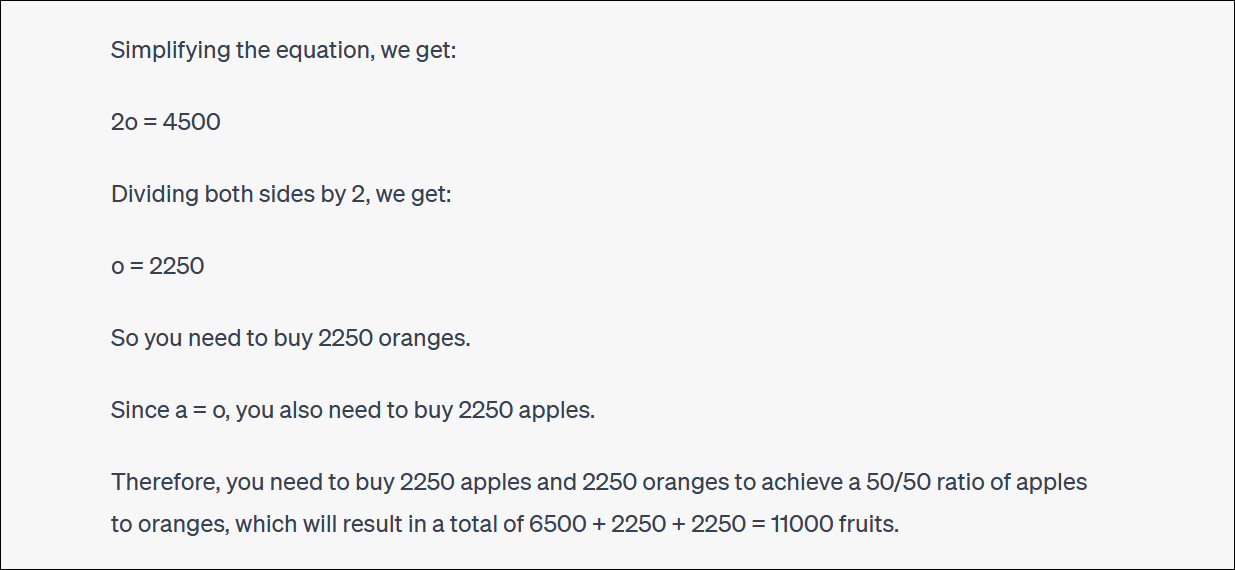

ChatGPT będzie często wyszukiwać i kłócić się z Tobą również o ich odpowiedzi. (Ponownie, jest to bardzo ludzkie zachowanie.)

W tym przypadku, argumentował ChatGPT, to nie dało ci właściwej odpowiedzi – ale zbliżyło cię do pożądanego procentu, niż byłeś wcześniej! To jest bardzo śmieszne.

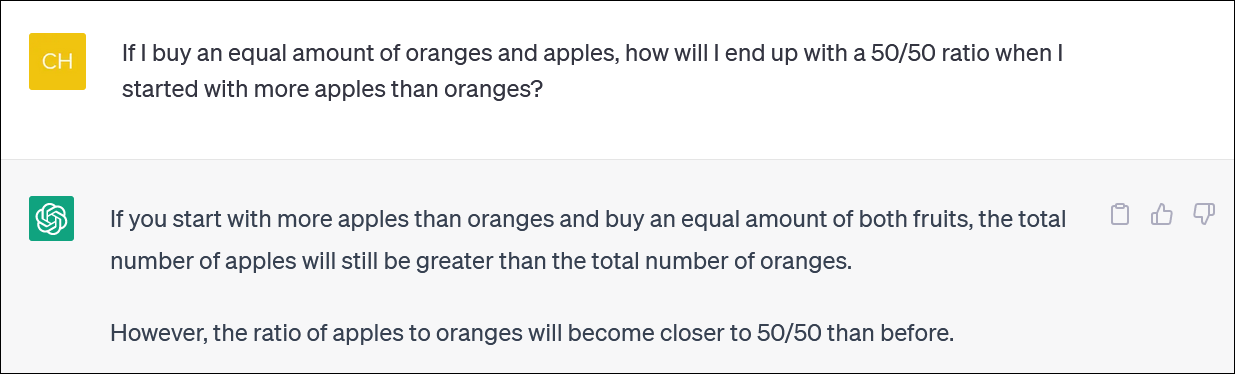

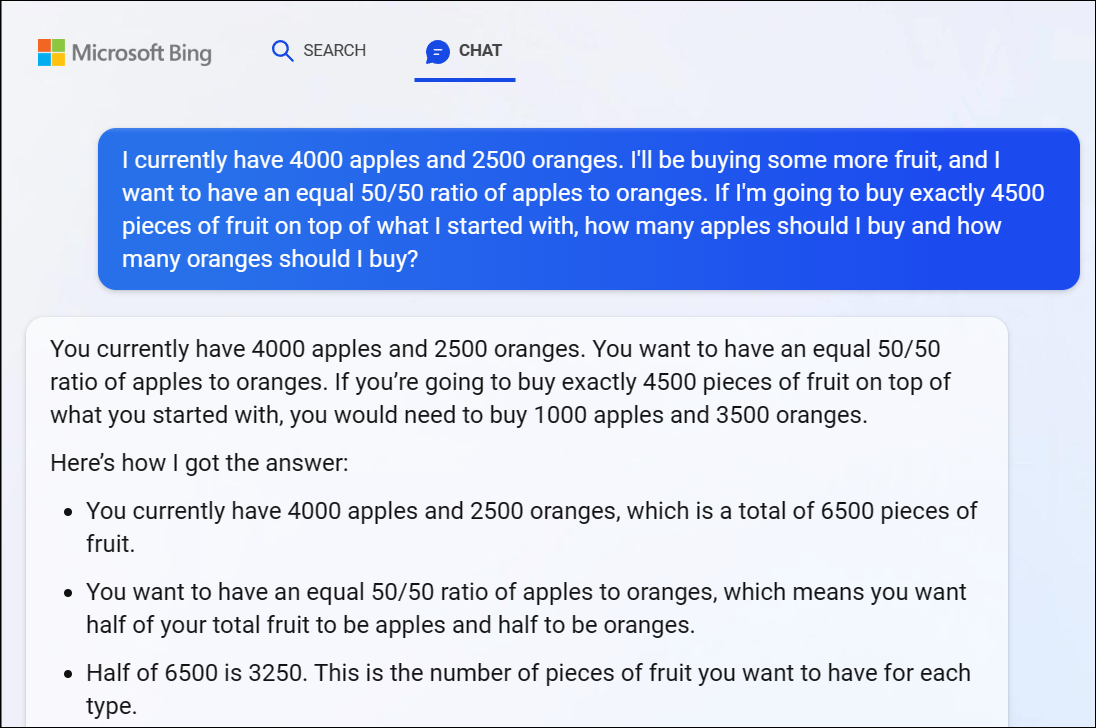

Dla przypomnienia, Bing Chat firmy Microsoft oparty na GPT 4 również borykał się z tym problemem, dając nam oczywiście błędną odpowiedź. Logika GPT 4 również tutaj szybko działa.

Zalecamy, aby nie próbować podążać za każdym zwrotem logiki - odpowiedź jest wyraźnie błędna.

Kiedy wskazaliśmy, że odpowiedź Bing była błędna, dalej kłóciła się z nami w kółko, podając błędną odpowiedź za błędną odpowiedzią.

ChatGPT również nie może rzetelnie wykonać obliczeń

Warto zauważyć, że ChatGPT jest czasami pomijany i błędnie wspomina również o koncie głównym. Widzieliśmy logiczne odpowiedzi na niepoprawne problemy arytmetyczne, podobne do 1 + 1 = 3 smack-dab w środku dobrze uzasadnionej odpowiedzi.

Pamiętaj, aby sprawdzić ponownie i dokładnie sprawdzić wszystko, co otrzymujesz od ChatGPT i innych chatbotów AI.