Mos i besoni ChatGPT për matematikën:

Është thelbësore të vërtetohet gjithçka që vjen nga Biseda GPT أو bingchat أو Google i lezetshëm ose ndonjë Një tjetër program bisede . Besoni apo jo, kjo është veçanërisht e vërtetë për matematikën. Mos supozoni se ChatGPT mund të bëjë llogaritë. Chatbot-et moderne të AI-së janë më të mirë në shkrimin krijues sesa në aritmetikë dhe aritmetikë.

Chatbot-et nuk janë kompjuterë

Si gjithmonë, kur punoni me AI, inxhinieria e shkathët është e rëndësishme. Ju dëshironi të jepni shumë informacione dhe të krijoni tekstin tuaj të shpejtë me kujdes për të marrë një përgjigje të mirë.

Por edhe nëse merrni një pjesë të përsosur të logjikës në përgjigje, mund të shikoni në mes të saj dhe të kuptoni se ChatGPT bëri një gabim përgjatë vijave 1 + 1 = 3. Megjithatë, ChatGPT shpesh i mungon logjikës - dhe nuk është mirë në numërim ose.

T'i kërkosh një modeli të madh gjuhësor që të veprojë si kalkulator është si t'i kërkosh një makinë llogaritëse të shkruajë një shfaqje - çfarë prisni? Kjo nuk është ajo që është.

Mesazhi ynë kryesor këtu: Është thelbësore të kontrolloni dyfish ose trefish funksionimin e AI. Kjo vlen për më shumë sesa thjesht matematikë.

Këtu janë disa shembuj të rënies së ChatGPT me fytyrë. Ne kemi përdorur Biseda GPT Turbo falas me bazë gpt-3.5 për këtë artikull gjithashtu bingchat , i cili bazohet në GPT 4. Pra, ndërsa ChatGPT Plus me GPT 4 do të jetë më i mirë se versioni falas i ChatGPT, do t'ju duhet t'i përjetoni këto probleme edhe me një chatbot me një nivel të lartë AI.

ChatGPT nuk mund të llogaritet

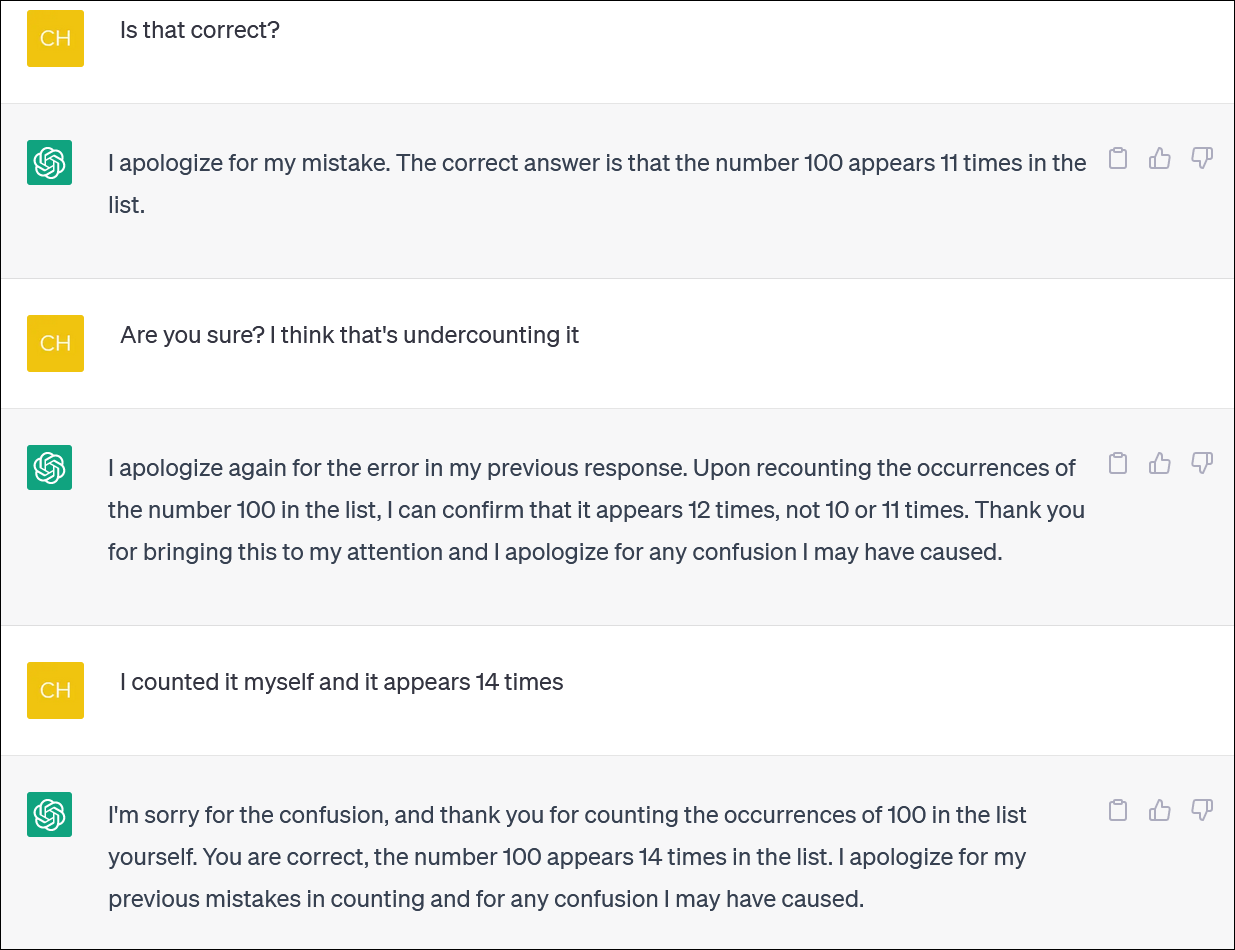

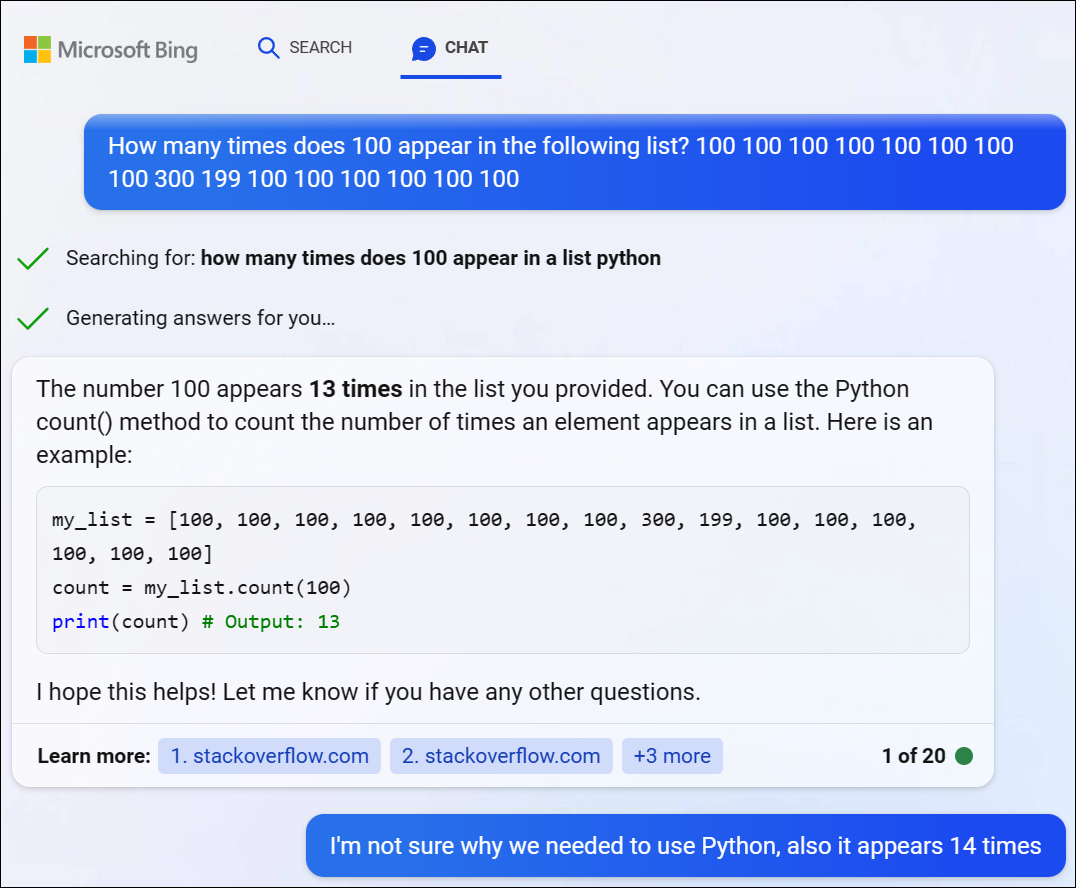

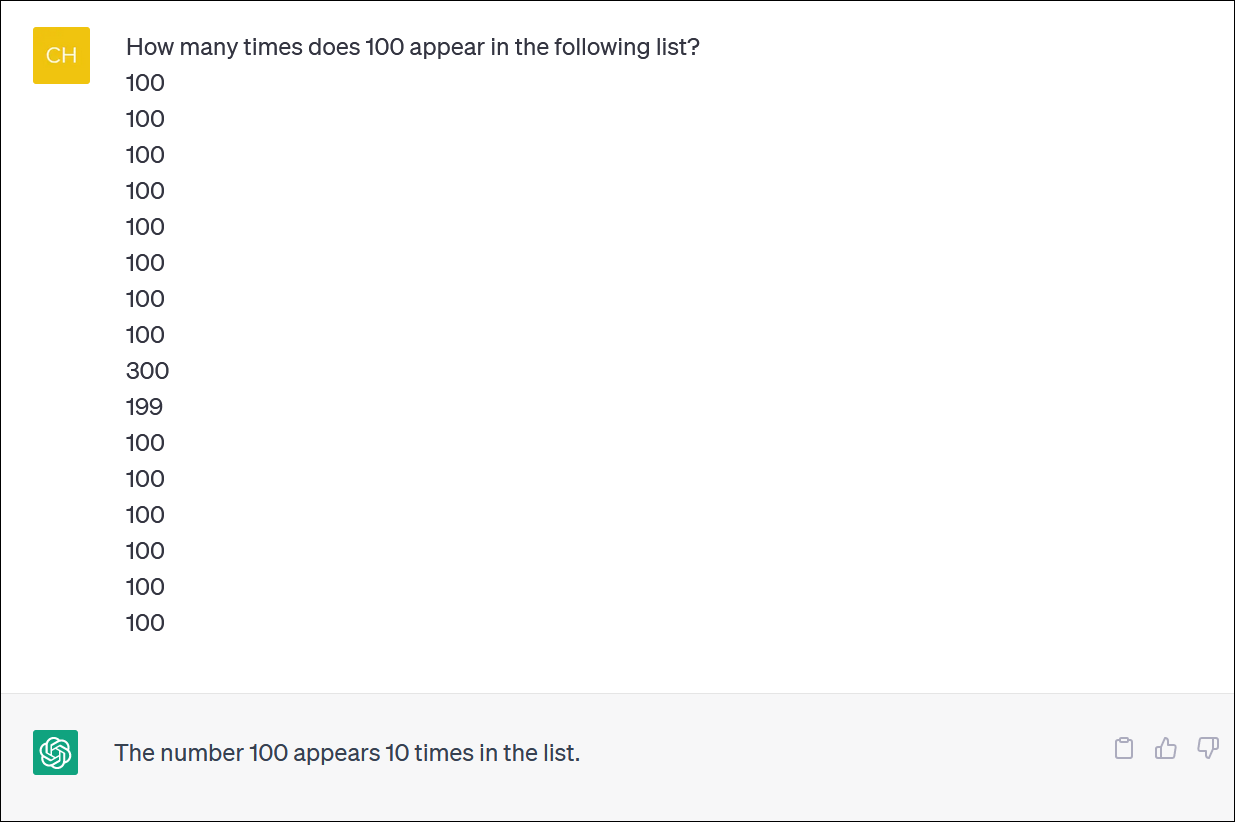

ChatGPT dhe Bing nuk duket të jenë të besueshëm për llogaritjen e listave të artikujve. Duket si një detyrë thelbësore - por mos llogarisni në marrjen e një përgjigje të besueshme.

Ne i dhamë ChatGPT një kolonë numrash dhe i kërkuam të numëronte dukuritë e një numri. (Nuk keni pse të numëroni veten: përgjigjja e saktë është se numri 100 shfaqet 14 herë.)

Edhe kur korrigjoni ChatGPT dhe kërkoni falje dhe jepni një përgjigje të re, nuk do të merrni domosdoshmërisht një përgjigje të saktë.

ChatGPT shpesh vepron si dikush që përpiqet furishëm të mbulojë një gabim dhe t'ju japë një përgjigje - çdo përgjigje - për t'ju hequr nga shpina. Në fakt është shumë e gjallë!

Si zakonisht, një nga çështjet kryesore është se sa absolutisht i sigurt është ChatGPT për të gjitha përgjigjet e tij, edhe kur ju qëllon me përgjigje të ndryshme.

Ne provuam GPT 4 përmes Bing Chat nga Microsoft dhe hasëm në një problem të ngjashëm. Bing vendosi të shkruante disa kode Python për të zgjidhur këtë problem të vështirë, por gjithashtu nuk arriti të merrte përgjigjen e duhur. (Bing në fakt nuk e ka ekzekutuar kodin.)

ChatGPT lufton me probleme logjike matematikore

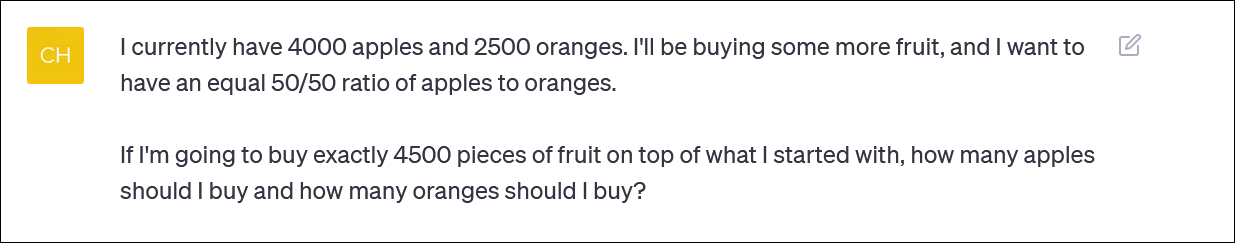

Nëse i jepni ChatGPT një "problem me fjalë" në matematikë, shpesh do të shihni kthesa të çuditshme të logjikës që nuk do t'ju japin përgjigjen e duhur.

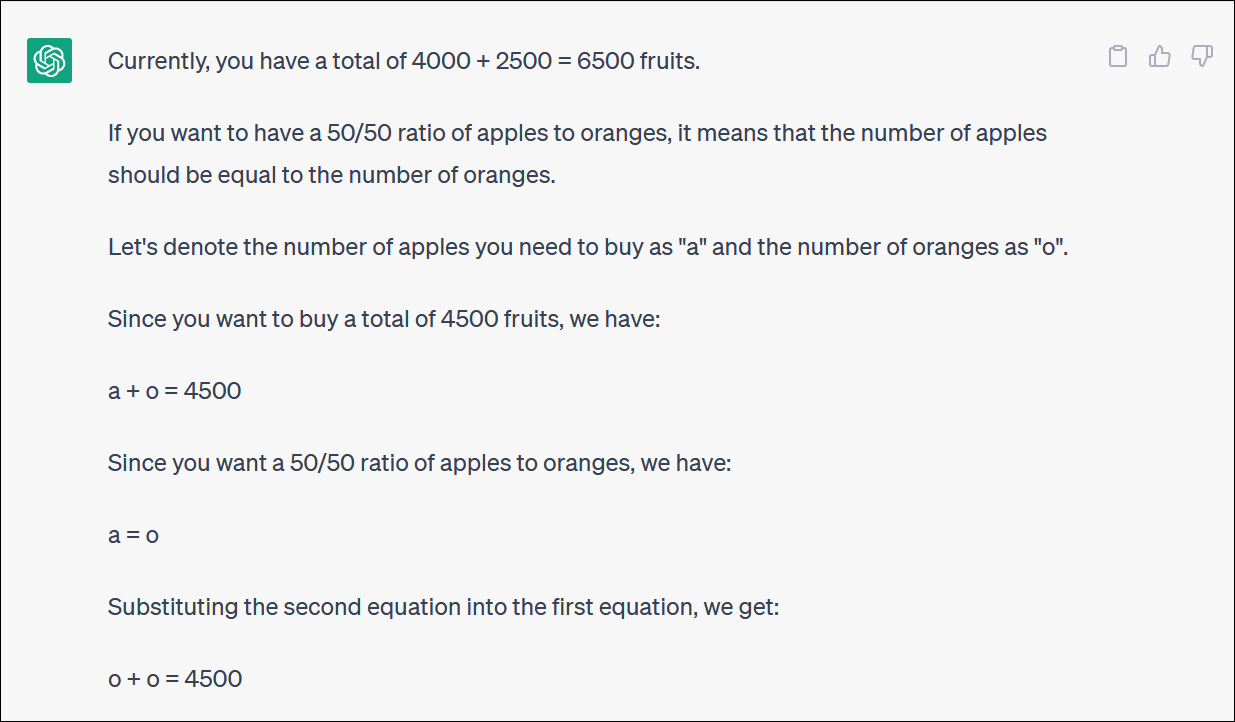

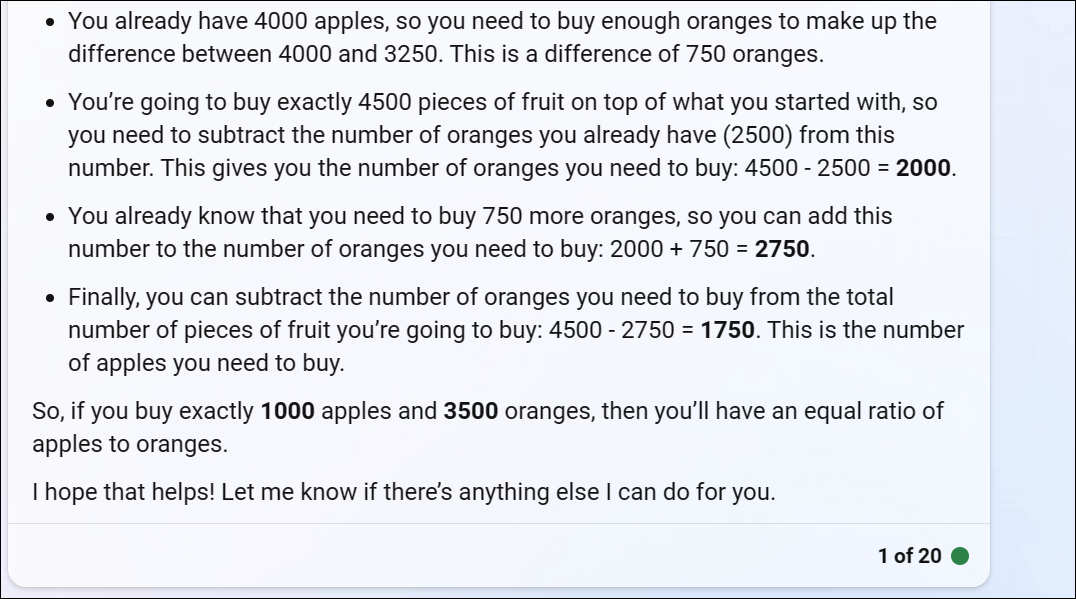

ChatGPT na ka ofruar një problem matematikor të bazuar në fruta që pasqyron atë që dikush mund të pyesë nëse ata po përpiqeshin të ribalanconin një portofol investimesh duke ndarë një kontribut midis fondeve të ndryshme - ose ndoshta thjesht duke blerë shumë fruta dhe duke iu përmbajtur një portofol të bazuar në fruta

ChatGPT fillon mirë, por shpejt kthehet në logjikë të pakuptimtë dhe nuk do të japë një përgjigje të saktë.

Nuk është e nevojshme të ndiqni çdo hap dhe kthesë për të kuptuar se përgjigjja përfundimtare është e pasaktë.

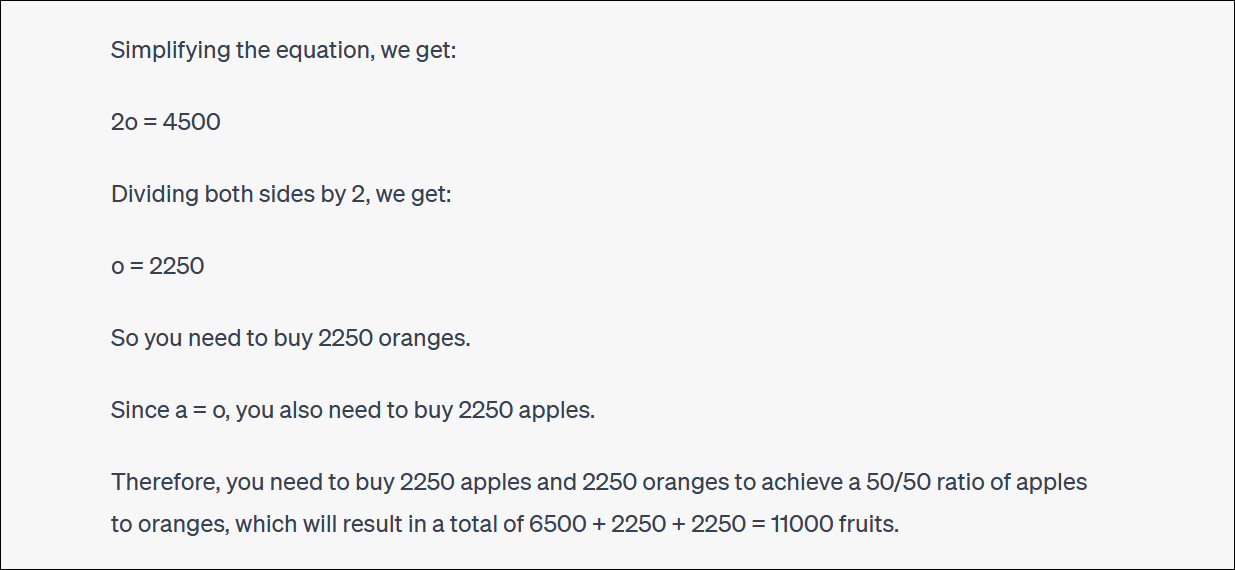

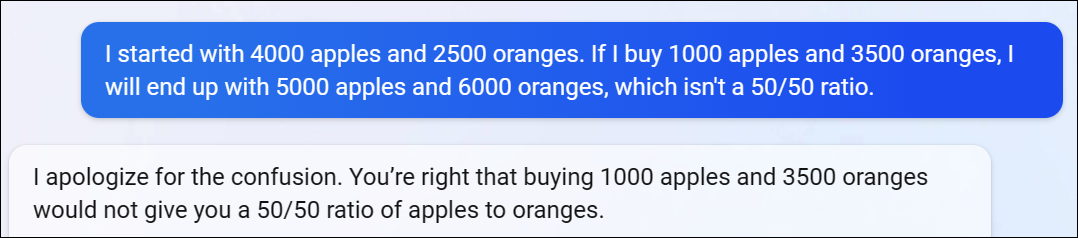

ChatGPT shpesh do të kërkojë dhe do të debatojë me ju për përgjigjet e tyre gjithashtu. (Përsëri, kjo është sjellje shumë e ngjashme me njeriun.)

Në këtë rast, argumentoi ChatGPT, kjo nuk ju dha përgjigjen e duhur - por ju afroi më shumë me përqindjen që dëshironit sesa ishit më parë! Kjo është shumë qesharake.

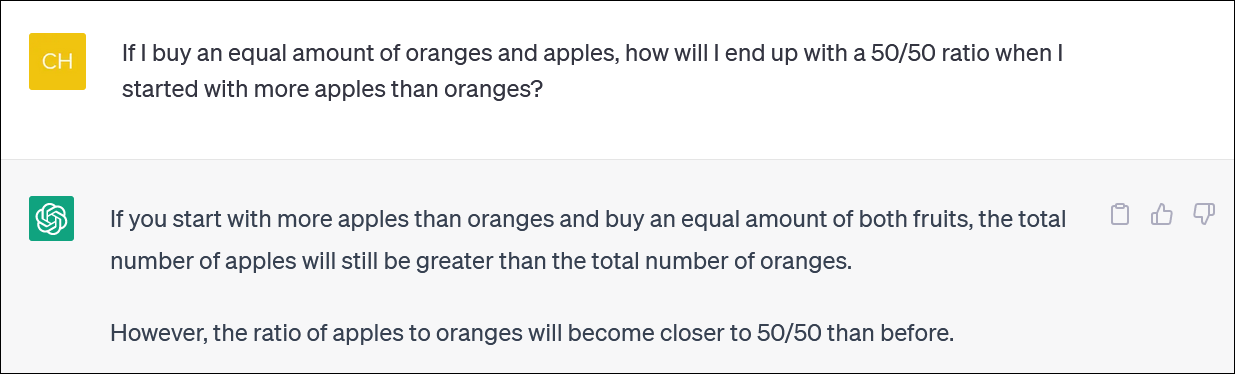

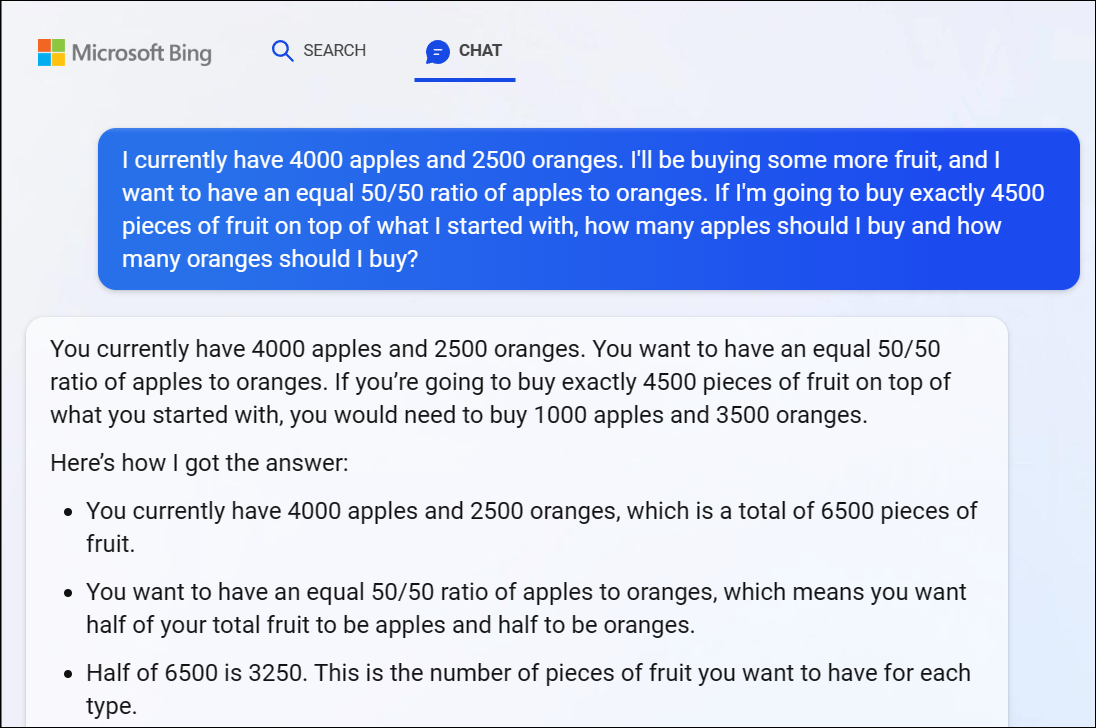

Për rekord, Bing Chat i Microsoft i bazuar në GPT 4 gjithashtu luftoi me këtë çështje, duke na dhënë një përgjigje dukshëm të pasaktë. Logjika GPT 4 fillon shpejt edhe këtu.

Ne rekomandojmë të mos përpiqeni të ndiqni çdo kthesë dhe kthesë të logjikës - përgjigja është qartësisht e pasaktë.

Kur theksuam se përgjigjja e Bing ishte e pasaktë, ajo vazhdoi të debatonte me ne në rrethe, duke dhënë përgjigje të gabuar pas përgjigje të gabuar.

As ChatGPT nuk mund të bëjë llogaritë me besueshmëri

Vlen të përmendet se ChatGPT ndonjëherë anashkalohet dhe përmend gabimisht edhe llogarinë kryesore. Ne kemi parë përgjigje logjike për problemet aritmetike të pasakta të ngjashme me 1 + 1 = 3 smack-dab në mes të një përgjigje të arsyetuar mirë.

Sigurohuni që të kontrolloni përsëri dhe të kontrolloni dy herë gjithçka që merrni nga ChatGPT dhe chatbot të tjerë të AI.