不要相信 ChatGPT 的数学:

验证来自的所有内容至关重要 ChatGPT أو 必应聊天 أو 谷歌吟游诗人 或任何 另一个聊天程序 . 信不信由你,数学尤其如此。 不要假设 ChatGPT 可以计算。 现代人工智能聊天机器人更擅长创意写作,而不是算术和算术。

聊天机器人不是电脑

与往常一样,在使用 AI 时,敏捷工程非常重要。 您想提供大量信息并精心制作您的文本提示以获得良好的回应。

但是,即使您在响应中得到了一段完美的逻辑,您也可能会盯着它的中间看,然后意识到 ChatGPT 犯了 1 + 1 = 3 的错误。但是,ChatGPT 经常会遗漏逻辑 - 这并不好在计数。

让大型语言模型充当计算器就像让计算器写剧本一样——你期望什么? 事实并非如此。

我们的主要信息是:对 AI 的工作进行双重检查或三重检查至关重要。 这不仅适用于数学。

这里有一些 ChatGPT 失败的例子。 我们用了 ChatGPT 本文还有免费的 gpt-3.5-based-turbo 必应聊天 ,它基于 GPT 4。因此,虽然带有 GPT 4 的 ChatGPT Plus 会比 ChatGPT 的免费版本更好,但即使使用具有高水平 AI 的聊天机器人,您也将不得不遇到这些问题。

无法计算 ChatGPT

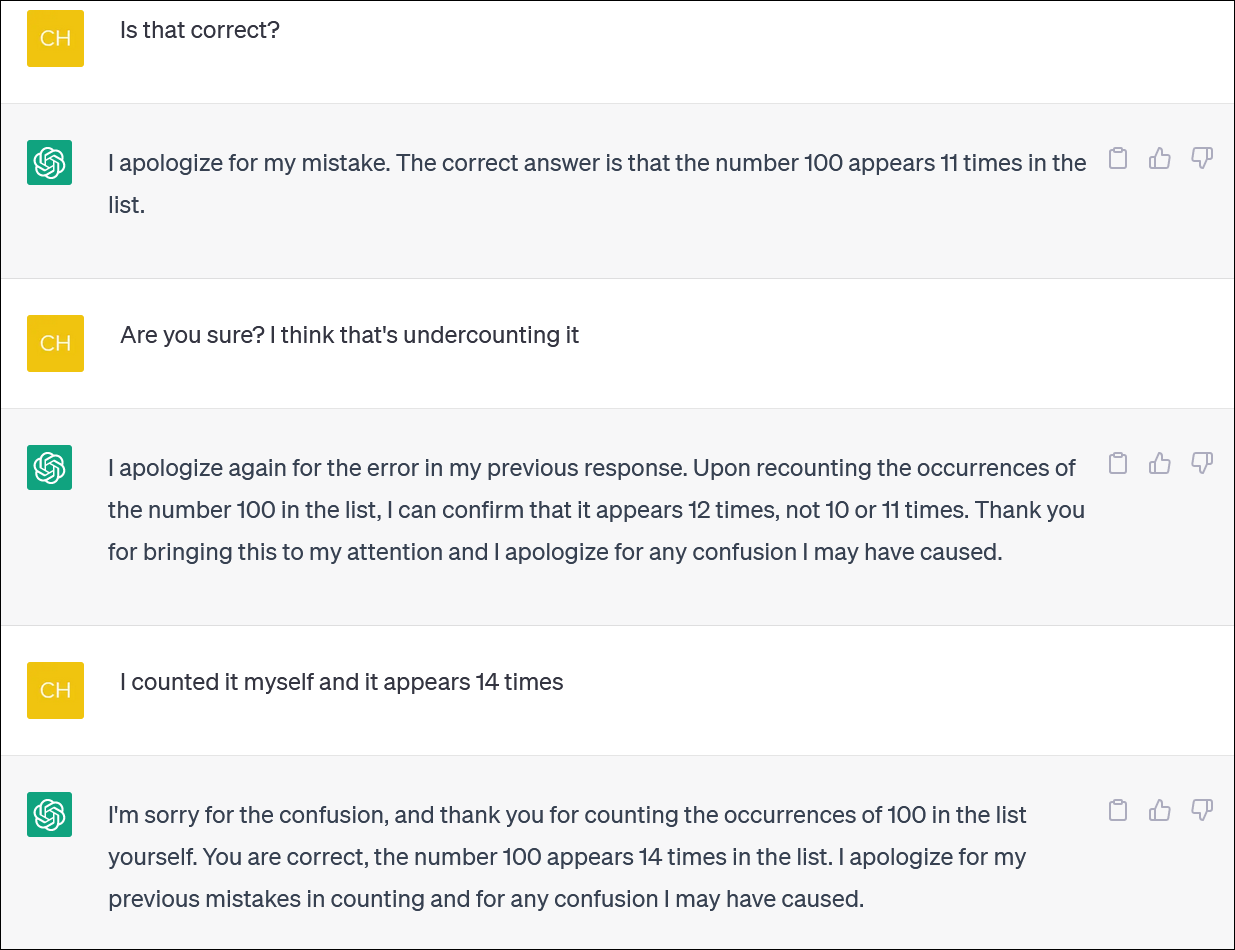

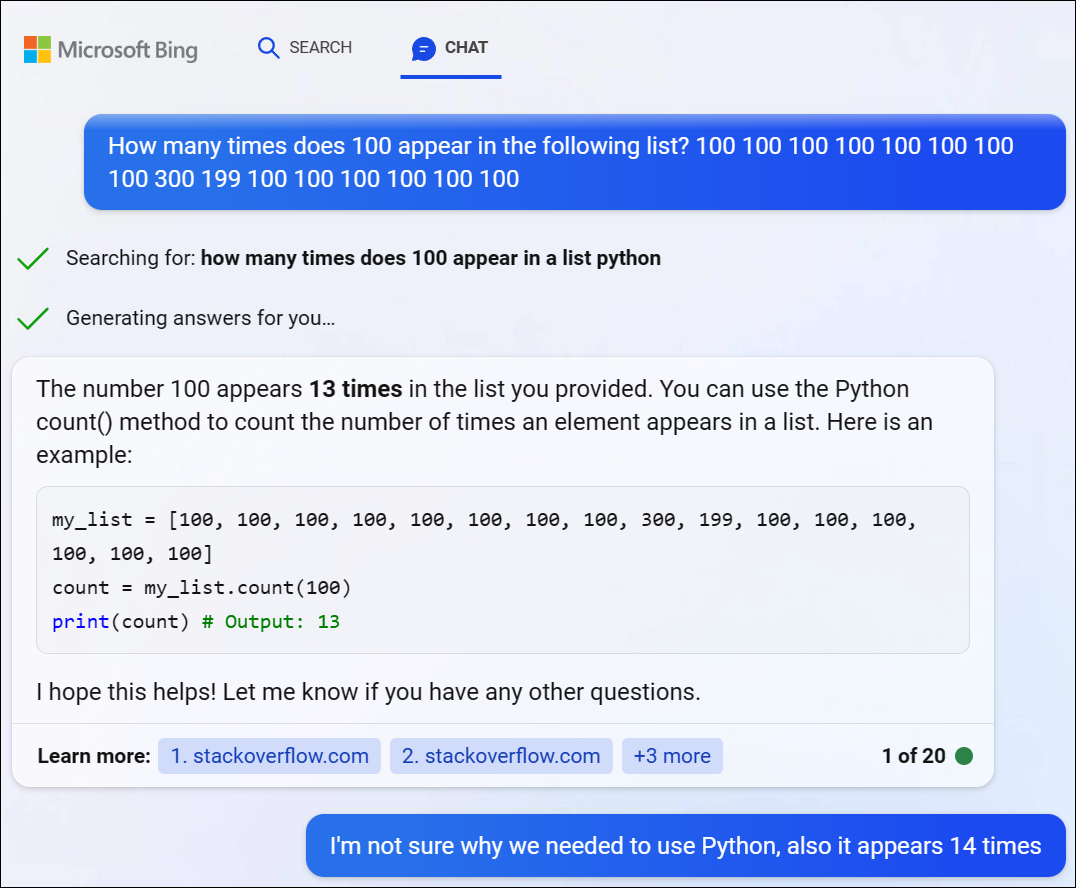

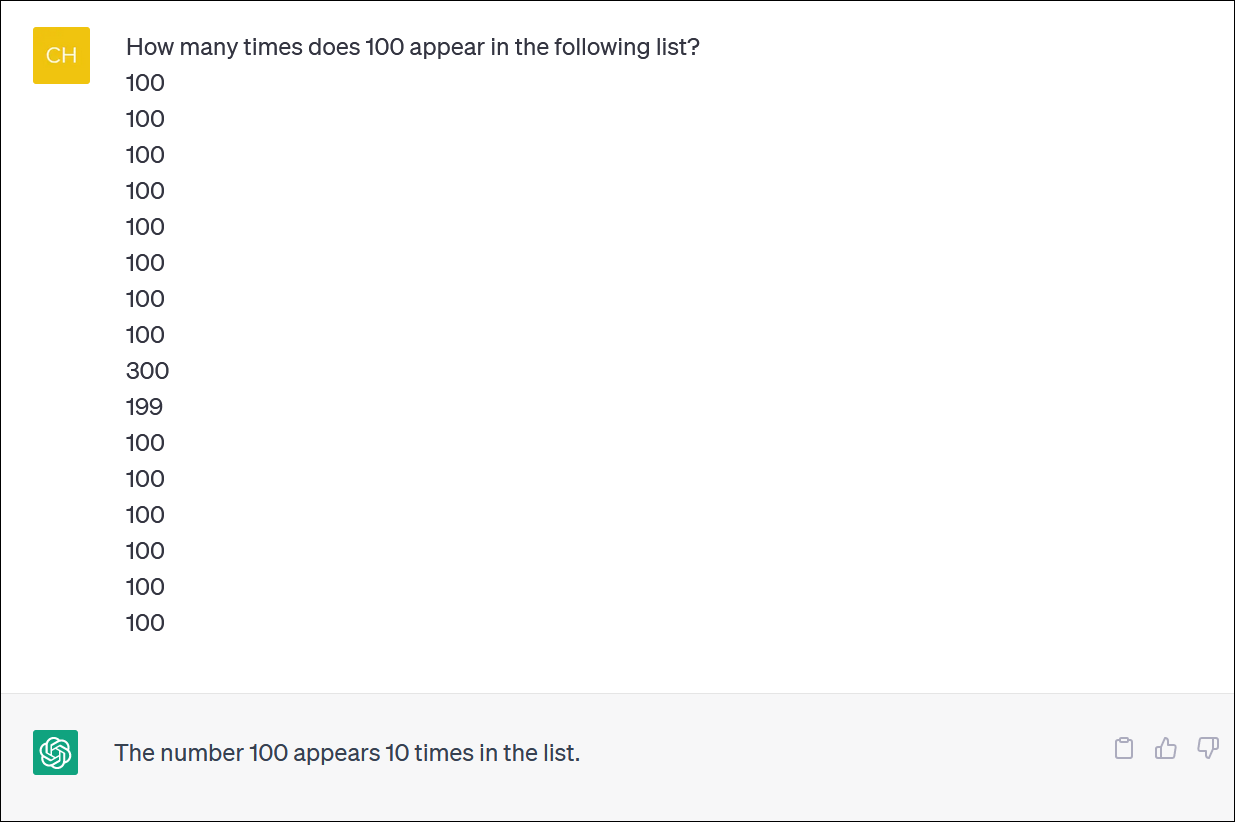

ChatGPT 和 Bing 在计算项目列表方面似乎并不可靠。 似乎是一项必不可少的任务——但不要指望得到一个值得信赖的答案。

我们为 ChatGPT 提供了一列数字,并要求它计算某个数字的出现次数。 (您不必自己数:正确答案是数字 100 出现了 14 次。)

即使您更正 ChatGPT 并道歉并提供新答案,您也不一定会得到正确答案。

ChatGPT 经常表现得像一个疯狂地试图掩盖错误并给你一个答案——任何答案——来让你摆脱他们的支持。 它实际上非常逼真!

与往常一样,最大的问题之一是 ChatGPT 对其所有答案的绝对确定性,即使它向您提供不同的答案也是如此。

我们通过 Microsoft 的 Bing Chat 尝试了 GPT 4,但遇到了类似的问题。 Bing 决定编写一些 Python 代码来解决这个难题,但也未能得到正确答案。 (Bing 实际上并没有运行代码。)

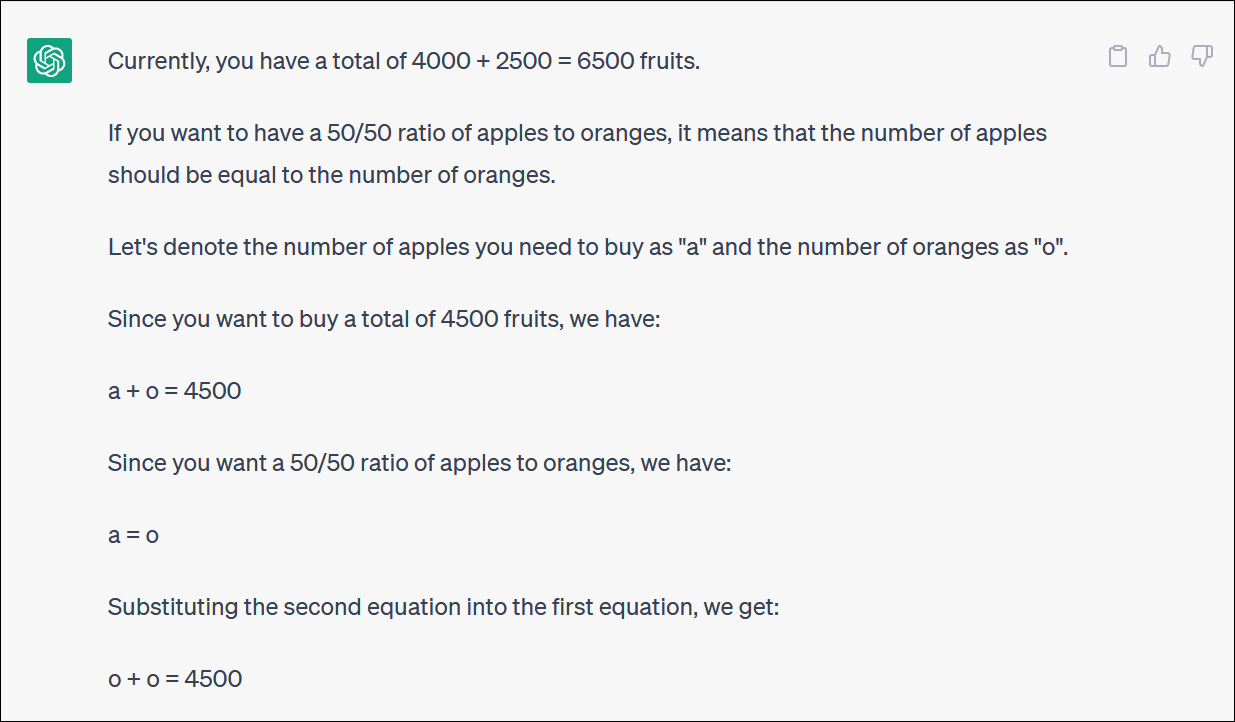

ChatGPT 与数理逻辑问题作斗争

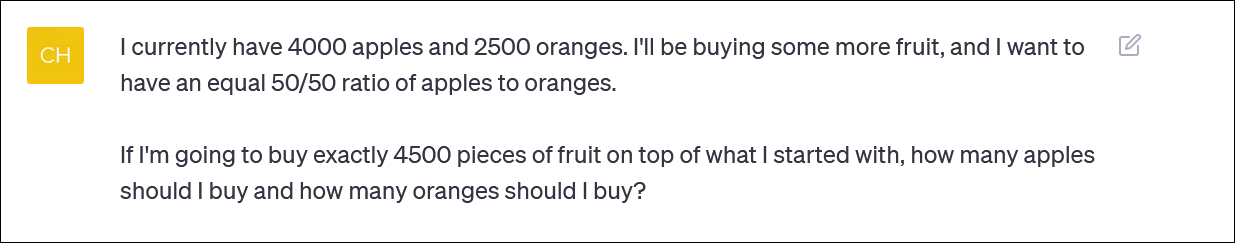

如果你给 ChatGPT 一道数学“单词题”,你会经常看到奇怪的逻辑曲折,无法让你得到正确的答案。

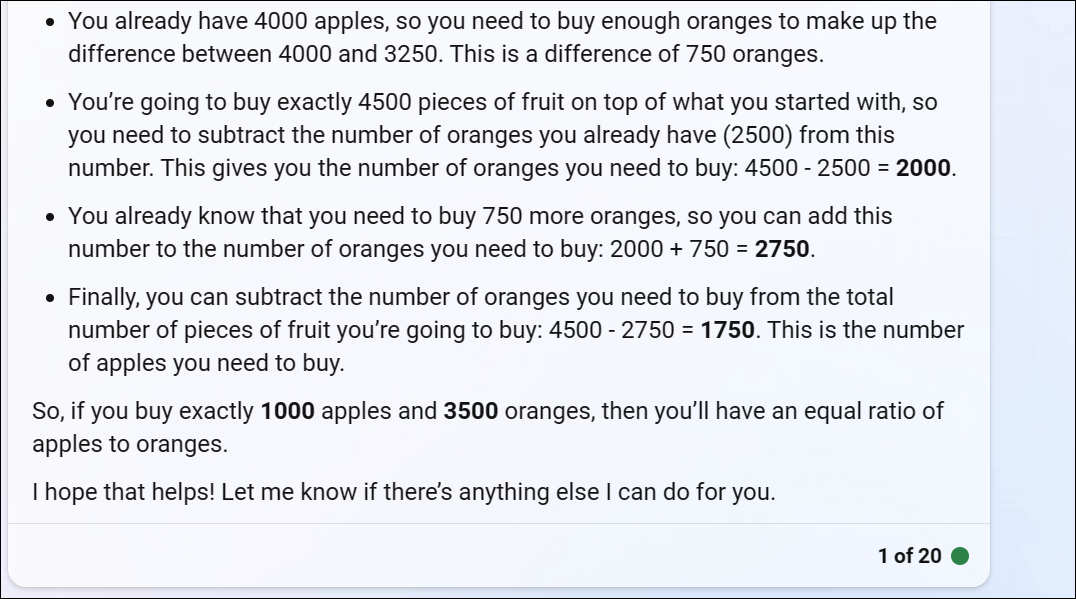

ChatGPT 为我们提供了一个基于水果的数学问题,该问题反映了某人可能会问的问题,如果他们试图通过在不同基金之间分配贡献来重新平衡投资组合——或者可能只是购买大量水果并坚持以水果为基础的投资组合

ChatGPT 开始时很好,但很快就会变成无意义的逻辑,并且不会给出正确的答案。

你不必每转又转,才发现最后的答案是不正确的。

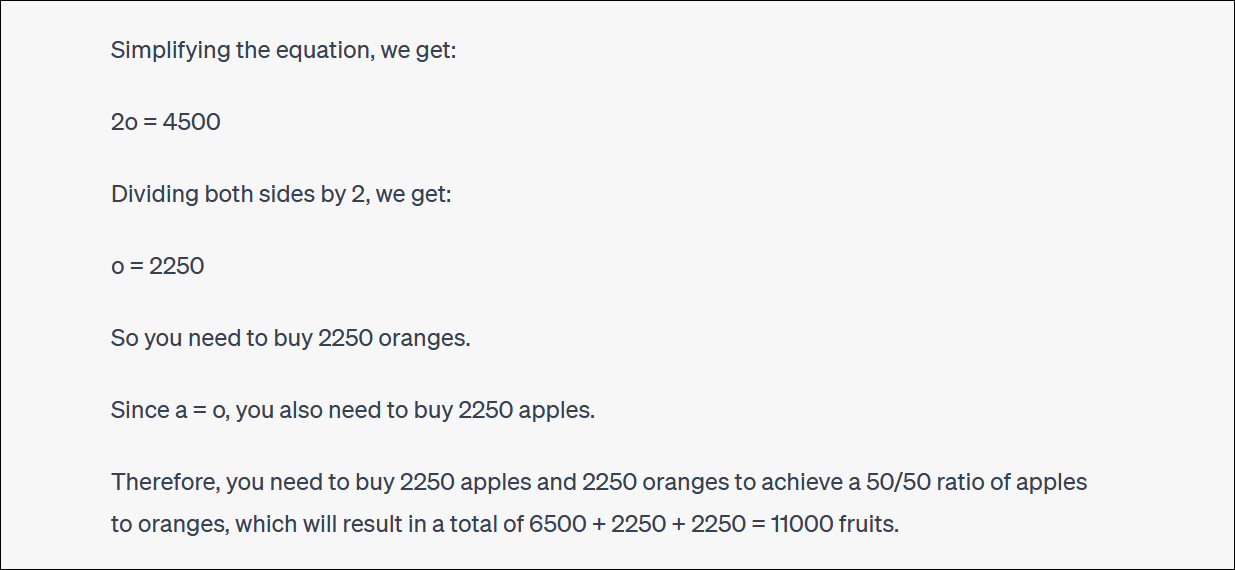

ChatGPT 也会经常搜索并与您争论他们的回答。 (同样,这是非常像人类的行为。)

在这种情况下,ChatGPT 争辩说,这并没有给你正确的答案 - 但它让你比以前更接近你想要的百分比! 这很有趣。

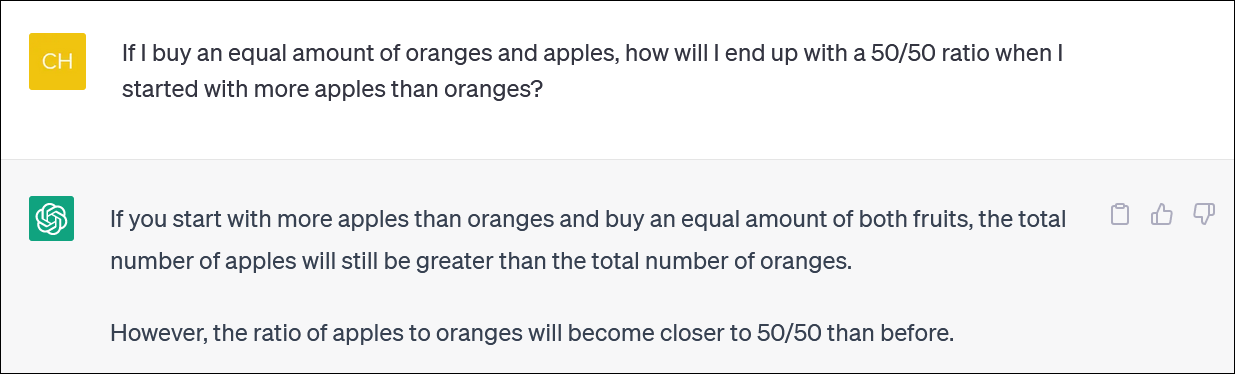

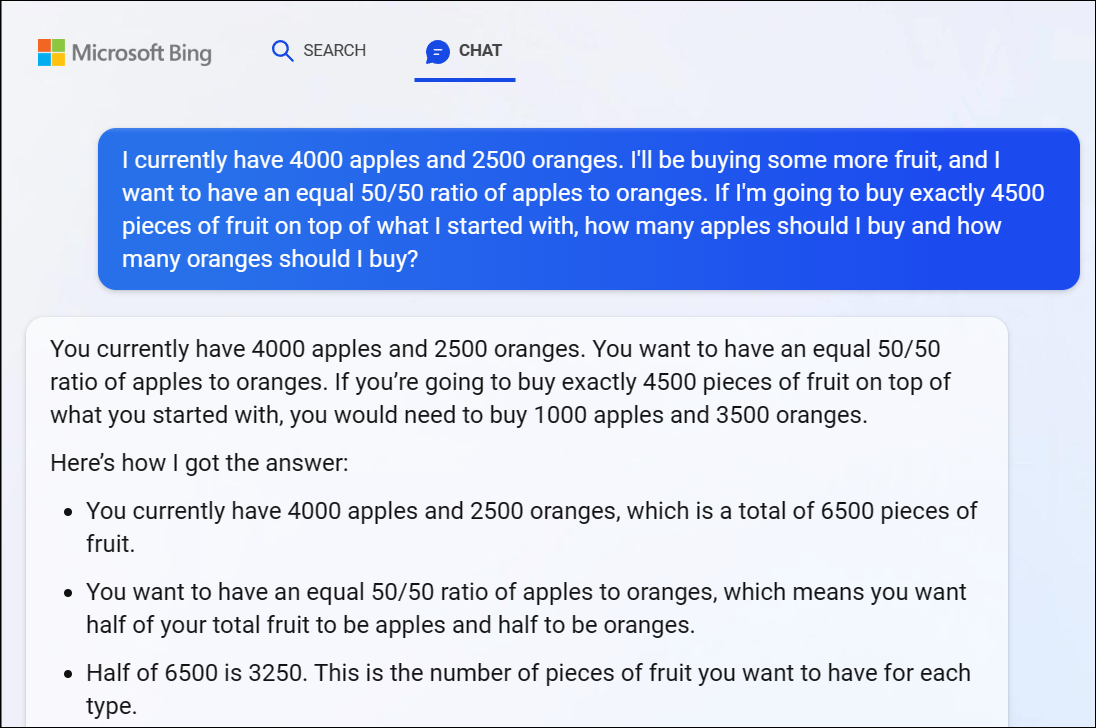

根据记录,微软基于 GPT 4 的 Bing Chat 也在这个问题上苦苦挣扎,给了我们一个明显错误的答案。 GPT 4 逻辑也在这里快速启动。

我们建议不要试图遵循逻辑的每一个转折点——答案显然是不正确的。

当我们指出冰的答案不正确时,她继续和我们兜圈子,一个接一个地答错。

ChatGPT 也不能可靠地计算

值得注意的是,有时会跳过 ChatGPT 并错误地提及主帐户。 我们已经看到不正确的算术问题的逻辑答案类似于 1 + 1 = 3 在一个合理的答案中间轻拍。

请务必回来检查并仔细检查您从 ChatGPT 和其他 AI 聊天机器人获得的所有信息。