อย่าเชื่อถือ ChatGPT สำหรับคณิตศาสตร์:

สิ่งสำคัญคือต้องตรวจสอบทุกอย่างที่มาจาก ChatGPT أو บิงแชต أو กวี Google หรืออะไรก็ได้ อีกหนึ่งโปรแกรมแชท . เชื่อหรือไม่ว่า นี่เป็นเรื่องจริงโดยเฉพาะในวิชาคณิตศาสตร์ อย่าถือว่า ChatGPT สามารถคำนวณได้ แชทบอท AI สมัยใหม่นั้นเก่งด้านการเขียนเชิงสร้างสรรค์มากกว่าด้านเลขคณิตและเลขคณิต

Chatbots ไม่ใช่คอมพิวเตอร์

เช่นเคย เมื่อทำงานกับ AI วิศวกรรมที่คล่องตัวเป็นสิ่งสำคัญ คุณต้องการให้ข้อมูลจำนวนมากและสร้างข้อความแจ้งของคุณอย่างรอบคอบเพื่อให้ได้รับการตอบกลับที่ดี

แต่แม้ว่าคุณจะได้รับตรรกะที่ไร้ที่ติในการตอบกลับ คุณอาจจ้องมองตรงกลางและตระหนักว่า ChatGPT ทำข้อผิดพลาดตามบรรทัด 1 + 1 = 3 อย่างไรก็ตาม ChatGPT มักจะขาดตรรกะ - และมันก็ไม่ดี ในการนับด้วย

การขอให้โมเดลภาษาขนาดใหญ่ทำหน้าที่เป็นเครื่องคิดเลขก็เหมือนกับการขอให้เครื่องคิดเลขเขียนบทละคร คุณคาดหวังอะไร นั่นไม่ใช่สิ่งที่เป็น

ข้อความหลักของเราที่นี่: การตรวจสอบการทำงานของ AI อีกครั้งหรือสามครั้งเป็นสิ่งสำคัญอย่างยิ่ง สิ่งนี้ใช้ได้กับมากกว่าคณิตศาสตร์

นี่คือตัวอย่างบางส่วนของ ChatGPT ที่แบนราบ เราใช้ ChatGPT gpt-3.5-based-turbo ฟรีสำหรับบทความนี้เช่นกัน บิงแชต ซึ่งอิงตาม GPT 4 ดังนั้น แม้ว่า ChatGPT Plus ที่มี GPT 4 จะดีกว่าเวอร์ชันฟรีของ ChatGPT คุณจะต้องประสบปัญหาเหล่านี้แม้ว่าจะใช้แชทบอทที่มี AI ระดับสูงก็ตาม

ไม่สามารถคำนวณ ChatGPT ได้

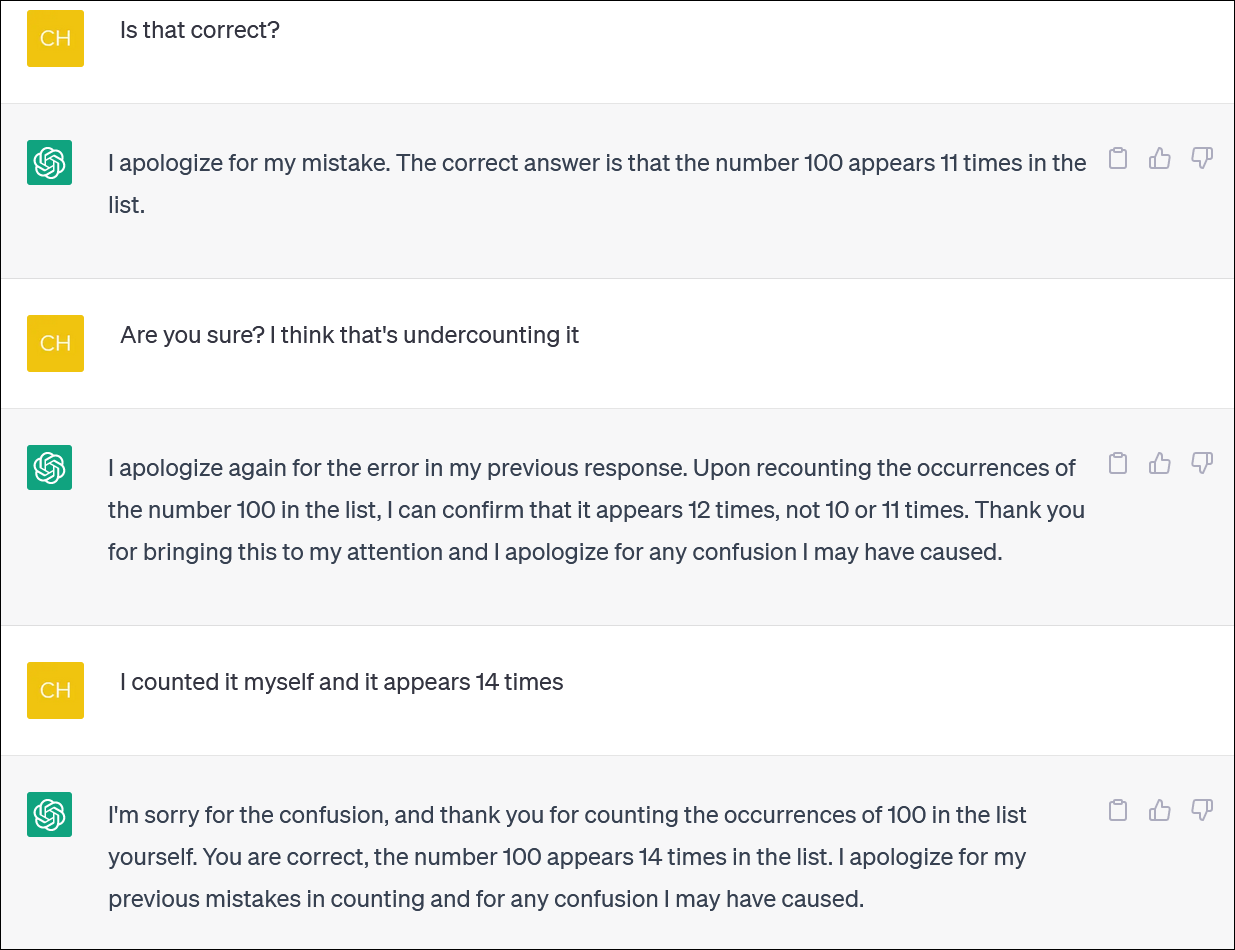

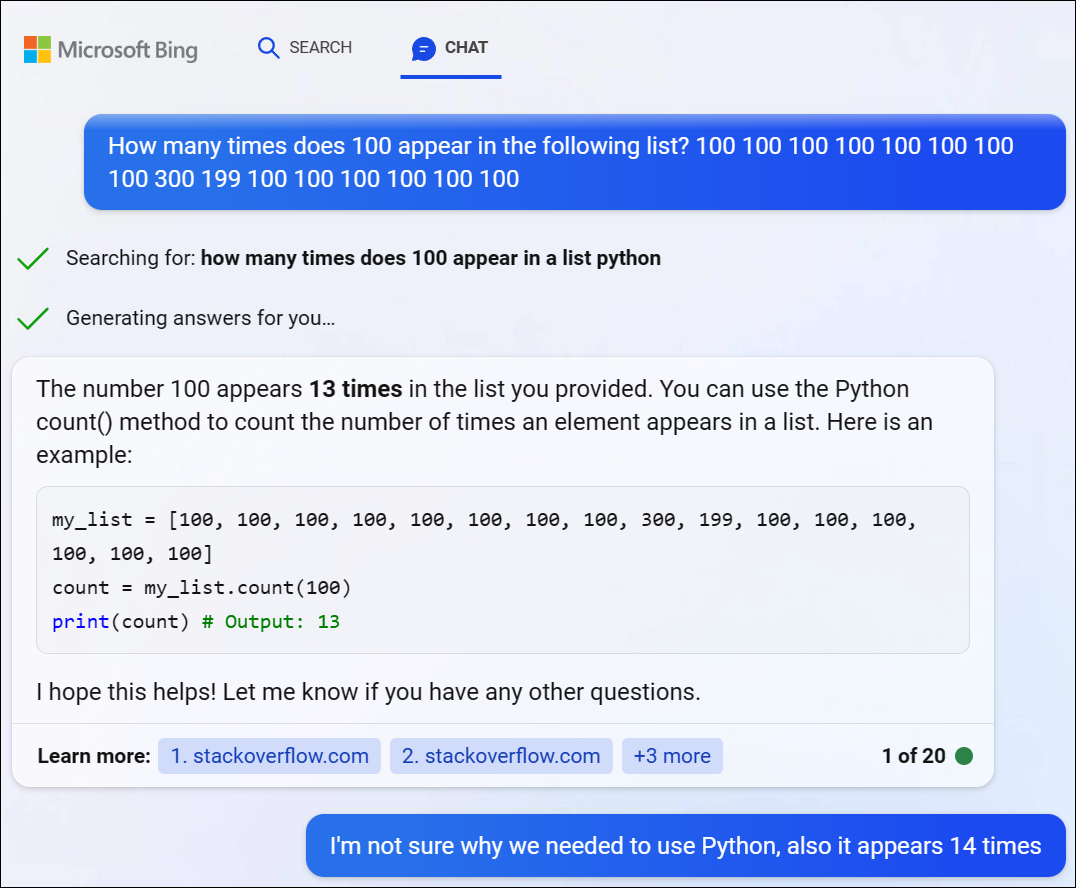

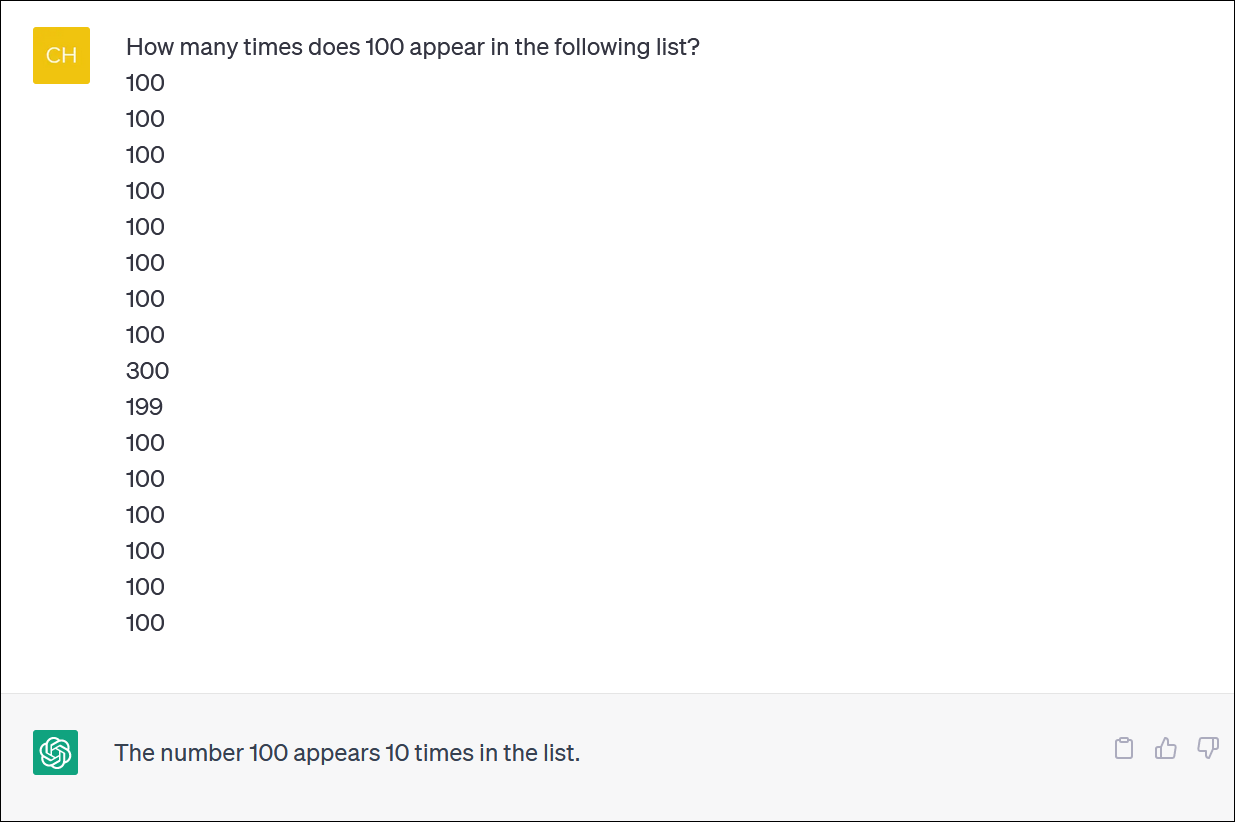

ChatGPT และ Bing ดูเหมือนจะไม่น่าเชื่อถือสำหรับการคำนวณรายการ ดูเหมือนเป็นงานสำคัญ แต่อย่าพึ่งได้รับคำตอบที่น่าเชื่อถือ

เราจัดเตรียมคอลัมน์ตัวเลขให้ ChatGPT และขอให้นับจำนวนที่เกิดขึ้น (คุณไม่ต้องนับเอง คำตอบที่ถูกต้องคือ เลข 100 ปรากฏ 14 ครั้ง)

แม้ว่าคุณจะแก้ไข ChatGPT และขอโทษ และให้คำตอบใหม่ คุณไม่จำเป็นต้องได้รับคำตอบที่ถูกต้องเสมอไป

ChatGPT มักจะทำตัวเหมือนใครบางคนพยายามปกปิดข้อผิดพลาดอย่างเมามันและให้คำตอบแก่คุณ - คำตอบใดก็ได้ - เพื่อให้คุณเลิกสนใจ มันเหมือนจริงมาก!

ตามปกติแล้ว ปัญหาใหญ่ประการหนึ่งคือความแน่ใจอย่างยิ่งของ ChatGPT เกี่ยวกับคำตอบทั้งหมด แม้ว่าจะให้คำตอบที่แตกต่างกันกับคุณก็ตาม

เราลองใช้ GPT 4 ผ่าน Bing Chat จาก Microsoft และพบปัญหาที่คล้ายกัน Bing ตัดสินใจเขียนโค้ด Python เพื่อแก้ปัญหาที่ยากนี้ แต่ก็ล้มเหลวในการรับคำตอบที่ถูกต้อง (Bing ยังไม่ได้รันโค้ดจริงๆ)

ChatGPT ต่อสู้กับปัญหาตรรกะทางคณิตศาสตร์

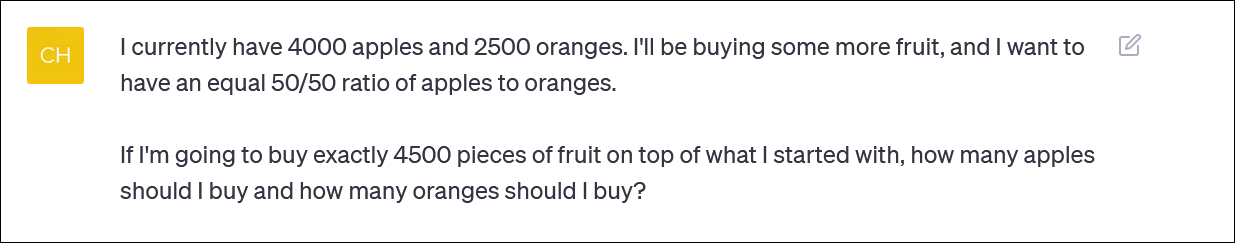

หากคุณให้ ChatGPT เป็น "ปัญหาคำศัพท์" ในวิชาคณิตศาสตร์ คุณมักจะเห็นการหักมุมแปลกๆ ของตรรกะซึ่งจะทำให้คุณไม่ได้คำตอบที่ถูกต้อง

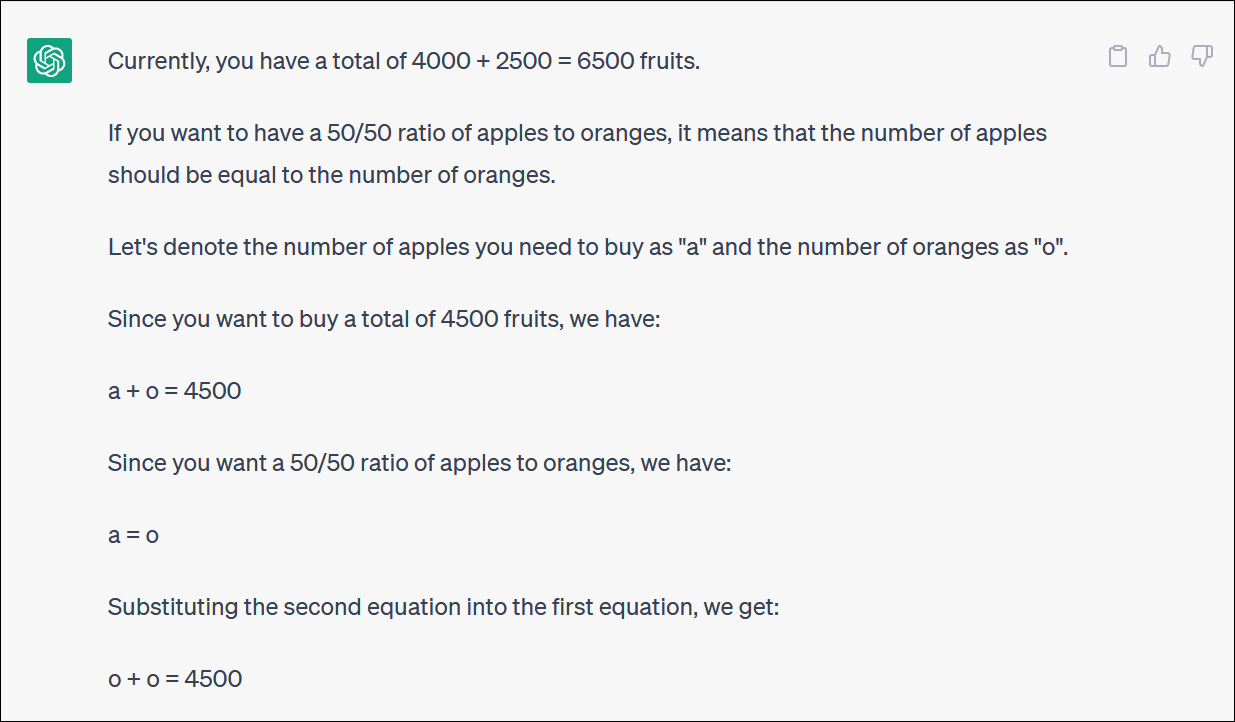

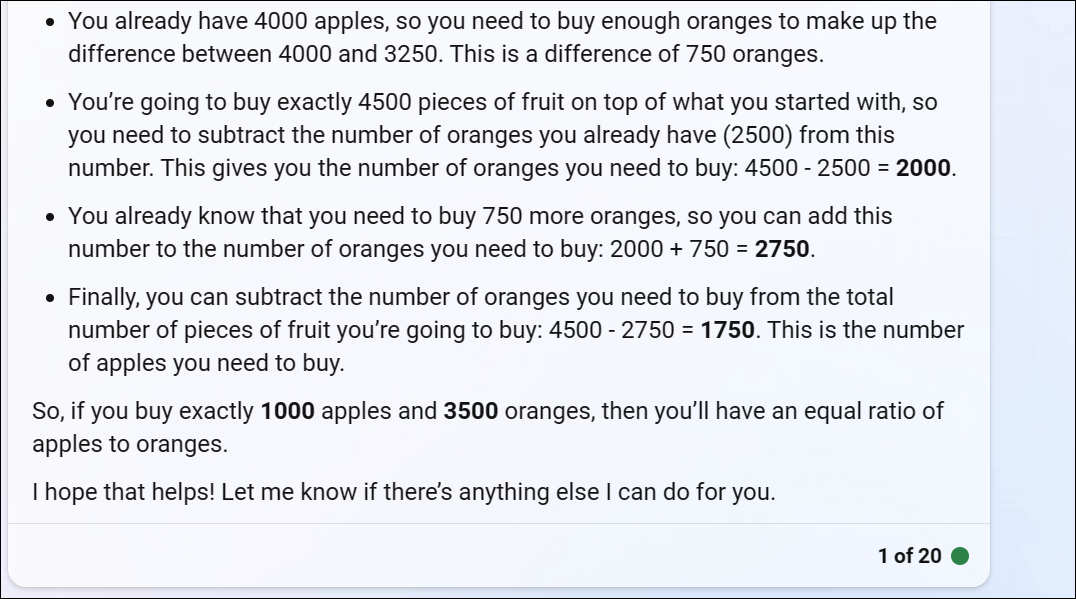

ChatGPT ให้โจทย์คณิตศาสตร์เกี่ยวกับผลไม้แก่เรา ซึ่งสะท้อนถึงสิ่งที่บางคนอาจถามว่าพวกเขาพยายามปรับสมดุลพอร์ตการลงทุนด้วยการจัดสรรเงินสมทบระหว่างกองทุนต่างๆ หรือไม่ หรืออาจเพียงแค่ซื้อผลไม้จำนวนมากและยึดติดกับพอร์ตโฟลิโอตามผลไม้

ChatGPT เริ่มต้นได้ดี แต่กลายเป็นตรรกะไร้สาระอย่างรวดเร็วและจะไม่ให้คำตอบที่ถูกต้อง

คุณไม่จำเป็นต้องทำตามทุกรอบแล้วรอบเล่าเพื่อตระหนักว่าคำตอบสุดท้ายนั้นไม่ถูกต้อง

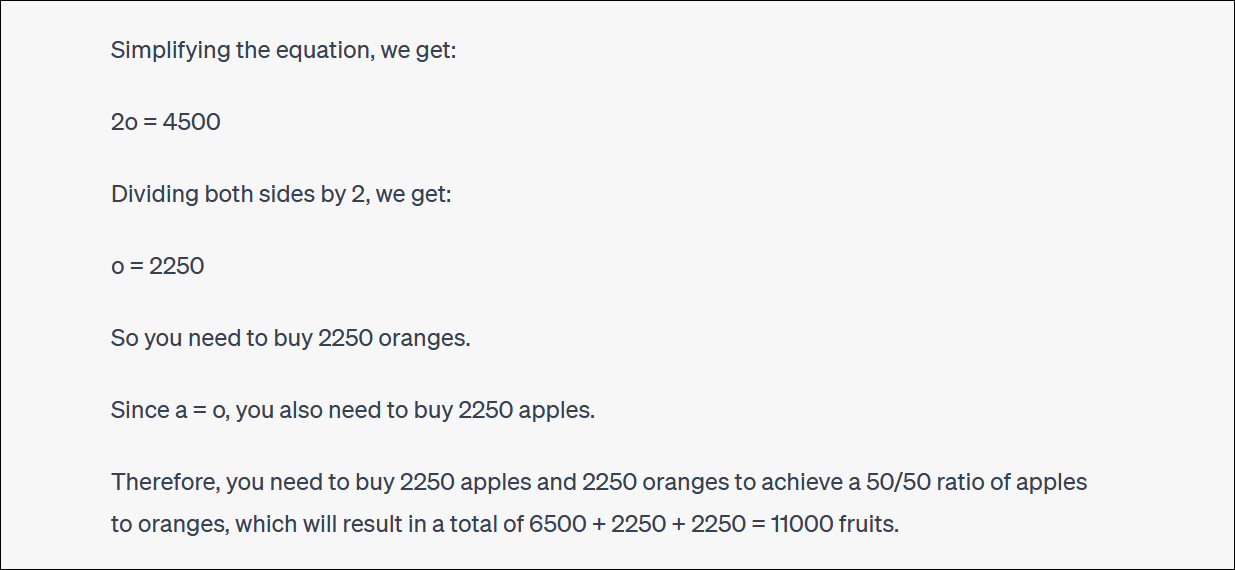

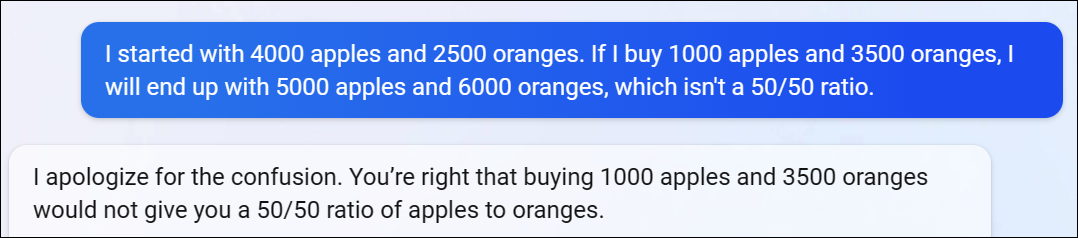

ChatGPT มักจะค้นหาและโต้แย้งกับคุณเกี่ยวกับคำตอบของพวกเขาเช่นกัน (นี่เป็นพฤติกรรมที่เหมือนมนุษย์มาก)

ในกรณีนี้ ChatGPT แย้งว่าสิ่งนี้ไม่ได้ให้คำตอบที่ถูกต้องแก่คุณ - แต่ทำให้คุณเข้าใกล้เปอร์เซ็นต์ที่คุณต้องการมากกว่าที่เคยเป็นมา! มันตลกมาก

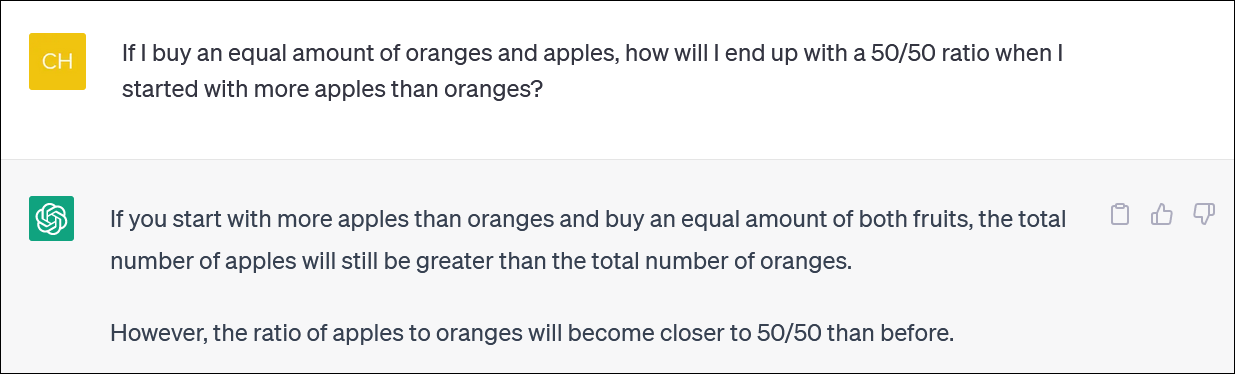

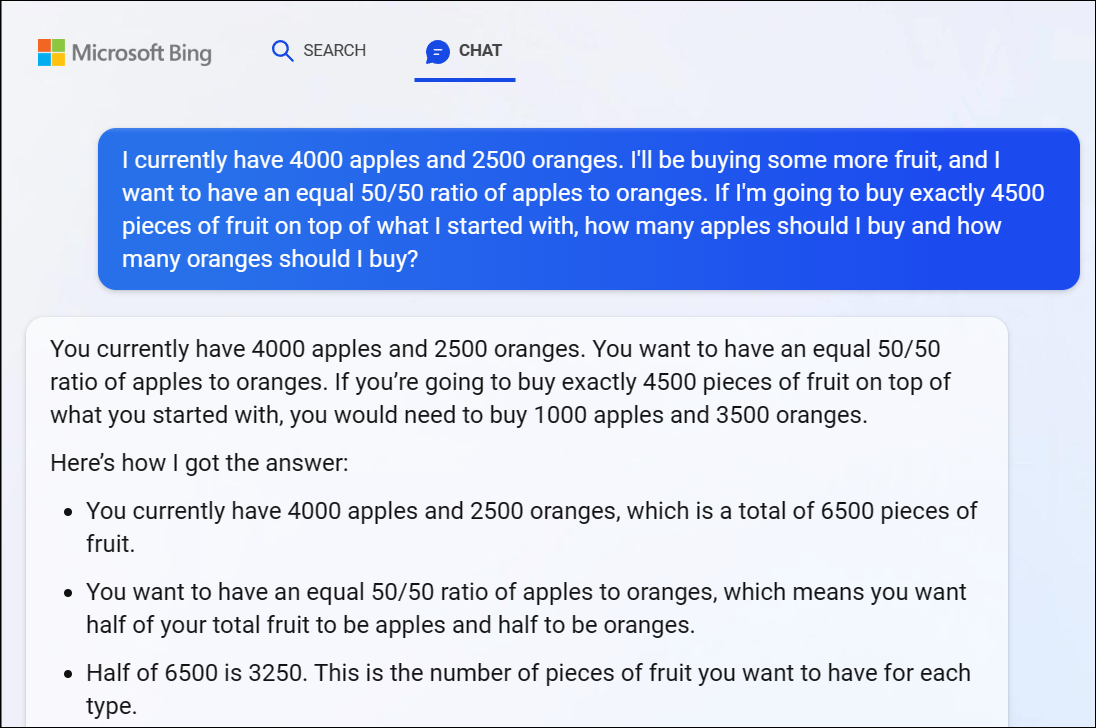

สำหรับบันทึก Bing Chat ของ Microsoft ที่ใช้ GPT 4 ก็ประสบปัญหานี้เช่นกัน ทำให้เราได้คำตอบที่ไม่ถูกต้องอย่างเห็นได้ชัด ตรรกะ GPT 4 เริ่มทำงานที่นี่อย่างรวดเร็วเช่นกัน

เราขอแนะนำว่าอย่าพยายามทำตามทุกตรรกะที่บิดเบี้ยว - คำตอบนั้นไม่ถูกต้องอย่างชัดเจน

เมื่อเราชี้ว่าคำตอบของ Bing ไม่ถูกต้อง เธอยังคงโต้เถียงกับเราเป็นวงกลม โดยตอบผิดแล้วตอบผิด

ChatGPT ไม่สามารถคำนวณทางคณิตศาสตร์ได้อย่างน่าเชื่อถือเช่นกัน

เป็นที่น่าสังเกตว่าบางครั้ง ChatGPT จะถูกข้ามและกล่าวถึงบัญชีหลักอย่างไม่ถูกต้องเช่นกัน เราได้เห็นคำตอบเชิงตรรกะสำหรับปัญหาทางคณิตศาสตร์ที่ไม่ถูกต้องซึ่งคล้ายกับ 1 + 1 = 3 ตบเบา ๆ ท่ามกลางคำตอบที่มีเหตุผล

อย่าลืมกลับมาตรวจสอบอีกครั้งและตรวจสอบทุกสิ่งที่คุณได้รับจาก ChatGPT และแชทบอท AI อื่นๆ